本文主要是介绍大模型主流微调训练方法总结 LoRA、Adapter、Prefix-tuning、P-tuning、Prompt-tuning 并训练自己的数据集,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

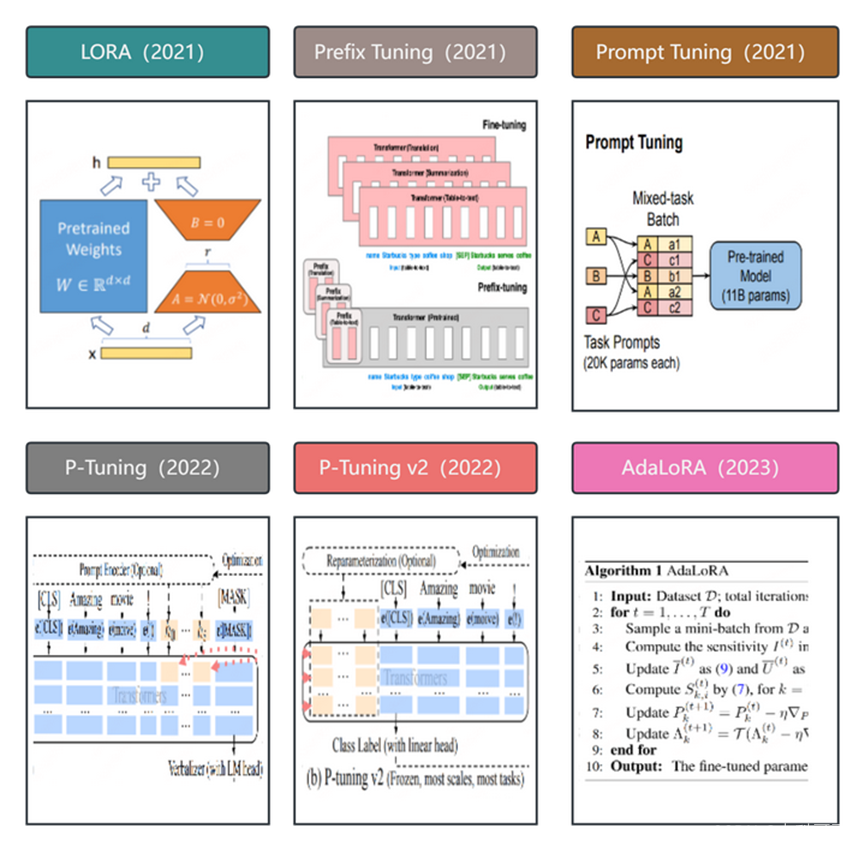

大模型主流微调训练方法总结

LoRA、Adapter、Prefix-tuning、P-tuning、Prompt-tuning

概述

大模型微调(finetuning)以适应特定任务是一个复杂且计算密集型的过程。本文训练测试主要是基于主流的的微调方法:LoRA、Adapter、Prefix-tuning、P-tuning和Prompt-tuning,并对它们进行总结。

LoRA (Learned Representations for Finetuning)

LoRA是一种新型的微调方法,旨在解决预训练模型微调过程中存在的两大问题,模型调整过程中对初始模型过度依赖以及微调过程中存在的过拟合问题。LoRA通过在预训练模型中引入一个额外的线性层,并使用特定任务的训练数据来微调这个线性层。这种方法使模型能够更好地适应特定任务,同时减少了对初始模型的过度依赖。

Adapter

Adapter是一种简单而有效的微调方法,它通过在预训练模型的特定层上添加一个可学习的附加层来适应特定任务。这个附加层可以是线性层、非线性层或其他类型的层,其目的是对预训练模型的输出进行微调,使其更好地适应特定任务。Adapter具有较低的计算成本和较好的性能,使其成为处理小数据集的理想选择。

Prefix-tuning

Prefix-tuning方法通过微调预训练模型的特定部分(称为“前缀”)以适应特定任务。这种方法只微调前缀,而不是整个模型,从而减少了计算成本和过拟合的风险。Prefix-tuning的性能通常优于传统的微调方法,但不及完整的模型微调。

P-tuning

P-tuning是一种改进的微调方法,通过引入一个参数化转换矩阵来调整预训练模型的权重。这个矩阵可以学习地改变预训练模型的权重分布,使其更好地适应特定任务。P-tuning在保持良好性能的同时,减少了微调过程中对初始模型的过度依赖。

Prompt-tuning

Prompt-tuning是一种新颖的微调方法,利用了近年来自然语言处理领域的prompting技术。该方法通过修改预训练模型的输入来适应特定任务,使其在输入阶段就考虑到任务的特定需求。Prompt-tuning可以显著提高模型的性能,同时减少了对初始模型的过度依赖和过拟合的风险。

总结:

这五种微调方法在处理大型预训练模型以适应特定任务方面都具有各自的优点和适用场景。LoRA通过引入额外的线性层来减少对初始模型的过度依赖和过拟合问题;Adapter具有较低的计算成本和较好的性能,适用于小数据集;Prefix-tuning只微调预训练模型的前缀,减少了计算成本和过拟合的风险;P-tuning通过引入参数化转换矩阵来调整预训练模型的权重,减少了过度依赖;Prompt-tuning利用prompting技术修改预训练模型的输入,显著提高性能并减少过度依赖和过拟合的风险。在实际应用中,应根据具体任务和数据集选择合适的微调方法。

详述

LoRA

paper:(https://arxiv.org/pdf/2106.09685.pdf)

简介:

自然语言处理目前存在一个重要范式:一般领域数据的大规模预训练,对特定任务或领域的适应(finetune)。但是随着预训练语言模型越来越大,这个范式存在以下问题:

● 当我们finetune大模型时,由于训练成本太高,不太可能重新训练所有模型参数

● 以前的方法(论文发表于2021年)都或多或少有其它性能问题,如adapter增加了模型层数,引入了额外的推理延迟;prefix-tuning比较难训练,效果不如直接finetune。

基于上述背景,论文作者得益于前人的一些关于内在维度(intrinsic dimension)的发现:模型是过参数化的,它们有更小的内在维度,模型主要依赖于这个低的内在维度(low intrinsic dimension)去做任务适配。假设模型在任务适配过程中权重的改变量是低秩(low rank)的,由此提出低秩自适应(LoRA)方法,LoRA通过优化适应过程中密集层变化的秩分解矩阵来间接训练神经网络中的一些密集层,同时保持预先训练的权重不变。

方法

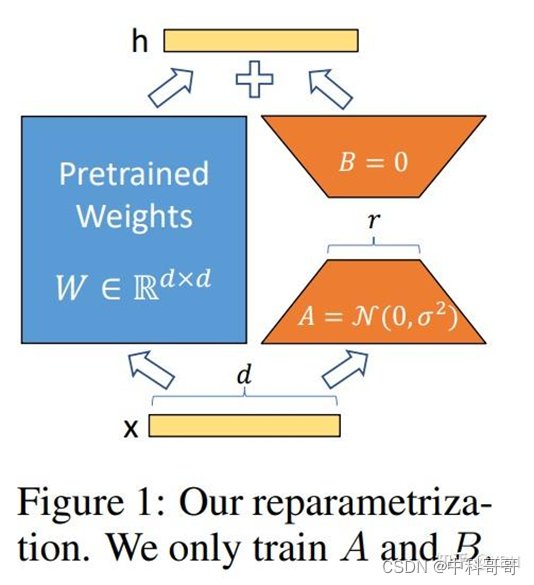

LoRA的实现思想很简单,如下图所示,就是冻结一个预训练模型的矩阵参数,并选择用A和B矩阵来替代,在下游任务时只更新A和B。

结合图片来看,LoRA的实现流程如下:

● 在原始预训练语言模型(PLM)旁边增加一个旁路,做一个降维再升维的操作,来模拟所谓的内在秩。

● 训练的时候固定PLM的参数,只训练降维矩阵A与升维矩阵B。

● 模型的输入输出维度不变,输出时将BA与PLM的参数叠加。

● 用随机高斯分布初始化A,用0矩阵初始化B,保证训练的开始此旁路矩阵依然是0矩阵。

实现

从公式上解释LoRA的实现。假设要在下游任务微调一个预训练语言模型(如GPT3),则需要更新预训练模型参数,公式表示如下:

W0是预训练模型初始化的参数,ΔW就是需要更新的参数。如果是全参数微调,则它的参数量=W0参数量(如果是GPT3,则ΔW≈175B)。从这可以看出要全参数微调大语言模型,没有超级好的显卡群是没法实现的。

由于前人的工作发现预训练的语言模型具有较低的“内部维度(intrinsic dimension)”,在任务适配过程中,即使随机投影到较小的子空间,仍然可以有效地学习。因此,LoRA做的就是增加小参数模块去学习改变量ΔW。

在训练过程中,W0是固定不变的,只有A和B包含训练参数,是变化的。而在推理的过程中,只需要把改变量放回原模型,就不会有任何延迟。如果想切换任务,只需要切换任务的过程中,减去BA,然后换上用其它任务训练好的BʹAʹ就可以了。

总结

基于大模型的内在低秩特性,增加旁路矩阵来模拟full finetuning,LoRA是一个能达成lightweight finetuning的简单有效的方案。目前该技术已经广泛应用于大模型的微调,如Alpaca,stable diffusion+LoRA,而且能和其它参数高效微调方法有效结合

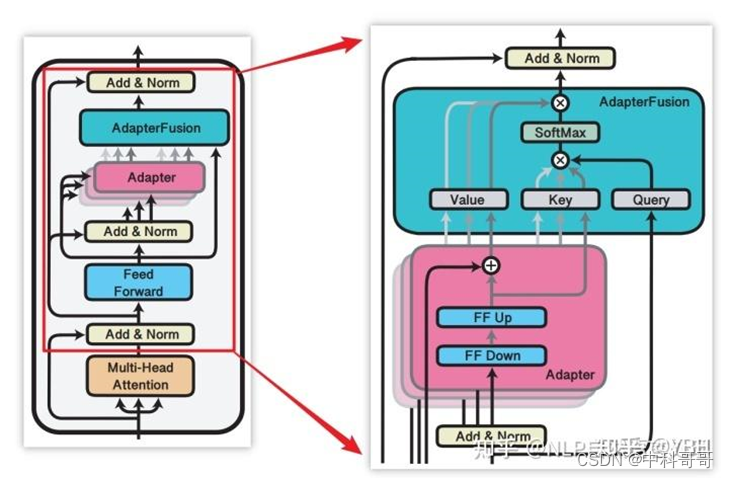

2. Adapter

paper:(https://arxiv.org/pdf/1902.00751.pdf)

简介

2019年,Houlsby N等人将Adapter引入NLP领域,作为全模型微调的一种替代方案。

方法

Adapter主体架构下图所示。

AdapterFusion将学习过程分为两个阶段:

● 1.「知识提取阶段」:训练Adapter模块学习下游任务的特定知识,将知识封装在Adapter模块参数中。

● 2.「知识组合阶段」:将预训练模型参数与特定于任务的Adapter参数固定,引入新参数学习组合多个Adapter中的知识,提高模型在目标任务中的表现。

实现

其中对于N的不同的下游任务训练N个Adapter模块。然后使用AdapterFusion组合N个适配器中的知识,将预训练参数Θ和全部的Adapter参数Φ固定,引入新的参数Ψ,使用N个下游任务的数据集训练,让AdapterFusion学习如何组合N个适配器解决特定任务。参数Ψ在每一层中包含Key、Value和Query(上图右侧架构所示)。

在Transformer每一层中将前馈网络子层的输出作为Query,Value和Key的输入是各自适配器的输出,将Query和Key做点积传入SoftMax函数中,根据上下文学习对适配器进行加权。在给定的上下文中,AdapterFusion学习经过训练的适配器的参数混合,根据给定的输入识别和激活最有用的适配器。「作者通过将适配器的训练分为知识提取和知识组合两部分,解决了灾难性遗忘、任务间干扰和训练不稳定的问题。Adapter模块的添加也导致模型整体参数量的增加,降低了模型推理时的性能」。

总结

Adapter Fusion 在 Adapter 的基础上进行优化,通过将学习过程分为两阶段来提升下游任务表现。作者对全模型微调(Full)、Adapter、AdapterFusion三种方法在各个数据集上进行和对比试验。AdapterFusion在大多数情况下性能优于全模型微调和Adapter,特别在MRPC(相似性和释义任务数据集)与RTE(识别文本蕴含数据集)中性能显著优于另外两种方法

3. Prefix-tuning

Paper:(https://arxiv.org/pdf/2101.00190.pdf)

简介

前缀微调(prefix-tunning),用于生成任

这篇关于大模型主流微调训练方法总结 LoRA、Adapter、Prefix-tuning、P-tuning、Prompt-tuning 并训练自己的数据集的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!