lora专题

浅谈SOC片上系统LoRa-STM32WLE5数据安全防御机制

随着物联网设备的普及,数以亿计的设备正在通过无线网络进行通信,传输大量的敏感数据。这种大规模的设备联网带来了便捷性,但也伴随着巨大的安全风险。SoC片上系统通过将无线通信、处理器、存储和安全机制集成在同一个芯片中,为物联网应用提供了高度集成的解决方案。这种设计大大简化了硬件开发流程,同时提高了设备的整体性能和安全性。SoC不仅能够满足长距离、低功耗的无线通信需求,还能通过先进的加密技术,确保数据在

基于OGC300工业级LORA网关与OM201L数传终端的化工厂人员定位系统解决方案

化工行业作为高风险的行业之一,其安全管理一直备受关注。化工生产过程中涉及到各种危险品和复杂的工艺,一旦发生事故,往往会造成严重的人员伤亡和财产损失。因此,化工企业急需一套可靠的安全管理系统来监测安全隐患、预防事故发生。 在这一背景下,基于先进的LORA自组网技术、BLE高精度定位技术、5G通讯技术、AI图像智能识别技术、云计算与数字孪生技术等前沿技术,北京东用科技提出了一套全新的化工厂人

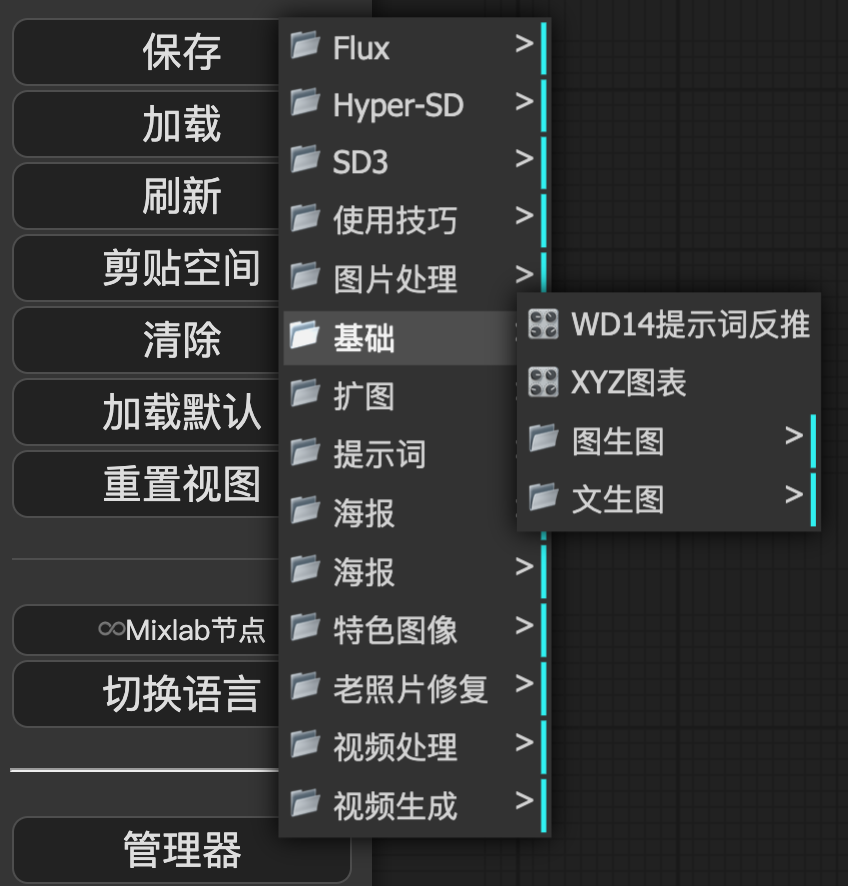

Flux持续火爆,这些LoRA、ControlNet、工作流你值得拥有

大家好,我是每天分享AI应用的萤火君! Flux自发布以来,受到了广大AI绘画爱好者的一致好评,远远的将SD3甩在了脑后,其出图质量媲美Midjourney。而且Flux迭代迅速,接连发布了Flux.1的开发模型和个人模型,其Lora模型、ControlNet模型也迅速推出,社区创作热情高涨。 为了让大家对Flux有一个全面的认识,本文将介绍下Flux基础模型、LoRA模型,以及Control

【LoRa】打开硬件CRC校验功能,但没有起作用?

目录 1 前言2 解析3 结论 1 前言 在使用LoRa模式(非FSK)时,可能遇到明明RX端已经打开CRC校验了,为什么payload错误了,没有报CRC error中断?本章就这个问题展开讲讲,如何正确使用芯片的硬件CRC校验,并延申到CR和payload length的使用。 2 解析 确实存在前言中的现象,前提是使用的explicit header模式,即有heade

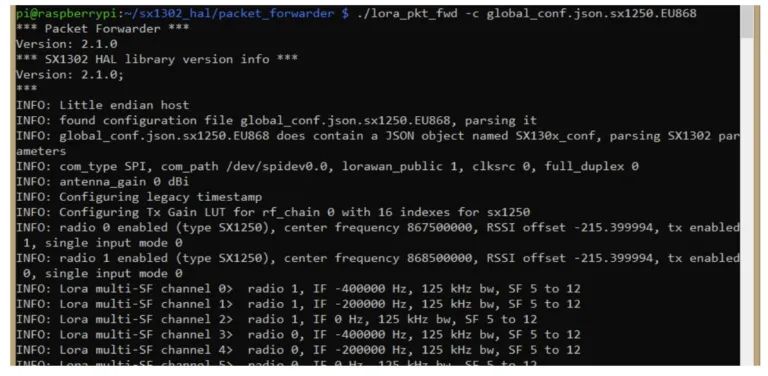

如何使用树莓派构建 LoRa 网关?

顾名思义,远距离广域网或LoRaWAN技术广泛用于物联网(IoT)中的远距离、低功耗通信。 在本文中,我们将指导您如何将SX130x 868M LoRaWAN网关模块通过硬件附加在顶部(HAT)的方式连接到Raspberry Pi4。此设置创建了一个LoRaWAN网关,允许Raspberry Pi(RPi)与启用LoRaWAN的设备进行通信。 所需材料: Raspberry Pi 4(推荐

flux 文生图大模型 自有数据集 lora微调训练案例

参考: https://github.com/ostris/ai-toolkit 目前 Flux 出现了 3 个训练工具 SimpleTuner https://github.com/bghira/SimpleTuner X-LABS 的https://github.com/XLabs-AI/x-flux ai-toolkit https://github.com/ostris/ai-tool

大模型全量微调和LoRA微调详细说明,如何避免灾难性遗忘

在使用大模型进行微调时,特别是在语音识别、自然语言处理等任务中经常会遇到两个主要方法:全量微调和LoRA微调。全量微调涉及更新模型的所有参数,而LoRA(Low-Rank Adaptation)则专注于更新少量的参数来适应新的任务。这两种方法各有优缺点,并有不同的应用场景。 全量微调 1. 什么是全量微调? 全量微调是指在微调阶段,更新模型中所有参数。这个过程通常在大规模数据集上进行,以适应

AI大模型优化技巧:参数高效微调(PEFT)与LoRA微调深度解析

1. Fine-tuning 相较于基础大模型动辄万卡的代价,微调可能是普通个人或者企业少数能够接受的后训练大模型(post-training)的方式。 微调是指在一个预训练模型(pre-training)的基础上,通过少量的数据和计算资源,对模型进行进一步训练,以适应特定的任务或者数据集。 微调分为两种类型:全参微调(full fine-tuning)和参数高效微调(parameter

【LoRa】CAD的工作原理以及使用

目录 1 CAD介绍1.1 CAD工作原理1.2 与CAD有关的中断 2 CAD的使用2.1 CAD总耗时2.2 CAD均衡配置2.3 最优配置速查表 3 CAD的应用3.1 CAD项目使用3.2 CAD扩展应用CSMA 4 参考文献 1 CAD介绍 本章介绍一下LoRa芯片的CAD功能、原理以及如何使用。由于第一代SX127x的CAD使用与以后的芯片有所不同,本章介绍不适用SX

LoRAHUB:通过动态LoRA组合实现高效的跨任务泛化

大模型在微调时面临着计算效率和内存使用上的挑战。为了克服这些问题,研究者们提出了低秩适应(LoRA)技术,通过在模型的每层中引入可训练的低秩分解矩阵作为适配器模块,以参数高效的方式微调LLMs。 尽管LoRA在提高效率方面取得了进展,但关于LoRA模块的内在模块化和可组合性的研究还相对缺乏,来自Sea AI Lab、华盛顿大学圣路易斯分校和艾伦人工智能研究所的研究人员提出的LoRAHUB的新框架

开源模型应用落地-qwen2-7b-instruct-LoRA微调合并-ms-swift-单机单卡-V100(十三)

一、前言 本篇文章将使用ms-swift去合并微调后的模型权重,通过阅读本文,您将能够更好地掌握这些关键技术,理解其中的关键技术要点,并应用于自己的项目中。 二、术语介绍 2.1. LoRA微调 LoRA (Low-Rank Adaptation) 用于微调大型语言模型 (LLM)。 是一种有效的自适应策略,它不会引入额外的推理延迟,并在保持模型质量的同时显着减少下游

【LoRa】SetLoRaSymbNumTimeout寄存器

目录 1 前言2 实验验证疑问2.1 SetRx的timeout模式和SetLoRaSymbNumTimeout2.1.1 实验12.1.2 实验22.1.3 结论 2.2 SetRx的single与continuous模式和SetLoRaSymbNumTimeout2.2.1 实验12.2.2 实验22.2.3 实验3 3 小结 1 前言 本章节介绍LoRa芯片的寄存器Set

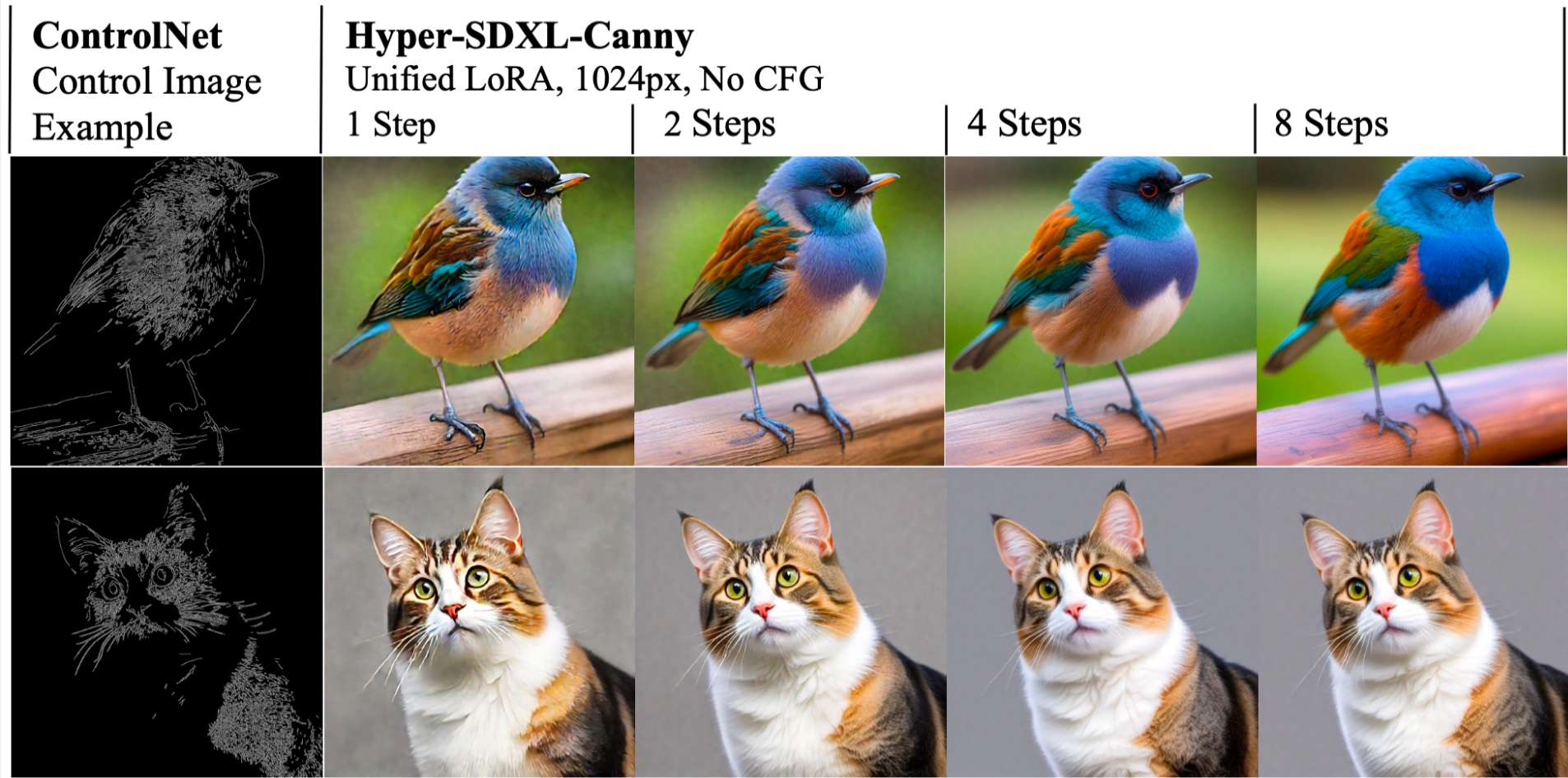

谷歌发布 3 款 Gemini 新模型;字节开源 FLUX Dev Hyper SD Lora,8 步生图丨 RTE 开发者日报

开发者朋友们大家好: 这里是 「RTE 开发者日报」 ,每天和大家一起看新闻、聊八卦。我们的社区编辑团队会整理分享 RTE(Real-Time Engagement) 领域内「有话题的 新闻 」、「有态度的 观点 」、「有意思的 数据 」、「有思考的 文章 」、「有看点的 会议 」,但内容仅代表编辑的个人观点,欢迎大家留言、跟帖、讨论。 本期编辑:@SSN,@鲍勃 01 有话题的新闻

字节开源 FLUX Dev 的 Haper SD Lora,只需要 8 步或者 16 步就可以用 FLUX 生成图片! 文章附模型下载链接

2024 年 8 月 26 日,字节开源了 FLUX Dev 的 Haper SD Lora。 只需要 8 步或者 16 步就可以用 FLUX 生成图片,大幅减少 FLUX 的生成时间。 建议 LoRA 比例约为 0.125,该比例可适应训练和指导,比例可保持在 3.5。较低步骤的 LoRA 即将推出。 大家可以点击下面文章链接, 文章包含模型下载链接,试用地址,项目介绍等,也欢迎大家关注公众

Flux【Lora模型】:微缩版黑悟空,又萌又可爱,必须赞一个

大家好我是极客菌!!! 最近一直使用黑神话的Lora玩Flux 今天我们来看看微缩版的黑神话悟空的效果。仍然使用目前效果最好的Loar:FLUX1-超写实逼真黑悟空 来看看实现的效果。 模型下载地址(需要的同学可自行扫描获取) 触发词:aiyouxiketang 下面是作者推荐的提示词: a man in armor with a beard(一个穿着盔甲,留着胡子的男人) a

大模型全量微调和 LoRA 微调:一看就懂_lora微调

在模型微调领域,全量微调和LoRA微调是我们经常听到的技术术语。 首先,我们需要了解什么是模型微调。模型微调本质上是因为有时我们发现模型在某个方面的性能不足。因此,我们希望通过一些训练方法来更新模型,使更新后的模型在某些方面具有更强的能力。本质上,这是对模型的一种修改。在这里,我们通过数据和基于训练的方法,将现有的模型改造为新模型。 微调的本质 那么模型的修改本质上是对模型参数的修改。因此,

Stable Diffusion【XL Lora】推荐!AI助力服装设计,让服装拆分设计就是这么高效!

今天给大家介绍一个服装饰品分类背景的基于SDXL的Lora模型:分类背景 XUER。该模型是由作者(B站绪儿已成精)炼制,非常适合饰品服装分类背景。绪儿大佬其实推出了很多非常棒的模型,比如之前非常受大家喜欢的敦煌飞天、超梦幻场景等模型。 下面我们来实际体验一下,看使用这个模型出来的图片效果如何吧。 下载链接 https://www.liblib.art/modelinfo/c0

Stable Diffusion【XL Lora】效果太赞了!AI助力服装设计,让服装拆分设计就是这么高效

今天带了一款 非常适合服装设计的SD XL Lora模型——【服装拆分】绪儿 分类背景 XUER,该模型是由绪儿大佬炼制,非常适合饰品服装分类背景。绪儿大佬其实推出了很多非常棒的模型,比如之前非常受大家喜欢的敦煌飞天、超梦幻场景等模型。 那么我们今天一起来看一看这款服饰拆分模型。 Lora模型下载地址: https://www.liblib.art/modelinfo/c0b7a367971

神经网络微调技术全解(01)-不同的微调方法如PEFT、SFT、LoRa、QLoRa等,旨在解决不同的问题和挑战

微调技术在深度学习和大模型的应用中起到了关键作用。不同的微调方法如PEFT、SFT、LoRa、QLoRa等,旨在解决不同的问题和挑战。以下是它们的简介及各自解决的问题。 1. PEFT (Parameter-Efficient Fine-Tuning) 问题:在处理大规模预训练模型时,全面微调所有参数会消耗大量计算资源和存储空间。对于一些特定任务,全面微调可能不必要,并且可能导致过拟合。

开源模型应用落地-qwen2-7b-instruct-LoRA微调模型合并-Axolotl-单机单卡-V100(十)

一、前言 本篇文章将使用Axolotl去合并微调后的模型权重,通过阅读本文,您将能够更好地掌握这些关键技术,理解其中的关键技术要点,并应用于自己的项目中。 二、术语介绍 2.1. LoRA微调 LoRA (Low-Rank Adaptation) 用于微调大型语言模型 (LLM)。 是一种有效的自适应策略,它不会引入额外的推理延迟,并在保持模型质量的同时显着减少下游任

Transformer微调实战:通过低秩分解(LoRA)对T5模型进行微调(LoRA Fine Tune)

scient scient一个用python实现科学计算相关算法的包,包括自然语言、图像、神经网络、优化算法、机器学习、图计算等模块。 scient源码和编译安装包可以在Python package index获取。 The source code and binary installers for the latest released version are available at t

comfyUI工作流-Flux大模型应用/黑神话悟空角色生成(附lora)

是什么让悟空开始搬砖,这莫不是新的副本 其实我们用AI就能生成这种黑神话悟空的衍生图片 让悟空做ceo,做老师,上工地搬砖 七十二变,体验人生百态 操作很简单,只需要一个comfyUI工作流,你就能任意生成黑神话悟空的不同职业图片 前期准备: 确保ComfyUI和Flux大模型已部署 首先,需要确保你的ComfyUI已经部署好了Flux大

FLUX.1 当前支持FLUX.1的Lora模型

首先,我们来梳理一下本次Xlabs-AI团队放出的七款Lora模型,分别是 写实、Furry(但是目前该模型还不支持ComfyUI)、MJV6、动漫、迪斯尼、风景和艺术风格。每种模型都经过精心训练,能够为 Flux 模型带来卓越的风格转换能力。XLabs-AI/flux-lora-collection at main (huggingface.co)Kijai/flux-loras-comfyu

小琳AI课堂:带你了解LoRA模型

🌟 小琳AI课堂:带你深入了解LoRA模型 🚀 大家好,这里是小琳AI课堂,今天我们来聊聊一个在大型语言模型中非常热门的技术——LoRA模型。🤖 🎯 LoRA模型简介 LoRA,全称Low-Rank Adaptation,是一种用于微调大型语言模型(如GPT-3)的高效技术。它通过添加一些可训练的参数来调整模型的权重,而不是直接修改原始模型的权重。这样做的好处是,大大减少了需要训练的

高效管理,LoRa技术赋能农业生产智能化!

随着LoRa无线技术的日益成熟与广泛应用,其在农业生产领域的应用越来越多,主要包括环境监测、温室信息监测、节水灌溉等。通过LoRa无线通信技术对农业环境参数的实时监测与智能控制,为农作物提供一个适宜的生长环境,从而提高农作物的产量和品质,降低生产成本,实现农业生产的智能化、信息化和高效化。 LoRa智慧农业大棚解决方案 漫途LoRa智慧农业大棚解决方案利用LoRa无线通信技术,结合物联网、