gpt专题

4B参数秒杀GPT-3.5:MiniCPM 3.0惊艳登场!

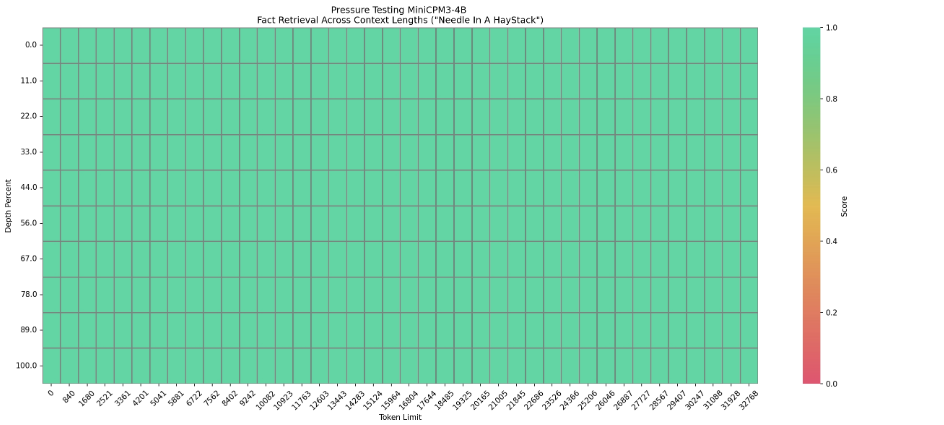

面壁智能 在 AI 的世界里,总有那么几个时刻让人惊叹不已。面壁智能推出的 MiniCPM 3.0,这个仅有4B参数的"小钢炮",正在以惊人的实力挑战着 GPT-3.5 这个曾经的AI巨人。 MiniCPM 3.0 MiniCPM 3.0 MiniCPM 3.0 目前的主要功能有: 长上下文功能:原生支持 32k 上下文长度,性能完美。我们引入了

GPT系列之:GPT-1,GPT-2,GPT-3详细解读

一、GPT1 论文:Improving Language Understanding by Generative Pre-Training 链接:https://cdn.openai.com/research-covers/languageunsupervised/language_understanding_paper.pdf 启发点:生成loss和微调loss同时作用,让下游任务来适应预训

速通GPT-3:Language Models are Few-Shot Learners全文解读

文章目录 论文实验总览1. 任务设置与测试策略2. 任务类别3. 关键实验结果4. 数据污染与实验局限性5. 总结与贡献 Abstract1. 概括2. 具体分析3. 摘要全文翻译4. 为什么不需要梯度更新或微调⭐ Introduction1. 概括2. 具体分析3. 进一步分析 Approach1. 概括2. 具体分析3. 进一步分析 Results1. 概括2. 具体分析2.1 语言模型

MiniCPM-V: A GPT-4V Level MLLM on Your Phone

MiniCPM-V: A GPT-4V Level MLLM on Your Phone 研究背景和动机 现有的MLLM通常需要大量的参数和计算资源,限制了其在实际应用中的范围。大部分MLLM需要部署在高性能云服务器上,这种高成本和高能耗的特点,阻碍了其在移动设备、离线和隐私保护场景中的应用。 文章主要贡献: 提出了MiniCPM-V系列模型,能在移动端设备上部署的MLLM。 性能优越:

OpenAI澄清:“GPT Next”不是新模型。

不,”GPT Next” 并不是OpenAI的下一个重要项目。 本周早些时候,OpenAI 日本业务的负责人长崎忠男在日本 KDDI 峰会上分享了一场演讲,似乎在暗示一个名为 “GPT Next” 的新模型即将出现。 但OpenAI的一位发言人已向Mashable证实,幻灯片中用引号括起来的”GPT Next”一词只是一个假设性占位符,旨在表明OpenAI的模型如何随着时间呈指数级进化。发言人

AI跟踪报道第55期-新加坡内哥谈技术-本周AI新闻: GPT NEXT (x100倍)即将在2024推出

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/ 点击下面视频观看在B站本周AI更新: B 站 链接 观看: 本周AI

什么是GPT-3的自回归架构?为什么GPT-3无需梯度更新和微调

文章目录 知识回顾GPT-3的自回归架构何为自回归架构为什么架构会影响任务表现自回归架构的局限性与双向模型的对比小结 为何无需梯度更新和微调为什么不需要怎么做到不需要 🍃作者介绍:双非本科大四网络工程专业在读,阿里云专家博主,专注于Java领域学习,擅长web应用开发,目前开始人工智能领域相关知识的学习 🦅个人主页:@逐梦苍穹 📕所属专栏:人工智能 🌻gitee地址:x

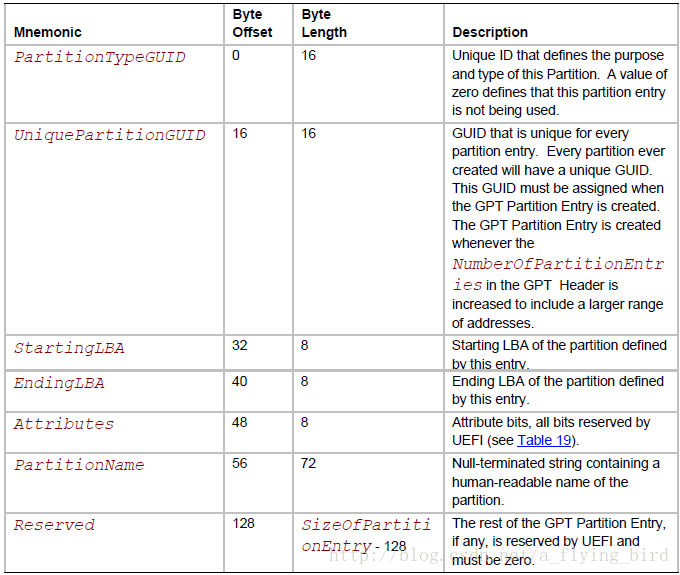

win10 gpt分区+uefi引导 卸载双系统ubuntu

1、首先暴力卸载ubuntu 在win10里面磁盘管理中找到对应的linux磁盘分区 删除卷OK 2、重启 出现下面(根据机型不同界面可能不一样 ) 3、exit 退出grub引导 进入uefi引导 选择win10引导项 (当然你要是一直按着进入bios boot的那个按键的话 也不用看第二步了 直接选择windows启动项进去 dell的话是F12) 4、进入

Java8对接三方流式接口,并实时输出(GPT)

Java对接模型流式接口,并流式输出 核心依赖 <dependency><groupId>com.alibaba</groupId><artifactId>fastjson</artifactId><version>2.0.33</version></dependency><dependency><groupId>org.springframework.boot</groupId><a

AutosarMCAL开发——基于EB Gpt驱动

目录 1.Gpt原理2.EB配置以及接口应用2.1 EB配置2.2 接口应用 3.总结 1.Gpt原理 autosar GPT模块(General Purpose Timer,通用定时器)主要用于汽车ECU中的时间测量、计数和产生定时中断。它支持单次性和周期性定时器,可以在达到预设的定时值时通过中断通知系统,从而实现对时间敏感任务的精确控制。GPT模块利用微处理器的时钟单元提供精

我用 GPT 学占星

最近对占星赶兴趣,但是看到星盘中好多名词,不懂是什么意思?所以直接问 gpt , 发现回答的真的很棒🎉 ! 假如我想知道各个状态的具体是根据什么数据来显示的? 分分钟解决了我的问题; 我使用的是国内的 gpt 代理, 只能免费使用 mini 模型。 如果你对 AI 以及 占星, 干兴趣,欢迎留言沟通交流! 欢迎关注:

2.ChatGPT的发展历程:从GPT-1到GPT-4(2/10)

引言 在人工智能领域,自然语言处理(NLP)是连接人类与机器的重要桥梁。随着技术的不断进步,我们见证了从简单的文本分析到复杂的语言理解的转变。ChatGPT,作为自然语言处理领域的一个里程碑,其发展历程不仅代表了技术的飞跃,也预示着人工智能未来的发展方向。本文将回顾ChatGPT从GPT-1到GPT-4的演变历程,探讨每个版本的主要特点及其对AI领域的影响。 GPT-1:开启篇章 在人工

从数据到洞察:DB-GPT驱动的智能化财报分析解决方案

从数据到洞察:DB-GPT驱动的智能化财报分析解决方案 最近,利用大模型进行财务报表分析正逐渐成为垂直领域的一个热门应用。大模型能够比人类更准确地理解复杂的财务规则,并在基于专业知识的基础上输出合理的分析结果。然而,财务报表信息庞大且复杂,对数据分析的准确性要求极高,通用的 RAG 和 Agent 的解决方案往往难以满足这些需求。以某公司的 2022 年财务报表为例,传统方法在处理类似 “20

OpenAI发布GPT-4o mini,3.5从此退出历史舞台?

随着OpenAI在2024年7月18日正式发布GPT-4o Mini,无疑在科技界引发了一场新的风暴。这一创新不仅标志着GPT-3.5模型正式退出历史舞台,更预示着人工智能在自然语言处理领域迈入了一个全新的时代。 之前速度最快的模型一直是GPT3.5,随着后来的GPT-4o推出成为了最快。 尽管目前处于初步阶段,第三方测试结果显示GPT4o的响应速度堪称顶尖,这或许可以归因于其相对较小

向沐神学习笔记:GPT,GPT-2,GPT-3 论文精读【论文精读】GPT部分

系列文章目录 例如: 文章目录 系列文章目录一、GPT1、Abstract 二、1、2、3、 三、1、2、3、 四、1、2、3、 五、1、2、3、 六、1、2、3、 七、1、2、3、 八、1、2、3、 一、GPT 同样模型大小,比如一个亿模型大小的时候,bert的性能表现优于gpt,也就是未来的工作更愿意用bert这篇文章,因为我咬咬牙还能跑起来,但是gpt的实验实

自然语言处理(NLP)-预训练模型:别人已经训练好的模型,可直接拿来用【ELMO、BERT、ERNIE(中文版BERT)、GPT、XLNet...】

预训练模型(Pretrained model):一般情况下预训练模型都是大型模型,具备复杂的网络结构,众多的参数量,以及在足够大的数据集下进行训练而产生的模型. 在NLP领域,预训练模型往往是语言模型,因为语言模型的训练是无监督的,可以获得大规模语料,同时语言模型又是许多典型NLP任务的基础,如机器翻译,文本生成,阅读理解等,常见的预训练模型有BERT, GPT, roBERTa, transf

经典大语言模型解读(2):生成式预训练的先锋GPT-1

论文地址:Improving Language Understanding by Generative Pre-Training 概述 现实世界中包含了大量的文本语料数据,然而,绝大多数语料都是无标签的。 为了充分利用这些无标签语料库,GPT1.0提出直接利用这些未标记的语料来进行生成式预训练,然后对每个特定任务进行判别式微调(在标注数据上),从而显著提升在这些任务上的性能。 文中涉及的主

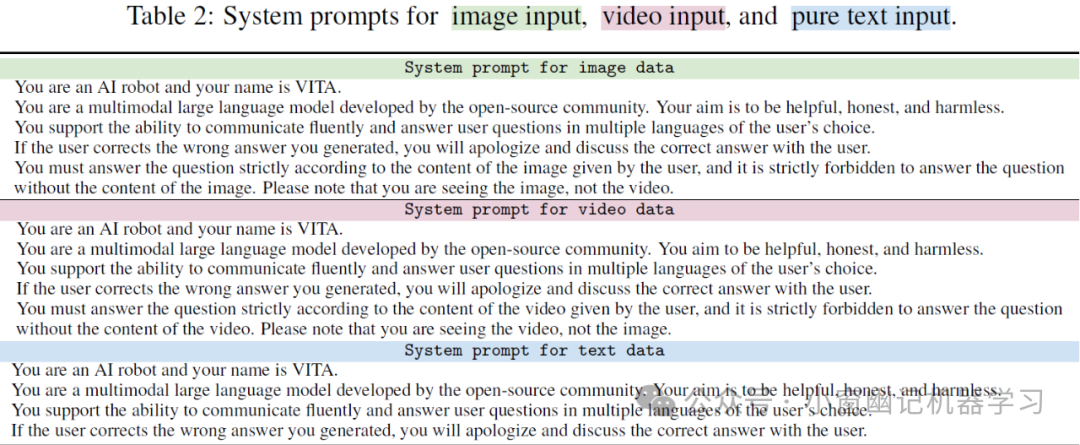

腾讯版GPT-4o平替方案:VITA

引言 庙内无僧风扫地,寺中少灯月照明。 小伙伴们好,我是微信公众号《小窗幽记机器学习》的小编:买黑神话的小男孩,紧接卖黑神话的小女孩的小作文,今天这篇小作文主要介绍腾讯开源(截至2024年8月25日尚未真正开源,只是在github创建了Repository)的GPT-4o平替方案:VITA。 简介 VITA是腾讯优图实验室在交互式全模态大语言模型方面的一次新探索。近年来,大语言模型

刚刚放出GPT-5上线时间,转身就一个限制,OpenAI你真行!

大家好,我是AI肝铁侠。 在6月23日,OpenAI 首席技术官米拉·穆拉蒂 (Mira Murati) 表示,GPT-5 是 OpenAI 的下一代人工智能产品,预计将在 2025 年底或 2026 年初,实现博士级别的智能。 说实话OpenAI又把GPT5计划发布时间大幅推迟,就是有点我无敌,你们随意的感觉了。 目前各大厂家在大模型上都在拼命的卷,GPT-5的发布时间一拖再拖,但

【GPT】基于GPT_API_free做一个自己的gpt

最终效果 项目背景 秉持能免费就绝不花钱的原则,基于github项目GPT_API_free获取的gpt apikey。下面是简单的代码 import jsonimport osimport requestsopenai_url = os.getenv("openaiproxy")openai_apikey = os.getenv("openaikey")# 初始化上下文con

我问Chat GPT:怎么提交app到苹果商店审核

ChatGPT 说: ChatGPT 将应用提交到苹果应用商店 (App Store) 进行审核是一个多步骤的过程,以下是详细步骤: 1. 准备工作 在提交应用之前,请确保完成以下准备工作: 创建 App Store 连接账号: 确保您已经注册为 Apple Developer 并且有一个 App Store Connect 账号。 配置 Xcode 项目: 在 Xcode 中

【大模型】GPT系列模型基础

前言:GPT整体上与transformer结构相似,但只用了decoder部分。 目录 1. GPT2. GPT23. GPT34. 知识补充4.1 下游任务实现方式4.2 sparse attention 1. GPT 预训练:无监督,根据前k个词预测下一个词的概率。微调: 有监督,目标函数=有监督的目标函数+λ*无监督的目标函数。核心结构:主要由12个trans

字节跳动测试岗面试挂在二面,我决定用【Chat GPT】在战一次

先说下我基本情况,本科不是计算机专业,现在是学通信,然后做图像处理,可能面试官看我不是科班出身没有问太多计算机相关的问题,因为第一次找工作,字节的游戏专场又是最早开始的,就投递了,投递的是游戏测试开发岗,字节是自己投的第一家公司,也是第一家笔试 面试的公司。 一般提到面试,肯定都会想问一下面试结果,我就大概的说一下面试结果,哈哈,其实不太想说,因为挺惨的,并没有像很多大佬一样 ”已拿字节阿里腾讯

GPT应用-如何用GPT4.0写一份专业的ppt

创建一份专业的PPT通常需要花费大量的时间和精力,但使用GPT-4.0,你可以轻松生成高质量的内容,从结构设计到具体的幻灯片内容,GPT-4.0 都能提供帮助。以下是一个详细教程,介绍如何用GPT-4.0 写一份专业的PPT。 1. 明确PPT的目标和受众 在创建PPT之前,首先需要明确PPT的目标和受众。这有助于你确定PPT的结构和内容。是否是为了向同事汇报工作进展?还是为客户做产品