本文主要是介绍神经网络突变自动选择AI优化算法,速度提升50000倍!,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

新智元报道

来源:venturebeat、IBM

编辑:大明

【导读】为特定任务寻找最合适的优化机器学习算法是一件耗时费力的工作,因为没有一种算法能适用于所有任务。IBM的研究人员提出“神经突变”进化算法,可以为机器学习任务自动选择最合适的算法,选择速度提升了50000倍,错误率仅上升0.6%.

机器学习系统并非是“生而平等”的。没有一种算法能应对所有的机器学习任务,这就让寻找最优的机器学习算法成为一项艰巨又耗时的工作。不过这个问题现在有希望解决了,最近IBM的研究人员开发了一套能够自动选择AI优化算法的系统。

IBM爱尔兰研究院的数据科学家Martin Wistuba,在其近日发表的博客文章中介绍了自己开发的这套系统。他声称,该系统将自动选择优化AI算法的速度提升了5万倍,错误率仅上升了0.6%。

Wistuba表示,这套进化算法系统能将选择适当的机器学习架构的时间缩减至几个小时,让每个人都能有条件对深度学习网络架构进行优化。

面向机器学习的神经网络突变算法

该方法将卷积神经网络架构视为神经细胞序列,然后应用一系列突变,以找到一种结构,可以提升给定数据集和机器学习任务的神经网络的性能。

这种方法大大缩短了网络训练时间。这些突变会改变网络结构,但不会改变网络的预测,网络的结构变化可能包括添加新的层、添加新连接或扩展内核或现有层。

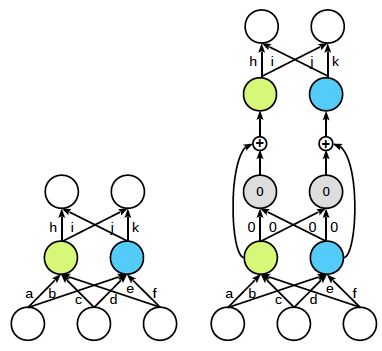

保留原函数的神经网络突变示例。右侧的体系结构是突变后的网络,但与左侧的体系结构具有相同的预测结果(由相同颜色表示)

实验评估:速度提升5万倍,错误率仅上升0.6%

实验中,研究人员将新神经进化方法与CIFAR-10和CIFAR-100数据集上的图像分类任务的其他几种方法进行了比较。这些数据集通常用于训练机器学习和计算机视觉算法的图像集。

与最先进的人工设计架构、基于强化学习的架构搜索方法、以及基于进化算法的其他自动化方法的结果相比,结构突变算法在分类错误上稍高出前几种方法,但耗时要少得多,比其他方法快了50000倍,错误率最多仅比基准数据集CIFAR-10上的最有力竞争对手高出0.6%。

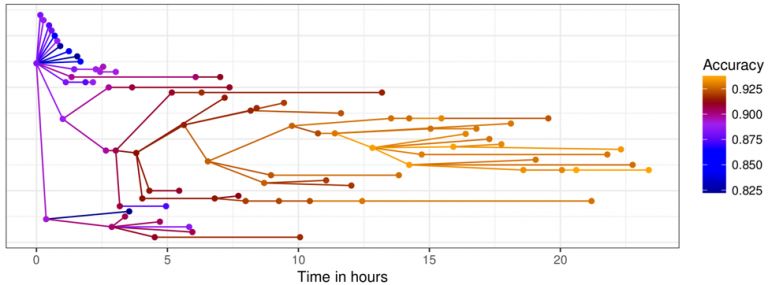

下图所示为算法的优化过程。在图2中,每个点代表不同的结构,连接线代表突变。不同颜色所示为每个结构的精度,x轴表示时间。可以看到,准确率在前10个小时内迅速上升,之后缓慢上升、最后趋于稳定。

深度学习网络设计的进化算法优化

图示为随时间推移,进化算法的优化过程

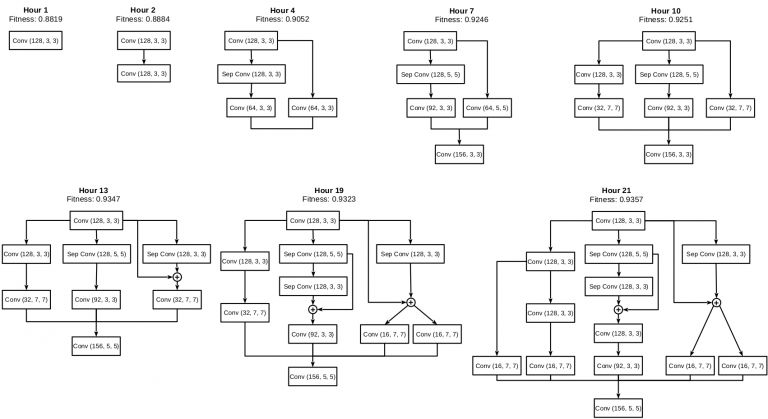

下图所示为随着时间的推移,深度学习网络结构的演变情况。

网络结构随时间的演变,图中某些中间状态未显示

实际上,自动算法选择并不新鲜。谷歌在智能手机面部识别和目标检测上也在使用这类方法,如果IBM这一的系统性能确实如其所言,它可能代表着该领域内的一次重大进步。

将来,研究人员希望将这种优化集成到IBM的云服务中,并将其提供给客户。此外还计划将其扩展到更大的数据集上,如ImageNet和其他类型的数据,如时间序列和文本、自然语言处理任务等。

Wistuba将于9月在爱尔兰都柏林举行的欧洲机器学习和数据库知识发现会议(ECML-PKDD)会议上介绍这种方法。

参考链接:

https://venturebeat.com/2018/09/04/ibms-new-system-automatically-selects-the-optimal-ai-algorithm/

https://www.ibm.com/blogs/research/2018/09/ai-design-deep-learning/

点击下方“阅读原文”了解【人工智能服务器】 ↓↓↓

这篇关于神经网络突变自动选择AI优化算法,速度提升50000倍!的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!