本文主要是介绍【AI绘画】免费GPU Tesla A100 32G算力部署Stable Diffusion,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

免责声明

在阅读和实践本文提供的内容之前,请注意以下免责声明:

-

侵权问题: 本文提供的信息仅供学习参考,不用做任何商业用途,如造成侵权,请私信我,我会立即删除,作者不对读者因使用本文所述方法而导致的任何损失或损害负责。

-

信息准确性: 本文提供的信息可能随时更改,作者不保证文中所述方法在未来的软件更新中仍然有效。

-

个人风险: 读者在按照本文提供的方法操作时,应该自行承担风险。作者不对读者因使用本文所述方法而导致的任何损失或损害负责。

-

软件兼容性: 本文中提到的软件版本和兼容性可能会受到变化。读者应该在实施前查看相关软件的官方文档,以确保使用的软件版本相互兼容。

-

个体差异: 不同的计算机环境、操作系统版本和其他因素可能导致实际操作效果有所不同。读者在实践中可能需要进行适当的调整。

-

建议备份: 在进行重要操作之前,建议读者备份其数据和设置,以防万一发生意外情况。

-

社区支持: 读者如果遇到问题,建议参考相关软件的官方社区或论坛,以获取更多帮助。

文章目录

- 免责声明

- 1. 引言

- 1.1 什么是Stable Diffusion

- 1.2 AI Studio学习与实训社区

- 2. 注册AI Studio账号

- 2.1 通过邀请链接注册

- 2.2 领取免费算力

- 3. 创建Notebook项目

- 3.1 选择基础版

- 3.2 配置环境

- 4. 拉取Stable Diffusion代码

- 5. 更换pip镜像

- 6. 安装依赖

- 6.1 运行安装脚本

- 6.2 解决网络问题

- 7. 内网穿透

- 7.1 ngrok内网穿透

- 7.2 natapp内网穿透(国内速度较快)

- 8. 项目目录结构

- 8.1 插件保存位置

- 8.2 模型保存位置

- 9. 结论

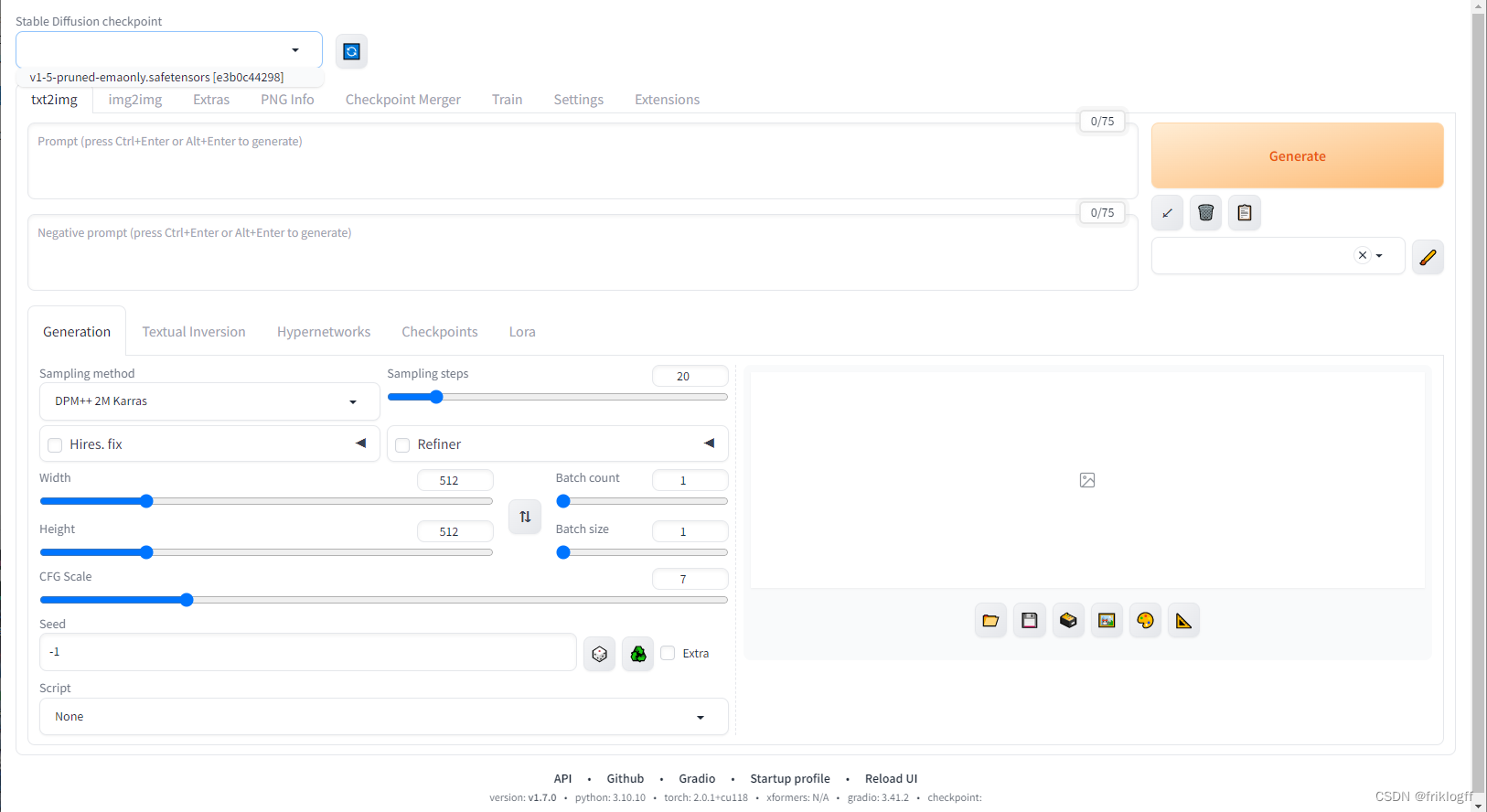

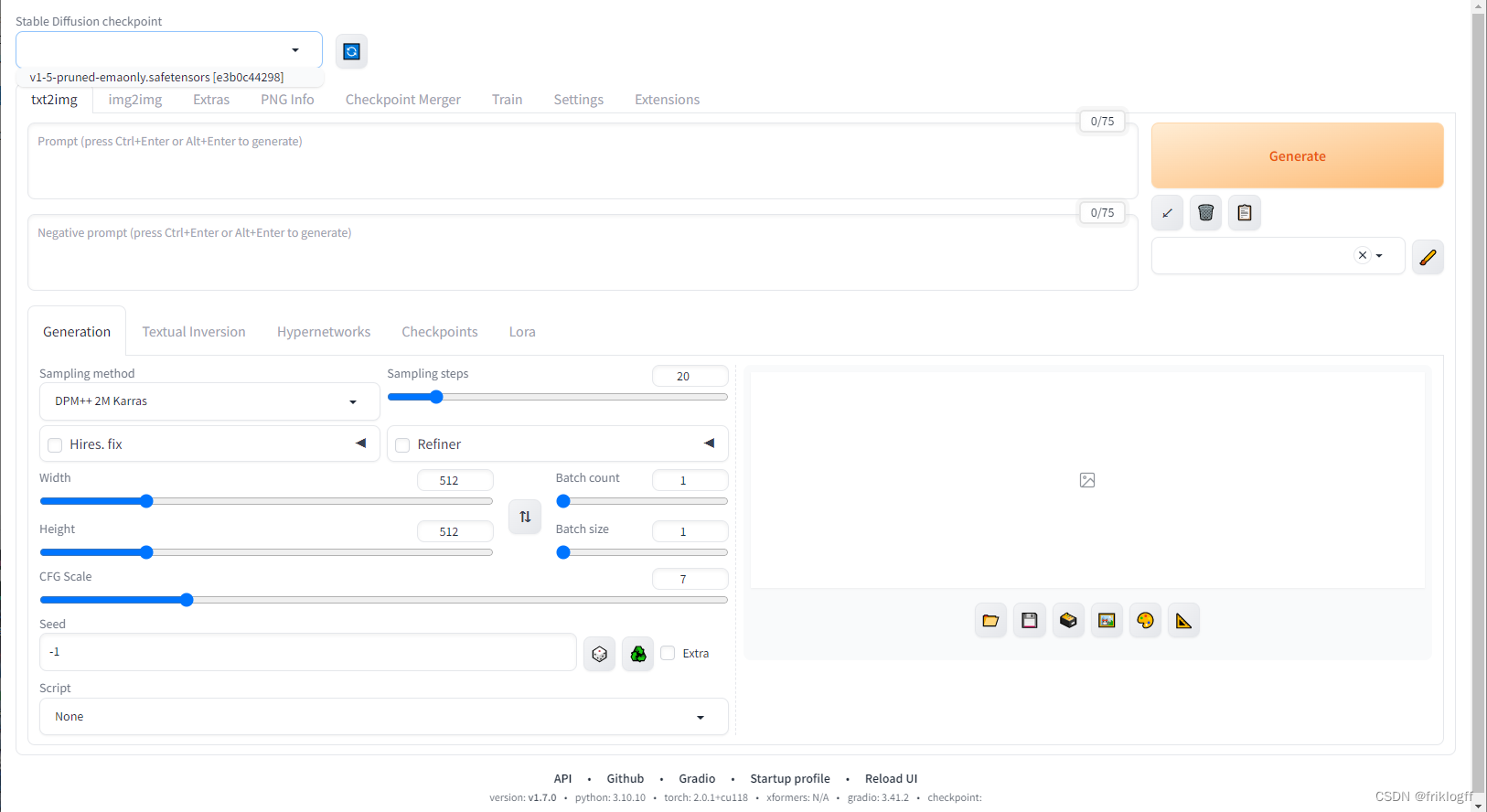

- 9.1 成功部署Stable Diffusion

- 9.2 后续探索

1. 引言

1.1 什么是Stable Diffusion

Stable Diffusion是一个基于深度学习的图像生成工具,它使用扩散模型生成高质量的图像。该项目由AUTOMATIC1111开发并在GitHub上开源。

1.2 AI Studio学习与实训社区

AI Studio是百度推出的一个在线AI学习与实训社区,提供免费的GPU算力支持,用户可以在此平台上进行深度学习的项目开发和部署。

2. 注册AI Studio账号

2.1 通过邀请链接注册

点击以下链接注册AI Studio账号:AI Studio注册链接

2.2 领取免费算力

成功注册账号后,点击“我的创作”,可以领取免费算力。

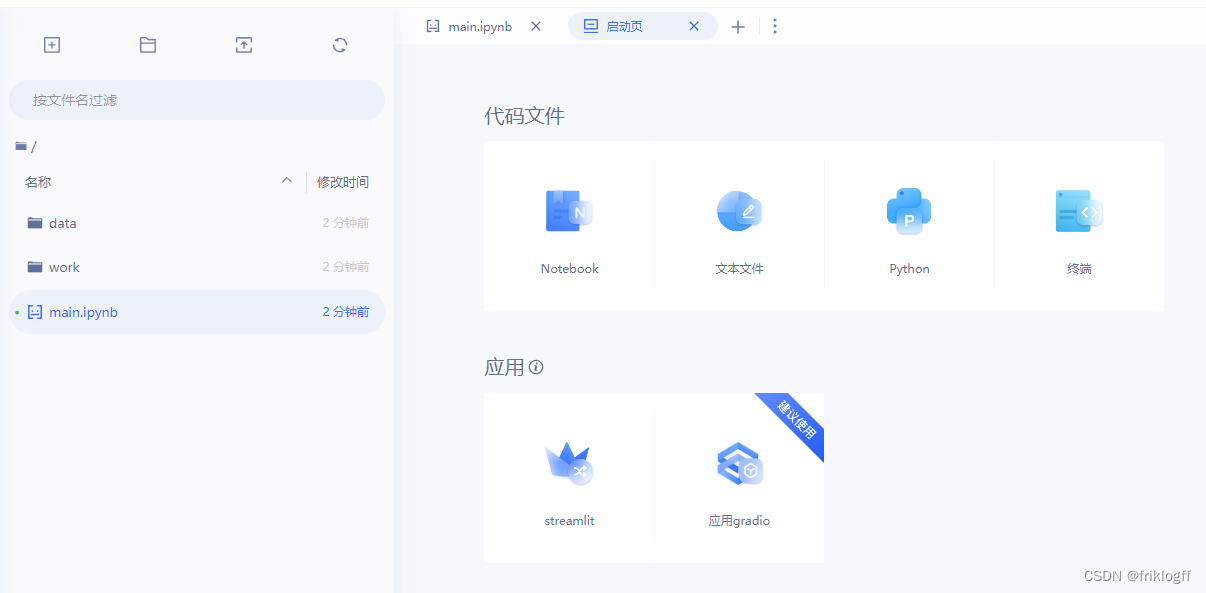

3. 创建Notebook项目

3.1 选择基础版

点击“创建项目”,选择“Notebook”,然后选择“基础版”。

3.2 配置环境

-

创建一个notebook项目

选择基础版我们先配环境

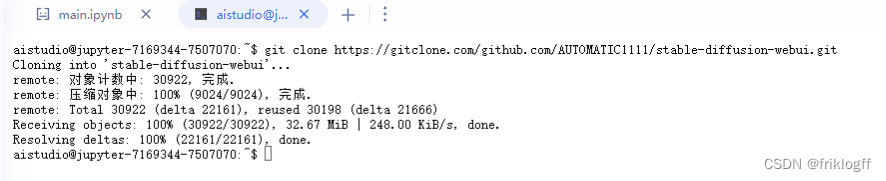

4. 拉取Stable Diffusion代码

在Notebook中运行以下命令,拉取Stable Diffusion代码:

git clone https://gitclone.com/github.com/AUTOMATIC1111/stable-diffusion-webui.git

5. 更换pip镜像

在Notebook中运行以下命令,更换pip镜像源为阿里云:

mkdir -p ~/.pip

cat <<EOF > ~/.pip/pip.conf

[global]

timeout = 6000

index-url = https://mirrors.aliyun.com/pypi/simple

trusted-host = mirrors.aliyun.com

EOF

如果需要重新生成pip配置文件,可运行以下命令删除原有配置文件:

rm -rf ~/.pip

6. 安装依赖

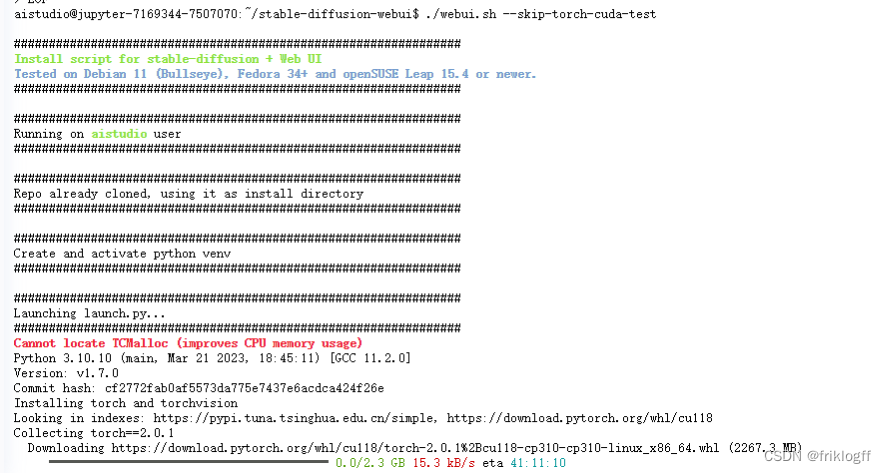

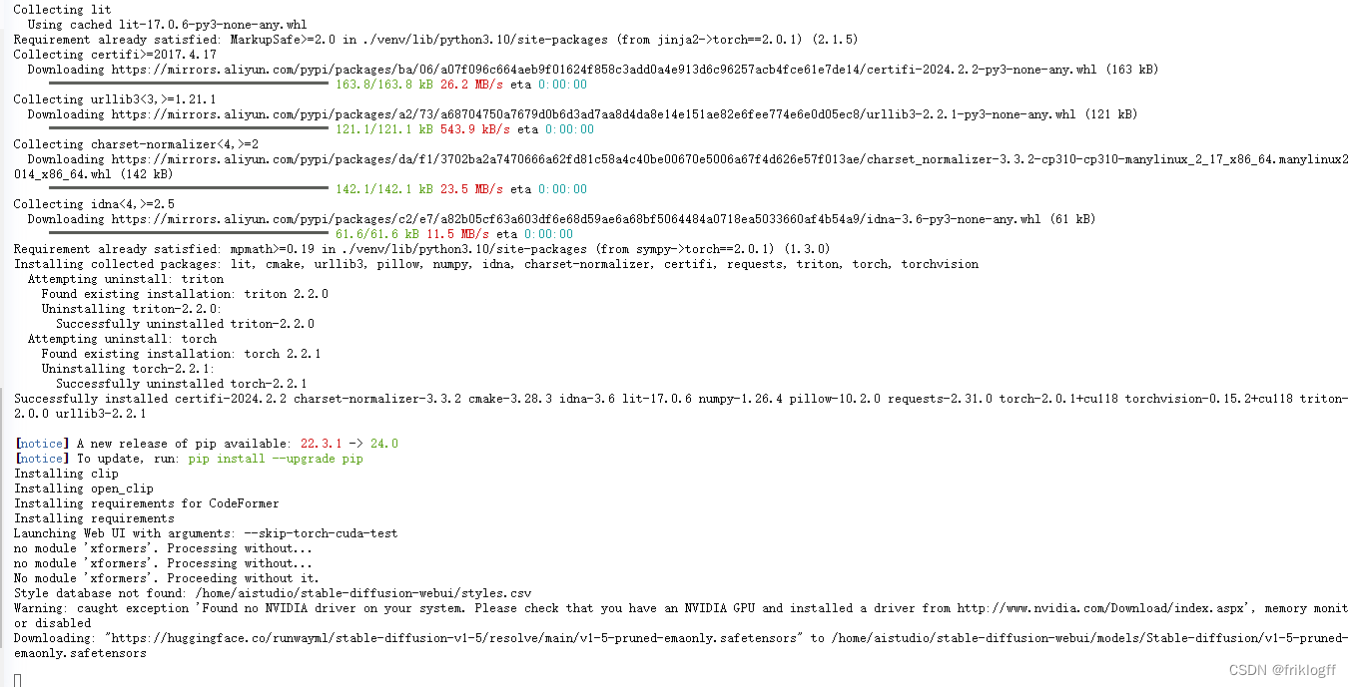

6.1 运行安装脚本

进入stable-diffusion-webui目录,运行安装脚本:

cd stable-diffusion-webui/

./webui.sh --skip-torch-cuda-test

这里下载可能非常缓慢,你可以点击链接在本地先下载再上传直接安装whl

这里我发现Stable Diffusion同样恰好通过创建虚拟环境得以可配置PyTorch环境,虚拟环境位于stable-diffusion-webui/models/venv

【深度学习】不用Conda在PP飞桨Al Studio三个步骤安装永久PyTorch环境

或者多次Ctrl+Z重试切换到更好的网络

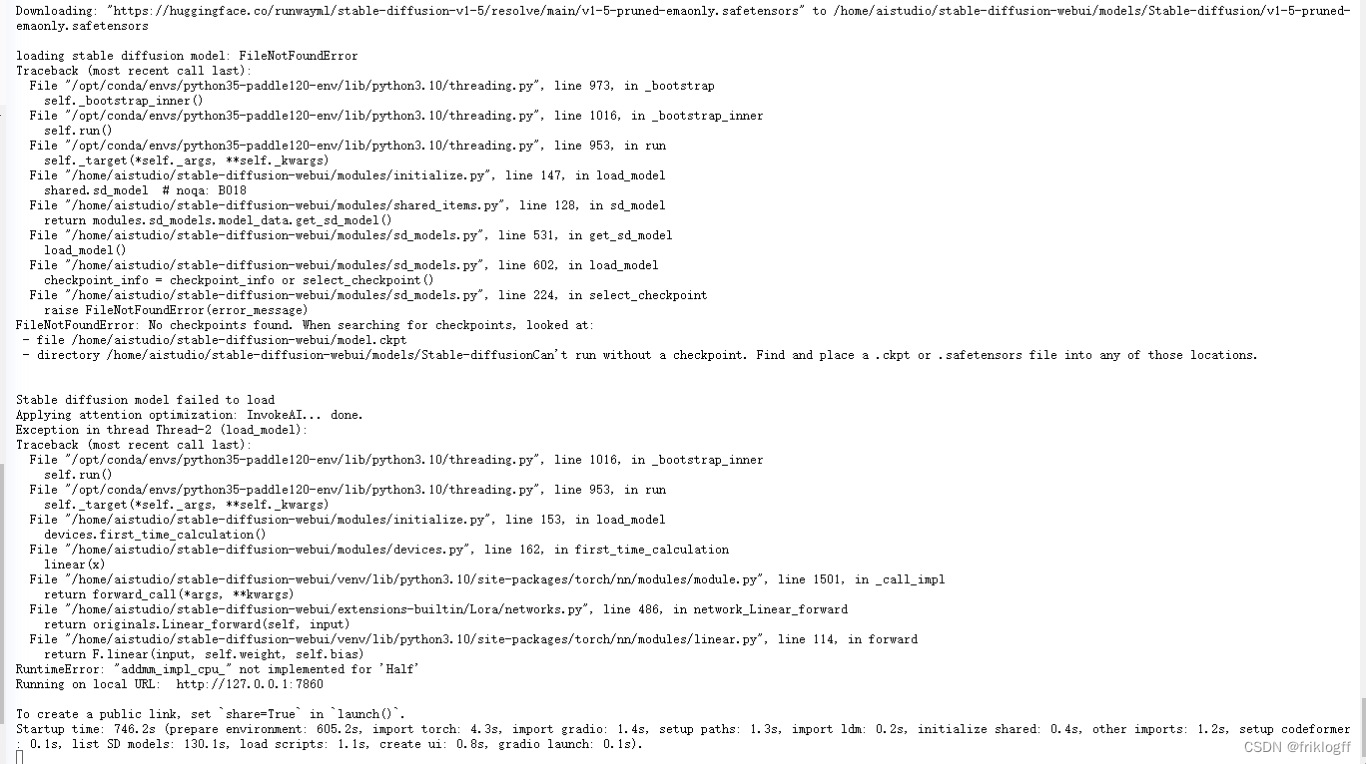

这里已经配置成功,可以看到尝试链接huggingface下载初始模型,由于我们连接不上这个网站,所以会一直卡到超时自动结束,你可以在他指定的文件夹创一个同名空文件暂时替代,或者自行上传模型。

/home/aistudio/stable-diffusion-webui/models/新建一个

v1-5-pruned-emaonly.safetensors

可以看到连接超时后仍然自动运行

6.2 解决网络问题

由于AI Studio的网络环境问题,可能会导致安装过程中下载依赖包很慢或下载失败。可以尝试多次运行安装脚本,或者手动下载依赖包并上传到Notebook中进行安装。

7. 内网穿透

7.1 ngrok内网穿透

https://ngrok.com/

注册获取<your_authtoken>,不能用QQ邮箱注册

在Notebook中运行以下命令,下载并安装ngrok:

wget https://bin.equinox.io/c/bNyj1mQVY4c/ngrok-v3-stable-linux-amd64.tgz

chmod +x ngrok

ngrok config add-authtoken <your_authtoken>

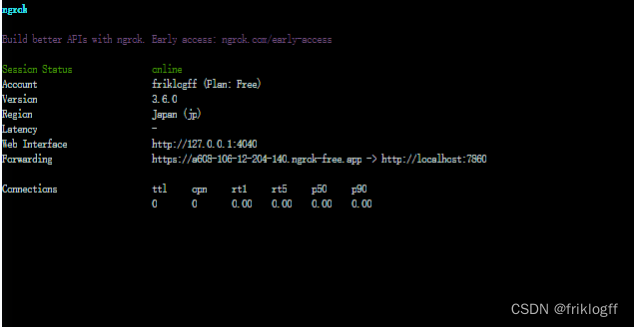

./ngrok http 7860

注意:需要在ngrok官网注册账号并获取authtoken。

通过内网穿透得到的的Forwarding链接,你可以在任何设备上访问这个网址使用Stable Diffusion

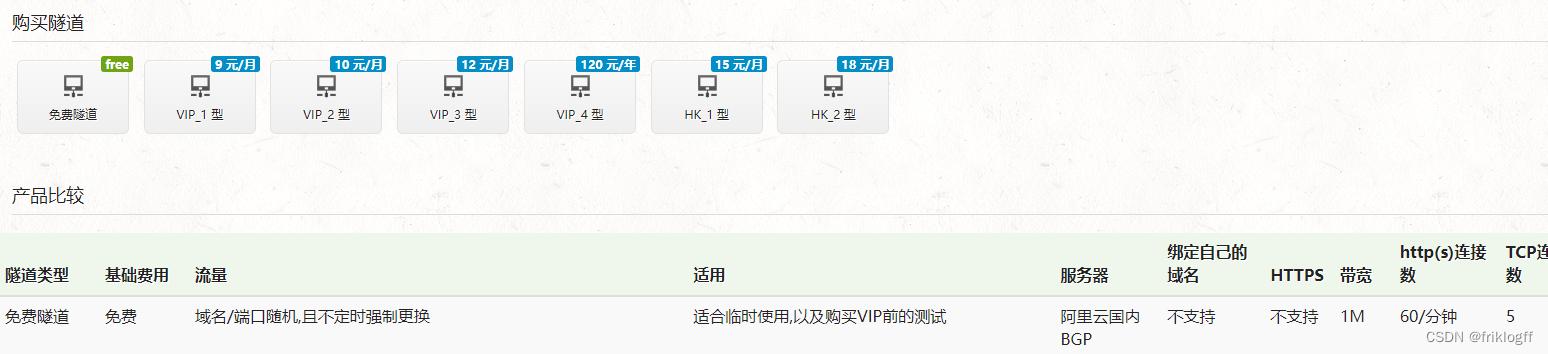

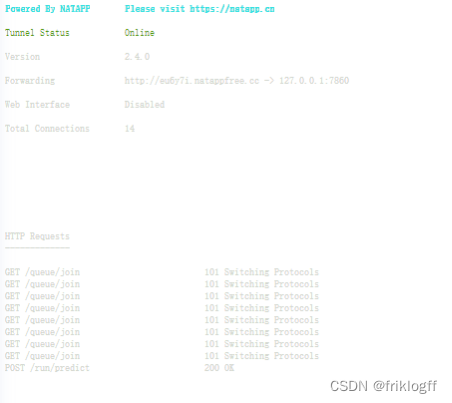

7.2 natapp内网穿透(国内速度较快)

在Notebook中运行以下命令,下载并安装natapp:

wget https://cdn.natapp.cn/assets/downloads/clients/2_4_0/natapp_linux_amd64/natapp

注意:需要在natapp官网注册账号并获取配置文件。

natapp要实名认证,提前设置映射端口

Web协议,7860端口

注册购买后获得<your_authtoken>

chmod +x natapp

./natapp -authtoken=<your_authtoken>

通过内网穿透得到的的Forwarding链接,你可以在任何设备上访问这个网址使用Stable Diffusion

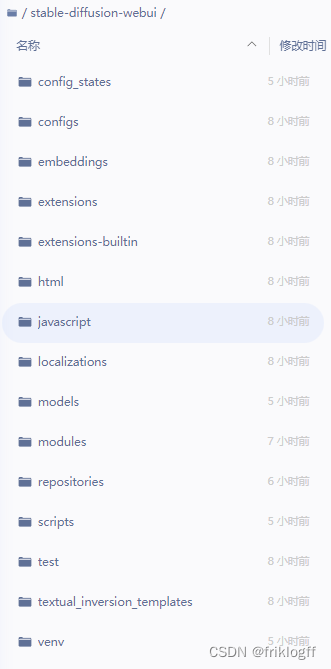

8. 项目目录结构

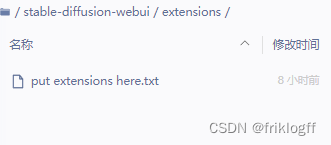

8.1 插件保存位置

Stable Diffusion的插件保存在stable-diffusion-webui/extensions目录下。

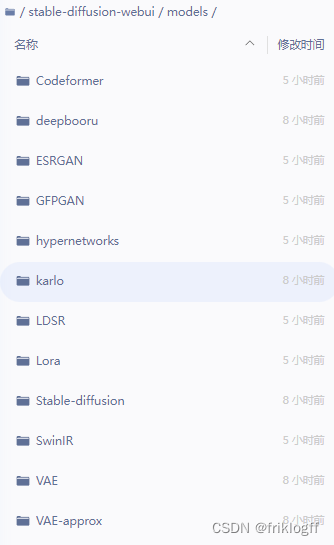

8.2 模型保存位置

Stable Diffusion的模型保存在stable-diffusion-webui/models目录下。

我们看一下项目目录

插件保存在这

模型保存在这

9. 结论

9.1 成功部署Stable Diffusion

按照以上步骤,就可以成功在AI Studio上部署Stable Diffusion,并利用免费的Tesla A100 GPU算力进行AI绘画。

9.2 后续探索

在成功部署Stable Diffusion之后,可以尝试使用不同的模型和插件,进行更多的AI绘画创作。同时,也可以结合其他的深度学习技术,进一步提高生成的图像质量。

你可以通过创建数据集、wget、git下载你需要的模型或插件

这篇关于【AI绘画】免费GPU Tesla A100 32G算力部署Stable Diffusion的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!