本文主要是介绍用LSTM模型做imdb电影评论情感分析,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

imdb数据集介绍

IMDB影评数据集中含有来自IMDB的25,000条影评,被标记为正面/负面两种评价。影评已被预处理为词下标构成的序列。方便起见,单词的下标基于它在数据集中出现的频率标定,例如整数3所编码的词为数据集中第3常出现的词。这样的组织方法使得用户可以快速完成诸如“只考虑最常出现的10,000个词,但不考虑最常出现的20个词”这样的操作

按照惯例,0不代表任何特定的词,而用来编码任何未知单词

keras中内置了imdb数据集,我们直接导入即可(由于已经下载了,这里指定path)。

由于博主之前已经有一篇文章已经对数据进行了分析,这里就不过多赘述了,感兴趣的朋友可以移步用一维卷积模型做imdb电影评论情感分析

导入数据

from keras.datasets import imdb

#只考虑出现频率最高的10000个单词,其余低频率单词会被编码为0

max_word = 10000

(train_x, train_y), (test_x, test_y) = imdb.load_data(num_words=max_word,path='/root/.keras/datasets/imdb.npz')

处理数据

from keras.preprocessing.sequence import pad_sequences

maxlen = 500

train_x = pad_sequences(train_x,maxlen=maxlen)

test_x = pad_sequences(test_x,maxlen=maxlen)

用keras中的pad_sequences方法对数据进行填充或切割,使数据序列长度的恒为500,长度不足的填充0,长度大于500的被截断。

定义回调函数

keras会在每一轮训练后调用回调函数

from keras.callbacks import EarlyStopping,ModelCheckpoint

callbacks_list = [EarlyStopping(monitor = 'val_accuracy', #监控验证精度patience = 3, #如果验证精度多于三轮不改善则中断训练),#在训练的过程中不断得保存最优的模型ModelCheckpoint(filepath = 'my_model_lstm.h5', #模型保存路径monitor = 'val_accuracy', #监控验证精度save_best_only = True, #如果val_accuracy没有改善则不需要覆盖模型)

]

LSTM层

长短期记忆网络(LSTM)是一种时间循环神经网络,是RNN的一个优秀的变种模型,它继承了大部分RNN模型的特性,同时解决了梯度反向传播过程中产生的梯度消失问题。它非常适合于长时间序列的特征,能分析输入信息之间的整体逻辑序列。

下面我们通过一个例子来熟悉LSTM

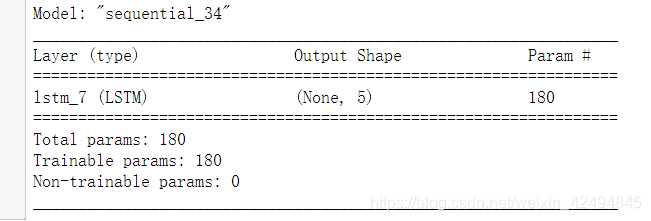

定义模型

from keras import Sequential

from keras.layers import LSTM

model_test = Sequential()

model_test.add(LSTM(5,input_shape=(4,3)))

model_test.compile(loss='mse',optimizer='sgd')

查看模型结构

model_test.summary()

我们定义了5个LSTM节点,它接受一个形状为(4,3)的输入,输出形状为(None,5)。

通过模型的输出

data = np.random.random((1,4,3))

print(data)

print("==========================")

print(model_test.predict(data))

输出为

[[[0.79716507 0.34357063 0.90199362][0.81896706 0.36259831 0.83346227][0.92933103 0.50251658 0.90276097][0.42825427 0.91050999 0.05773106]]]

==========================

[[ 0.04960854 -0.09560797 0.06205023 -0.23291263 -0.21847163]]

每个节点都会从时序的角度来提取特征,获得一个输出结果。

接下来定义我们训练imdb电影评论的模型

定义模型

from keras import layers

from keras.losses import BinaryCrossentropy

from keras.models import Sequential

model = Sequential([layers.Embedding(max_word,32),layers.LSTM(32),layers.Dense(1,activation="sigmoid")

])

model.compile(optimizer="rmsprop",loss=BinaryCrossentropy(),metrics=["accuracy"])

训练模型

history = model.fit(train_x,train_y,epochs=10,batch_size = 128,validation_data=(test_x, test_y),callbacks=callbacks_list)

训练结果如下

Train on 25000 samples, validate on 25000 samples

Epoch 1/10

25000/25000 [==============================] - 135s 5ms/step - loss: 0.4738 - accuracy: 0.7788 - val_loss: 0.3055 - val_accuracy: 0.8770

Epoch 2/10

25000/25000 [==============================] - 129s 5ms/step - loss: 0.2779 - accuracy: 0.8928 - val_loss: 0.2790 - val_accuracy: 0.8867

Epoch 3/10

25000/25000 [==============================] - 134s 5ms/step - loss: 0.2286 - accuracy: 0.9123 - val_loss: 0.3296 - val_accuracy: 0.8721

Epoch 4/10

25000/25000 [==============================] - 129s 5ms/step - loss: 0.2028 - accuracy: 0.9246 - val_loss: 0.3176 - val_accuracy: 0.8810

Epoch 5/10

25000/25000 [==============================] - 129s 5ms/step - loss: 0.1777 - accuracy: 0.9356 - val_loss: 0.3551 - val_accuracy: 0.8551

可以看到在第五轮训练完成后训练就提前结束了,因为三轮验证精度都没有改善,同时训练过程中最好的模型已经被保存了,验证精度最高为0.8867。

LSTM通常用于时序较长的特征数据,常用于机器翻译,对话生成,编码,解码等。今天分享的内容就到这里了,希望能够对大家有所帮助。

PS:过两天会分享一篇文章来分析比较LSTM模型和一维卷积模型的特点。

这篇关于用LSTM模型做imdb电影评论情感分析的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!