本文主要是介绍Datawhale《动手学数据分析》Task01:数据加载及探索性数据分析笔记1,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

1 第一章:数据载入及初步观察

1.1 载入数据

数据集:kaggle泰坦尼克数据集

数据集下载 Titanic - Machine Learning from Disaster | Kaggle

任务一:导入numpy和pandas

import numpy as np

import pandas as pd任务二:载入数据

相对路径需要以当前文件所处目录为基准,所以使用代码查看当前所处文件夹的绝对路径。

import os

path1 = os.path.abspath('.') #所处文件夹的绝对路径

print(path1)

path2 = os.path.abspath('..') #所处文件夹上一级的绝对路径

print(path2)E:\emmmmmm\Analysis\jupyter-notebook E:\emmmmmm\Analysis

(1) 使用相对路径载入数据

#相对路径三种方式

dftrain0 = pd.read_csv(r"..\titanic\train.csv")

dftrain01 = pd.read_csv("..\\titanic\\train.csv")

dftrain02 = pd.read_csv("../titanic/train.csv")(2) 使用绝对路径载入数据

# 绝对路径三种方式

dftrain1 = pd.read_csv(r"E:\emmmmmm\Analysis\titanic\train.csv")

dftrain11 = pd.read_csv("E:\\emmmmmm\\Analysis\\titanic\\train.csv")

dftrain12 = pd.read_csv("E:/emmmmmm/Analysis/titanic/train.csv")【思考】

知道数据加载的方法后,试试pd.read_csv()和pd.read_table()的不同

csv默认制表符为“,”,table默认制表符为“\t”

pd.read_csv()

pd.read_table()

#一个举例

如果想让他们效果一样,需要怎么做?

#指定分隔符

pd.read_table('', sep=',')

了解一下'.tsv'和'.csv'的不同,如何加载这两个数据集?

.tsv使用\t作为分隔符,.csv使用,作为分隔符。

任务三:每1000行为一个数据模块,逐块读取

dftrain1000 = pd.read_csv(r"..\titanic\train.csv",chunksize=1000)

for chunk in dftrain1000:print(type(chunk)) #<class 'pandas.core.frame.DataFrame'>print(len(chunk)) #891print(chunk)#此数据集行为数不足1000

任务四:将表头改成中文,索引改为乘客ID

PassengerId => 乘客ID

Survived => 是否幸存

Pclass => 乘客等级(1/2/3等舱位)

Name => 乘客姓名

Sex => 性别

Age => 年龄

SibSp => 堂兄弟/妹个数

Parch => 父母与小孩个数

Ticket => 船票信息

Fare => 票价

Cabin => 客舱

Embarked => 登船港口

colnames=['乘客ID','是否幸存','乘客等级(1/2/3等舱位)','乘客姓名','性别','年龄','堂兄弟/妹个数','父母与小孩个数','船票信息','票价','客舱','登船港口']

dftrain = pd.read_csv(r"..\titanic\train.csv",names=colnames,index_col='乘客ID')

dftrain.head()

1.2 初步观察

导入数据后,你可能要对数据的整体结构和样例进行概览,比如说,数据大小、有多少列,各列都是什么格式的,是否包含null等

任务一:查看数据的基本信息

print(dftrain.describe()) #整体描述

print(dftrain.info()) #获取摘要

print(dftrain.columns) #列标签

print(dftrain.shape) #行列数任务二:观察表格前10行的数据和后15行的数据

#观察表格前10行的数据

colnames=['乘客ID','是否幸存','乘客等级(1/2/3等舱位)','乘客姓名','性别','年龄','堂兄弟/妹个数','父母与小孩个数','船票信息','票价','客舱','登船港口']

dftrain = pd.read_csv(r"..\titanic\train.csv",names=colnames,index_col='乘客ID')

dftrain.head(10)

#观察表格后15行的数据

colnames=['乘客ID','是否幸存','乘客等级(1/2/3等舱位)','乘客姓名','性别','年龄','堂兄弟/妹个数','父母与小孩个数','船票信息','票价','客舱','登船港口']

dftrain = pd.read_csv(r"..\titanic\train.csv",names=colnames,index_col='乘客ID')

dftrain.tail(15)

任务三:判断数据是否为空,为空的地方返回True,其余地方返回False

dftrain.isnull().head()

1.3 保存数据

任务一:将你加载并做出改变的数据,在工作目录下保存为一个新文件train_chinese.csv

dftrain.to_csv("train_chinese.csv",encoding='GBK')1.4 知道你的数据叫什么

任务一:pandas中有两个数据类型DateFrame和Series,通过查找简单了解他们。

DateFrame可理解为表格,Series为单独的行或列

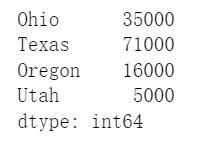

#Series举例

sdata = {'Ohio': 35000, 'Texas': 71000, 'Oregon': 16000, 'Utah': 5000}

example_1 = pd.Series(sdata)

example_1

#DataFrame举例

data = {'state': ['Ohio', 'Ohio', 'Ohio', 'Nevada', 'Nevada', 'Nevada'],'year': [2000, 2001, 2002, 2001, 2002, 2003],'pop': [1.5, 1.7, 3.6, 2.4, 2.9, 3.2]}

example_2 = pd.DataFrame(data)

example_2

任务二:根据上节课的方法载入"train.csv"文件

colnames=['乘客ID','是否幸存','乘客等级(1/2/3等舱位)','乘客姓名','性别','年龄','堂兄弟/妹个数','父母与小孩个数','船票信息','票价','客舱','登船港口']

df = pd.read_csv(r"..\titanic\train.csv",names=colnames,index_col='乘客ID')任务三:查看DataFrame数据的每列的名称

df.columns任务四:查看"Cabin"这列的所有值

print(df['Cabin'])

print(df.Cabin)

这篇关于Datawhale《动手学数据分析》Task01:数据加载及探索性数据分析笔记1的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!