本文主要是介绍关于Spark SQL外部表在实战中遇到的问题,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

笔者之前写过一篇关于Spark SQL外部表的比较全面的学习实验博客,参https://blog.csdn.net/u011817217/article/details/92403843

本篇旨在描述和总结在实际工作中使用Spark SQL外部表遇到的一些问题以及相应的解决方案。

一、需求描述

外围系统通过文件接口的方式定期给一份数据文件,关于接口描述和数据文件示例如下:

1. 文件接口内容

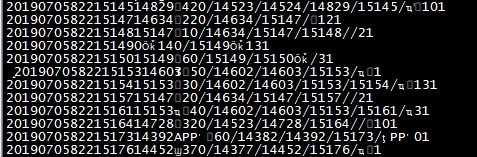

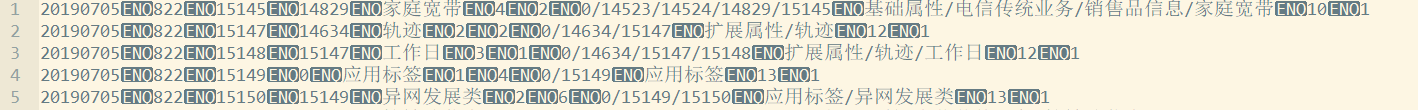

2. 数据文件示例

1)Linux上查看

2)Windows上Notepad++查看

二、创建外部表并导入数据文件

1. 建表语句

create external table ci_interface_label_catelog(day_id string,prvnce_id string,category_id bigint,category_parent_id bigint,category_name string,category_level int,category_ord int,category_path string,category_path_desc string,label_object string,class_status string

)

row format delimited fields terminated by '\u0005'

lines terminated by '\n'

stored as textfile location 'hdfs://streamcluster/hupeng/data/ci_interface';2. 导入数据文件

通过hdfs dfs -put -f 命令将本地的数据文件上传到HDFS的/hupeng/data/ci_interface目录下。

hdfs dfs -put data_file.DAT /hupeng/data/ci_interface三、问题及解决方法

1. 中文显示乱码

尝试指定表的编码格式:

ALTER TABLE ci_interface_label_catelog SET SERDEPROPERTIES ('serialization.encoding'='GBK');

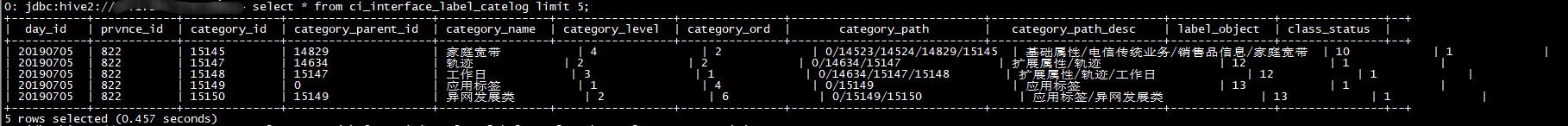

效果如上图,虽然中文显示正常了,但是通过查看数据发现class_stauts字段值出现混乱的情况,和实际数据文件给定的内容不一致。

2. 部分字段值和数据文件不一致

出现这个原因是因为在进行了上面的操作,初步怀疑是不是数据文件编码的问题。

1)将数据文件编码转换成UTF-8格式:

iconv -c -f GBK -t UTF-8 LABEL_CATELOG.20190705.20190705.01.001.001.822.DAT -o export.txt

2)修改表的编码格式

ALTER TABLE ci_interface_label_catelog SET SERDEPROPERTIES ('serialization.encoding'='UTF-8');

3)hdfs dfs -put -f

hdfs dfs -put -f export.txt /hupeng/data/ci_interface

一切都正常。

3. 验证创建表的默认编码是不是UTF-8

1)drop table ci_interface_label_catelog;

2)重新建表

3)将数据文件编码转换成UTF-8格式

4)hdfs dfs -put -f

结果和2中一致,表明创建表的默认编码是UTF-8。

这篇关于关于Spark SQL外部表在实战中遇到的问题的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!