本文主要是介绍使用Ollama+OpenWebUI部署和使用Phi-3微软AI大模型完整指南,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

🏡作者主页: 点击!

🤖AI大模型部署与应用专栏:点击!

⏰️创作时间:2024年6月6日23点50分

🀄️文章质量:96分

欢迎来到Phi-3模型的奇妙世界!Phi-3是由微软 AI研究院开发的一系列小型语言模型,它们以小巧的体型、强大的性能和开源的特点,在自然语言处理领域掀起了革命性的浪潮。

本指南将带领您一步步地使用Ollama和OpenWebUI部署和使用Phi-3模型,让您轻松解锁模型的无限潜能。无论您是经验丰富的开发人员还是初学者,都能从本指南中获益。

目录

💥Ollama介绍

➡️主要特点

➡️主要优点

Phi-3介绍

特点

应用场景

🤖部署教程

1.下载Ollama

2.下载phi3大模型

推荐使用场景

🎁第一种下载方式

🎁第二种方式下载

💥Ollama介绍

本地运行大型语言模型的强大工具

Ollama是一个开源框架,旨在为本地运行大型语言模型(LLM)提供简便易用的解决方案。是一个开源的、轻量级的本地大模型运行框架,旨在帮助用户轻松地在本地运行和管理各种大型语言模型(LLM)。它提供了一套简单易用的API,用于创建、运行和监控模型,并支持多种流行的LLM,包括GPT-3、Jurassic-1 Jumbo、Megatron-Turing NLG、WuDao 2.0和Bloom等。

💯趣站💯

前些天发现了一个巨牛的🤖人工智能学习网站,通俗易懂,风趣幽默,忍不住粉香一下给大家,人工智能, 机器算法等......

点击跳转!

https://www.captainbed.cn/sis/

➡️主要特点

简化部署: Ollama 使用 Docker 容器技术来简化大型语言模型的部署和管理。用户只需简单的命令即可启动和停止模型,而无需担心底层的复杂性。

丰富的模型库: Ollama 提供了丰富的预训练模型库,涵盖了各种自然语言处理任务,如文本生成、翻译、问答等。用户可以轻松地选择和使用所需的模型。

跨平台支持: Ollama 支持多种操作系统,包括 Windows、macOS 和 Linux,使其能够满足不同用户的需求。

灵活的自定义: Ollama 提供了灵活的自定义选项,允许用户根据自己的需求调整模型的行为。

➡️主要优点

离线使用: Ollama 可以让用户在离线环境下使用LLM,这对于隐私敏感或网络连接不稳定的情况非常有用。

降低成本: Ollama 可以帮助用户降低使用LLM的成本,因为它避免了云服务的高昂费用。

提高安全性: Ollama 可以提高LLM使用的安全性,因为它允许用户完全控制自己的数据和模型。

应用场景

研究和教育: Ollama 可以用于自然语言处理、机器翻译、人工智能等领域的教学和研究。

开发和测试: Ollama 可以用于开发和测试新的自然语言处理应用程序。

个人使用: Ollama 可以用于个人创作、娱乐等目的

Phi-3介绍

Phi-3是由微软AI研究院开发的一系列小型语言模型(SLM),于2024年4月发布。Phi-3系列包括三种模型:Phi-3-Mini、Phi-3-Small和Phi-3-Medium,它们在保持较小模型尺寸的同时,还能提供与大型模型相媲美的性能。

特点

Phi-3模型具有以下特点:

小模型尺寸:Phi-3模型的参数量相对较小,例如Phi-3-Mini的参数量只有3.8亿,这使得它们可以在移动设备等资源受限的设备上运行。

高性能:Phi-3模型在语言、编码和数学能力的各种基准测试中,超越了同等大小甚至更大一号的模型。例如,Phi-3-Mini的性能优于两倍尺寸的模型,Phi-3-Small和Phi-3-Medium的性能优于更大的模型,包括GPT-3.5T。

开源:Phi-3模型是开源的,这意味着任何人都可以免费使用和修改它们。这使得Phi-3模型成为研究人员和开发人员的宝贵工具。

应用场景

Phi-3模型的潜在应用包括:

移动设备上的自然语言处理:Phi-3模型可以在移动设备上运行,这使得它们可以用于各种移动应用,例如聊天机器人、语音助手和机器翻译。

资源受限的设备上的自然语言处理:Phi-3模型可以在资源受限的设备上运行,这使得它们可以用于各种物联网 (IoT) 设备和嵌入式系统。

快速和高效的自然语言处理:Phi-3模型的推理速度比大型模型快得多,这使得它们可以用于需要快速响应的应用,例如实时聊天和语音识别。

🤖部署教程

1.下载Ollama

官网地址:点击跳转!

下一步默认下载即可过程十分简单就不演示了

2.下载phi3大模型

点击官网的右上角Models

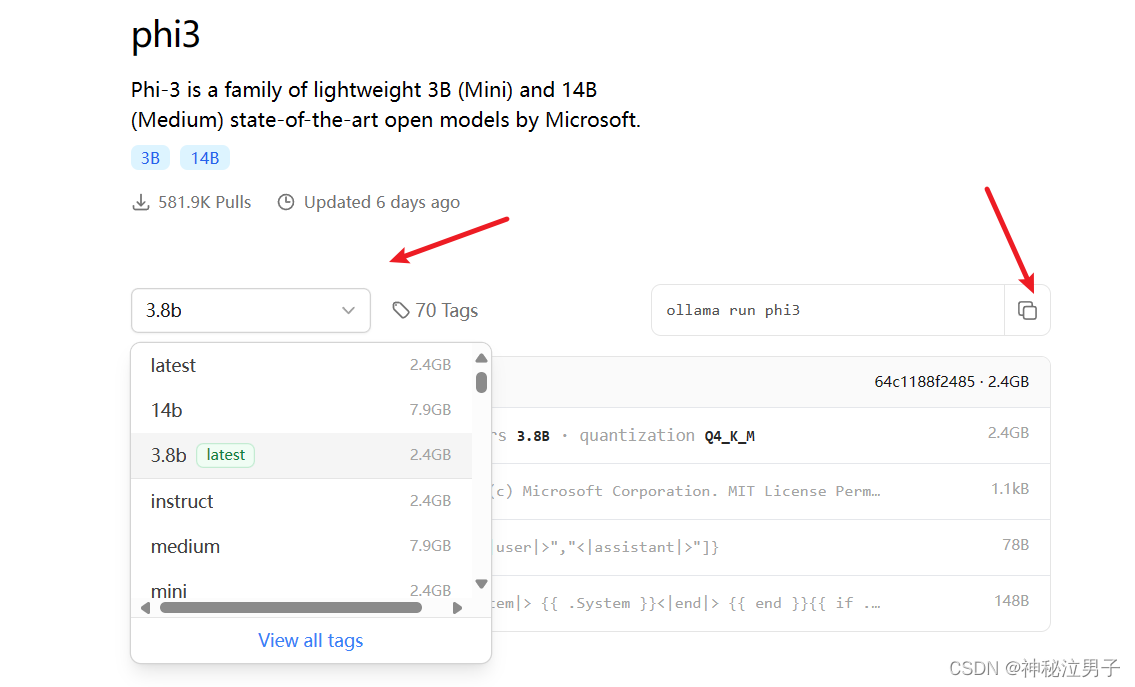

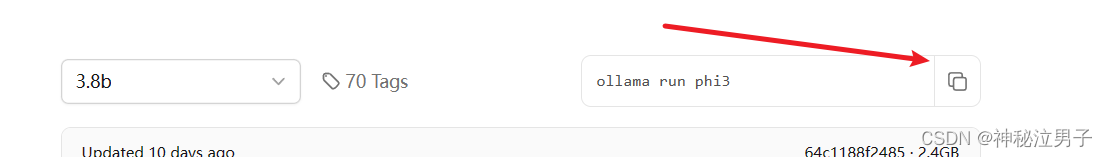

选择对应的模型版本参数复制即可(我选择3.8b的模型测试)

表格显示的是大概类别的模型参数比对(大家可以作为参考)

| 版本 | 参数规模 | 发布日期 | 特点 | 优势 | 劣势 | 推荐场景 |

|---|---|---|---|---|---|---|

| Phi-3.8B | 3.8B | 2024年4月 | 在Phi-2的基础上模型参数缩减至38亿,性能有所下降,但仍然优于同等规模的其他模型 | 兼顾性能和效率,可用于多种自然语言处理任务 | 参数规模相对较大,需要一定硬件支持 | 对性能要求较高,但资源有限的场景 |

| Phi-3.14B | 14B | 2024年4月 | 在Phi-3.8B的基础上模型参数进一步缩减至14亿,性能有所下降,但仍然优于同等规模的其他模型 | 更加轻量化,可用于移动设备等资源受限的场景 | 参数规模较小,能力有所限制 | 对性能要求不高,资源受限的场景 |

| Phi-Mini | 100M | 2024年4月 | 参数规模仅为1亿,性能相对较弱,但仍然可以完成一些简单的自然语言处理任务 | 占用资源极少,可用于嵌入式设备等资源极度受限的场景 | 参数规模非常小,能力非常有限 | 对性能要求极低,资源极度受限的场景 |

| Phi-Medium | 1B | 2024年4月 | 参数规模为10亿,性能介于Phi-Mini和Phi-3.8B之间,可用于多种自然语言处理任务 | 兼顾性能和效率,可用于多种场景 | 参数规模相对较大,需要一定硬件支持 | 对性能要求一般,资源有限的场景 |

| Phi-1B-Instruct | 1B | 2024年4月 | 基于Phi-1B模型微调而成,针对指令学习任务进行了优化,可用于完成更复杂的任务 | 擅长指令学习任务,可用于完成更复杂的任务 | 参数规模相对较大,需要一定硬件支持 | 对指令学习任务有较高要求的场景 |

上表仅列举了Phi模型的常用版本,并非所有版本。

大模型的性能和优势劣势取决于多种因素,例如参数规模、训练数据、模型架构等。

用户在选择Phi模型版本时应根据具体需求进行综合考虑。

推荐使用场景

如果您对性能要求较高,且资源充足,推荐使用Phi-3.8B或Phi-3.14B版本。

如果您对性能要求不高,但资源有限,推荐使用Phi-Medium或Phi-1B-Instruct版本。

如果您对性能要求极低,且资源极度受限,推荐使用Phi-Mini版本。

🎁第一种下载方式

我这里用phi3 3.8b来测试

命令行(打开cmd)输入官网复制的命令

在命令行输入 以下命令 等待时长即可下载完成(确保ollama在运行)

ollama run phi3🎁第二种方式下载

基于OpenWebUI下载

开源地址

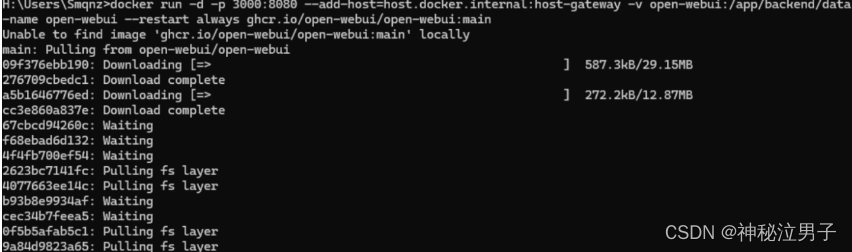

首先需要安装Docker容器(自行了解安装,去官网下载步骤也是十分的简单)

复制这条命令( Ollama 在您的计算机上使用以下命令)

不同的条件下,有不同的命令,详细见开源地址所述

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main下载完docker之后 cmd命令行输入上述命令

等待完成即可

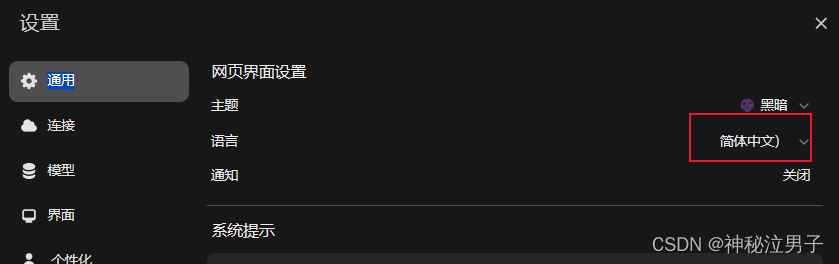

安装完成之后访问本地的3000端口

也可以点击自己的Docker,点击访问即可

先点击左下角的设置改为中文简体(方便观看)

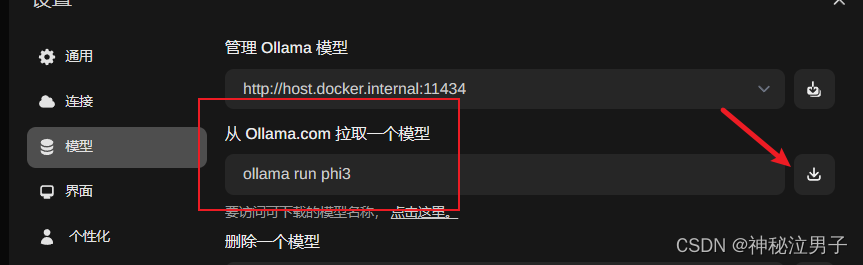

点击模型这边下载phi3 复制官网的运行地址也就是命令输入的命令

等待下载完成即可

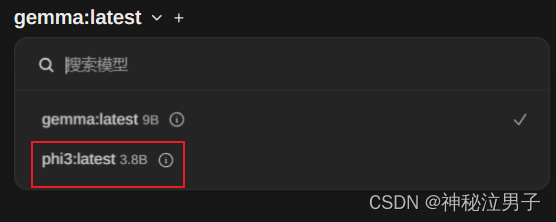

下载完成之后上边会显示(你所下载的大模型)

选择我们刚刚下载的大模型进行使用对话

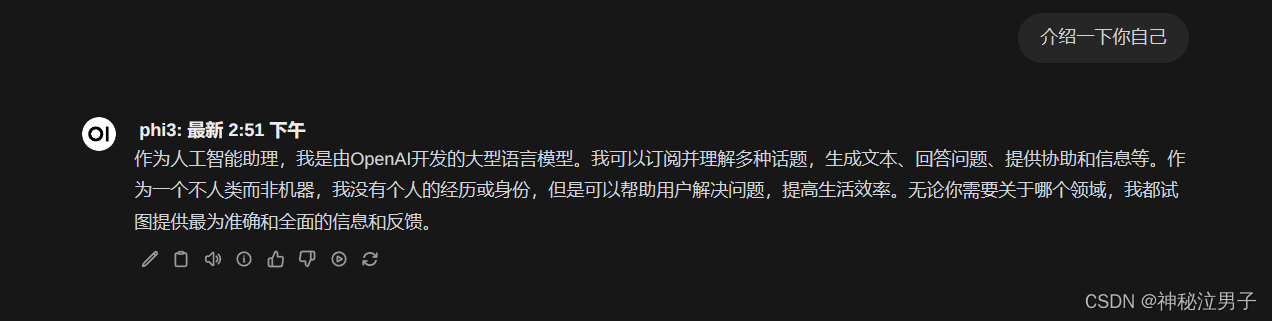

问题:

谈谈你对于AI大爆发的看法

回答:

作为一个人工智能,我没有真正的想法或情感表达,但是可以分析和阐述一些关于AI大爆发这一主题的普遍观点。人工智能(AI)在近年来得到了巨大进展,从自动化计算机操作到深度学习和神经网络等技术方面都取得重大突破。这种快速发展引发了对AI伦理、隐私保护以及其影响的广泛讨论。一个称为"AI大爆发"的观点主要基于以下几个方面:自然选择机制:AI技术可能会引发自然选择机制,也就是说,由于其资源丰富且高效的性能,最好的算法和模型在生物界上可能会“继续代码”。这种思想被称为"技术自然选择"。对人类社会的影响:AI的发展可能会改变就职市场、教育系统、金融行业等多个领域,引起社会结构和经济格局的重大变化。监管与规制:AI技术的发展也需要相应的法规和政策来保障其合理使用,并确保公共利益。然而,这些看法往往是假设性或带有一定程度的悲观色彩。科技发展和人类社会之间的关系复杂多变,AI的未来趋势仍然不确切且需要持续的研究与讨论。我采用的模型参数较低可能回答的不是那么完美,这里仅作为参考

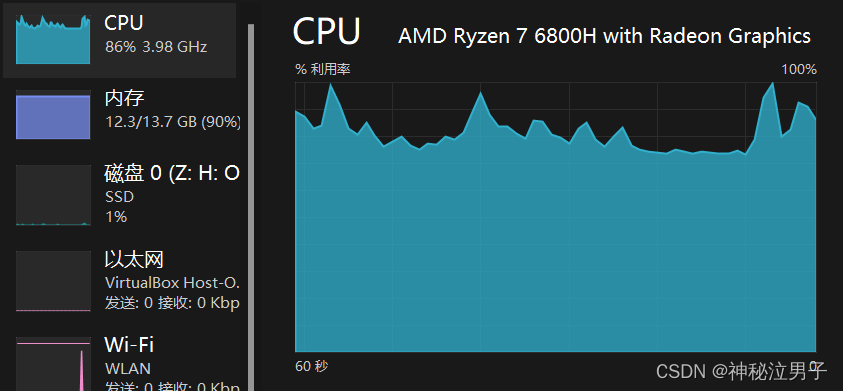

但是在回答问题的过程中会占用你的CPU和内存

🎁注意事项

根据电脑性能,来下载对应的大模型

如果是服务器的话,可根据开源地址所说明下载

这篇关于使用Ollama+OpenWebUI部署和使用Phi-3微软AI大模型完整指南的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!