本文主要是介绍pytorch-Normalization,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

- 1. 为什么Normalization

- 2. Normalization

- 2.1 image Normalization

- 2.2 Batch Normalization

- 3. Normalization pytorch实现

- 3.1 Normalization标准公式

- 3.2 2d normalization

- 3.3 normalize test

- 4. 使用normalization的好处

1. 为什么Normalization

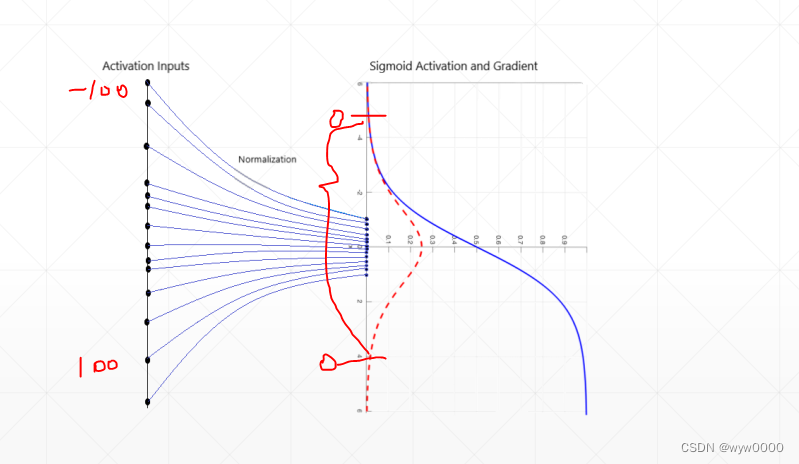

下图使用sigmoid激活函数,该激活函数在超出一定范围的时候,梯度就变成了0,会出现梯度弥散的现象,因此不推荐使用sigmoid,但是某些情况下又不得不使用。

normalization是将输入转换为以0为均值以σ为方差的范围内,使得输入变成在0附近以很小的幅度变化,方便下一层进行优化。

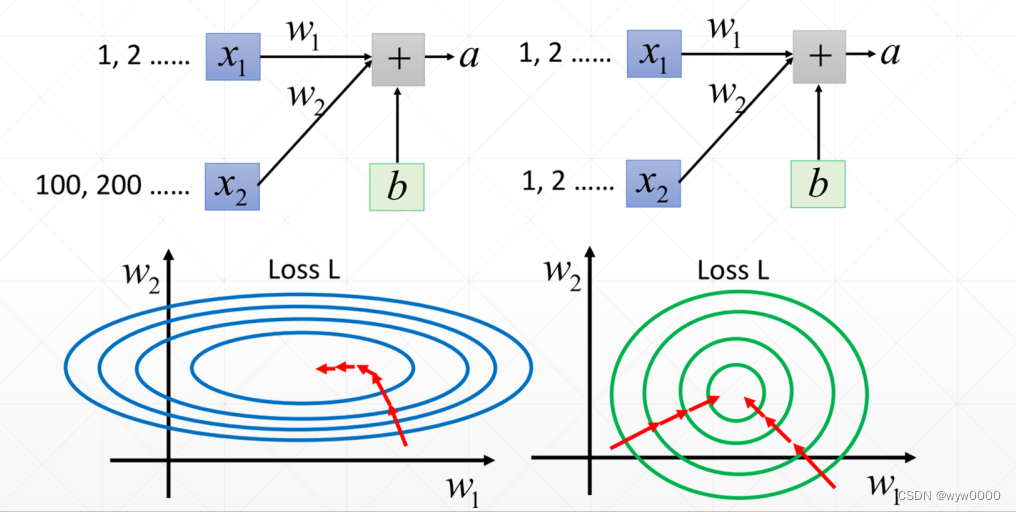

在看下一幅图,其中前半部分x1和x2的值范围相差较大,在计算loss的时候,找到最优解会曲折一些,而后半部分x1和x2的值的范围相差不大,在计算loss的时候,找到最优解就会比较直接,更快一些。

因此使用normalization将输入转换的一个区间,有助于loss尽快找到最优解。

2. Normalization

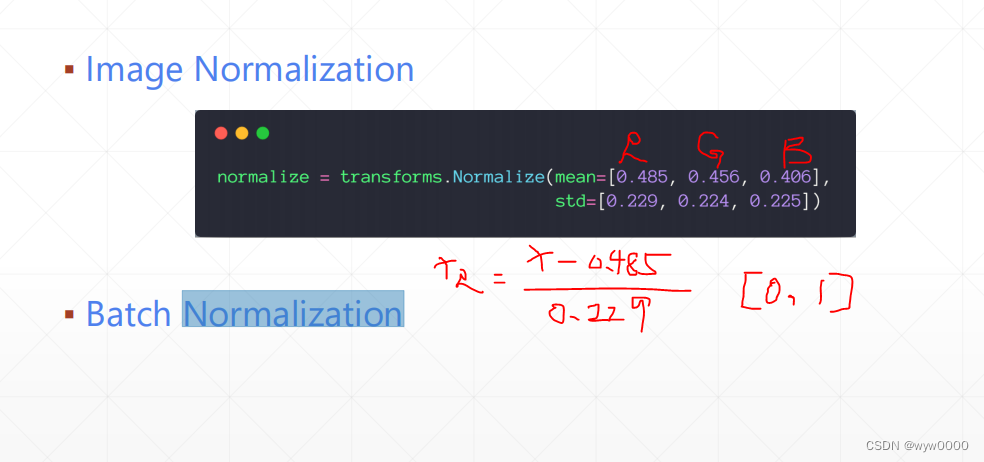

2.1 image Normalization

2.2 Batch Normalization

Normalization有下图几种,这里只说Batch Normalization

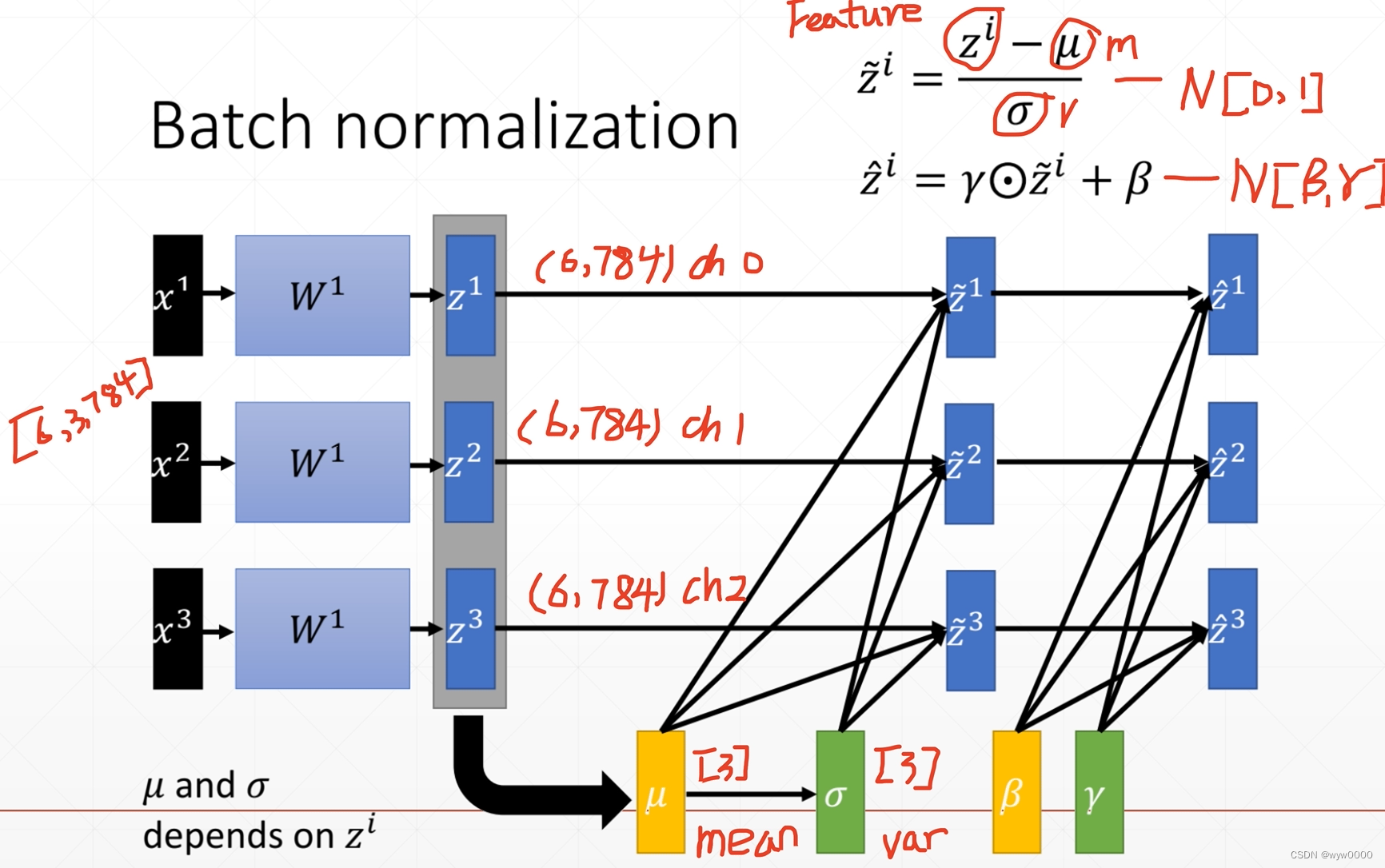

假设H和W都说28,有3个通道和6个batch,那么就分别计算当前batch每个channel的均值和方差(channel0~channel2),最后输出结果是消掉batch和feature,有几个通道就有几个均值和方差,

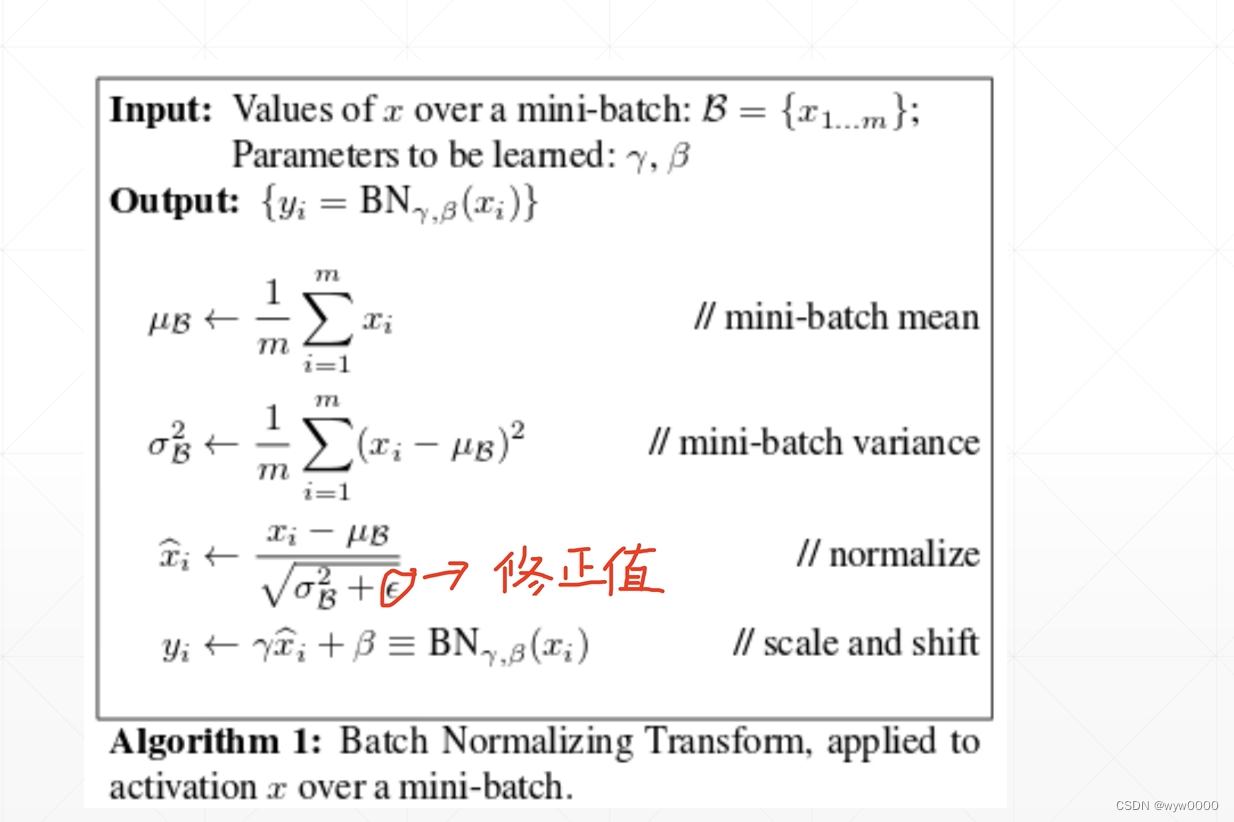

下图中第一个公式使用当前batch的feature- mean/var 使得值变成[0,1]

第二个公式在第一个公式的基础上增加了一个γ倍数和偏置β,使得数据变为[β,γ]之间。

μ和σ是当前batch统计出来,不需要梯度,而β,γ是计算出来的是需要梯度信息的,在训练时还有一个running-μ和running-σ是历史统计,即之前所有batch的统计。

3. Normalization pytorch实现

3.1 Normalization标准公式

3.2 2d normalization

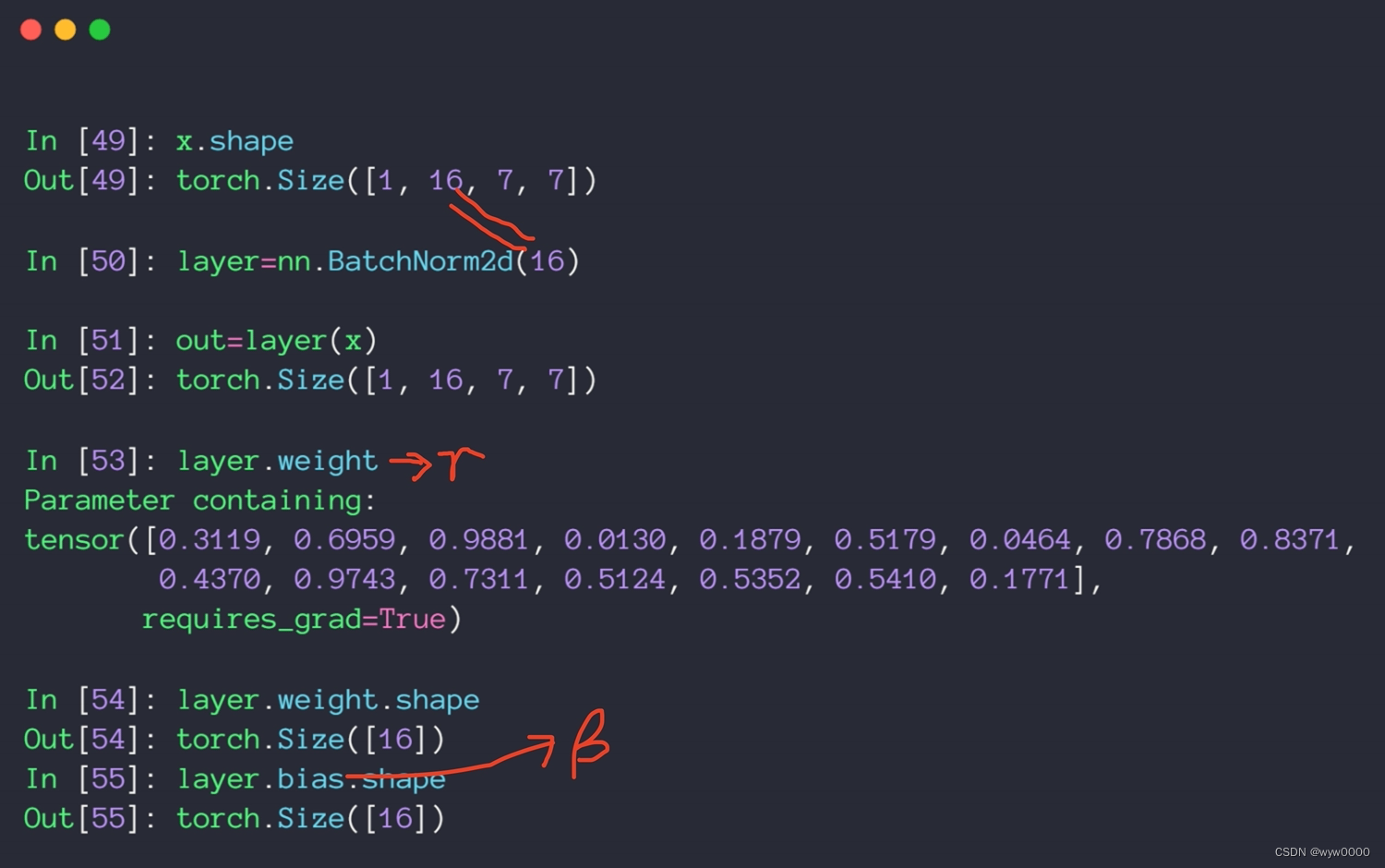

下图中的layer.weight就是γ,bias就是β

BatchNorm2d的参数必须与输入channel数一致,否则会报错。

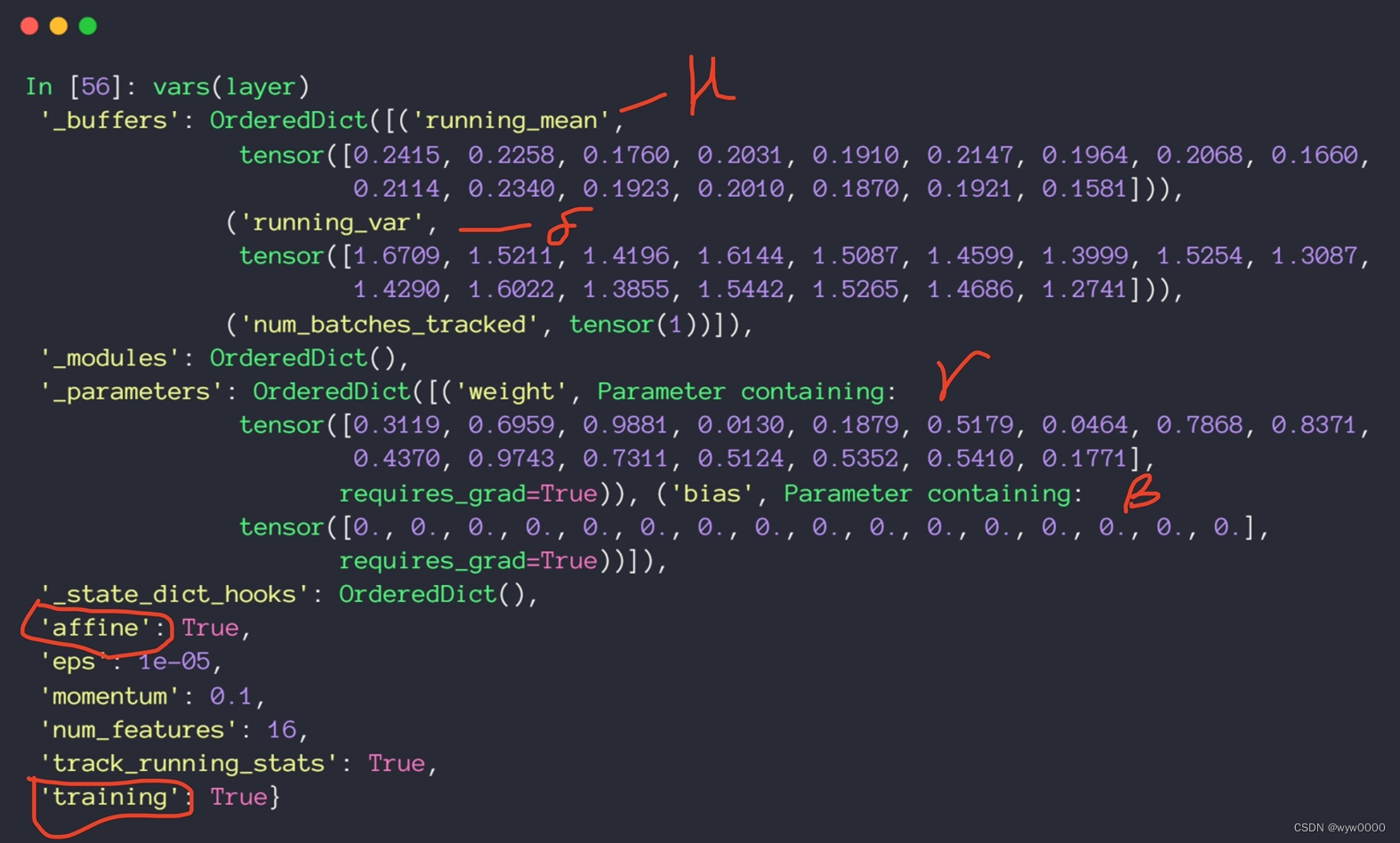

打印normalize layer,信息可以看到running-μ和running-σ以及β,γ

affine参数决定了β,γ是否需要更新

3.3 normalize test

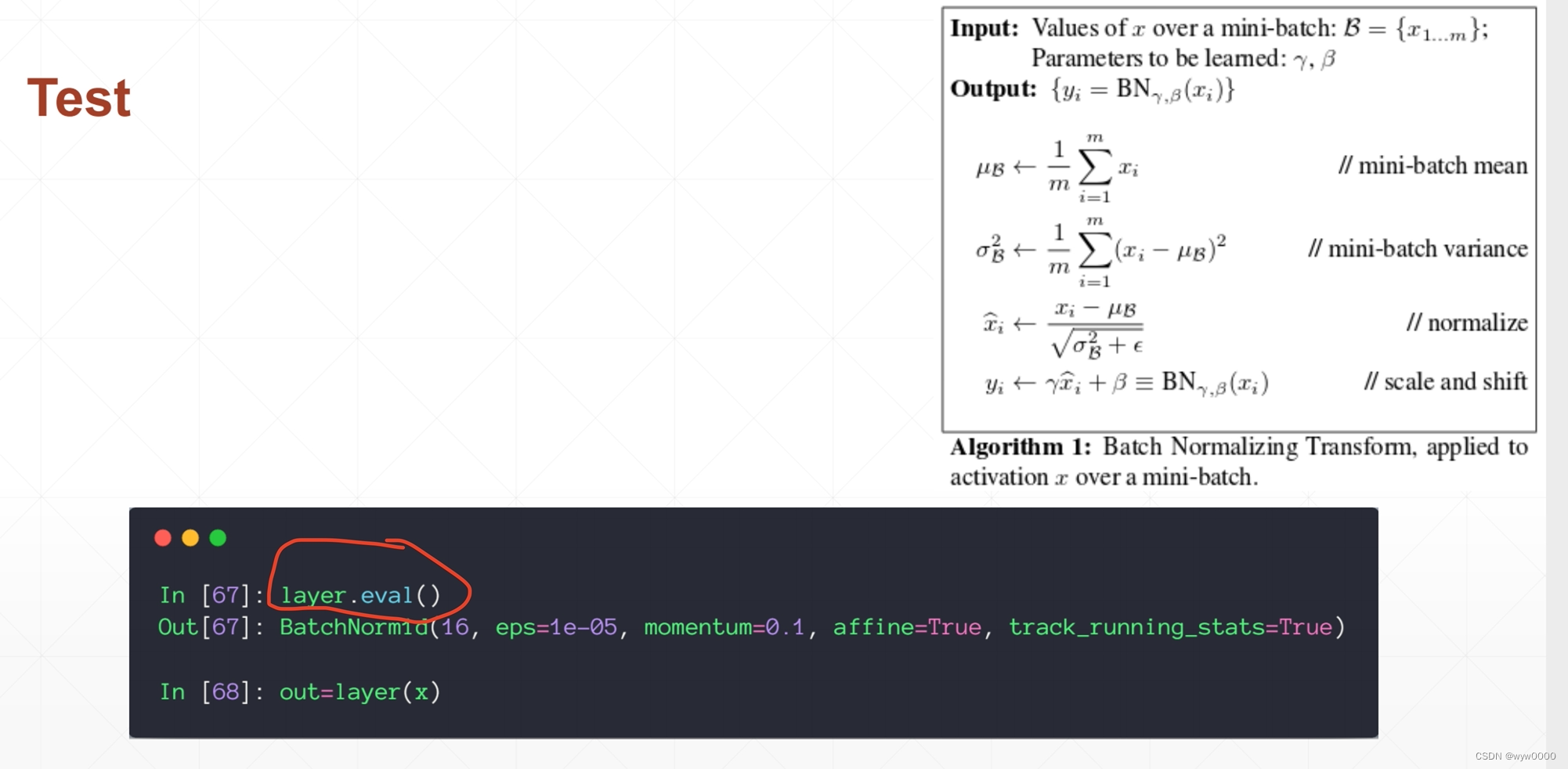

Normalization layer和drop out layer类似,train和test的行为是不一样的

具体表现为:

- test可能就一个sample 所以是无法统计μ和σ的

- μ和σ=running-μ和running-σ

- test 没有back forward,因此β,γ是不需要更新的

切换test模式使用layer.eval()函数

4. 使用normalization的好处

- 收敛更快

- 更好获得最优解

- 更稳定。在使用大leaning rate的时候震荡不会那么明感

这篇关于pytorch-Normalization的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!