本文主要是介绍多页数据的爬取(使用ItemLoader填充容器),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

使用ItemLoader填充容器

- 目前我们爬取的数据的字段较少,但是当项目很大、提取的字段数以百计时,数据的提取规则也会越来越多,再加上还要对提取到的数据做转换处理,代码就会变得庞大,维护起来十分困难。

- 为了解决这个问题,Scrapy提供了项目加载器(ItemLoder)这样一个填充容器。通过填充容器,可以配置Item中各个字段的提取规则,并通过函数分析原始数据,最后对Item字段赋值,使用起来非常便捷。

- Item和ItemLoder的区别在于:

- Item提供了保存抓取到的数据的容器,需要手动保存于容器中。

- Itemloder提供的是填充容器的机制。

- 下面使用ItemLoder来改写起点中文网小说热搜榜的项目。打开爬虫(Spider)源文件qidian_hot.py。

- 1.导入ItemLoader类

- 代码如下

from scrapy.loader import ItemLoader #导入ItemLoder类

- 2.实例化ItemLoader对象

- 在使用ItemLoder之前,必须先将其实例化。来看一下数据解析函数qidian_parse()的实现代码:

# 解析函数def qidian_parse(self,response):# 使用xpath定位到小说的div元素,保存到列表中list_selector = response.xpath("//div[@class='book-mid-info']")# 依次读取每部小说的元素,从中获取小说名称、作者、类型和形式for one_selector in list_selector:# 生成ItemLoader的实例# 参数item接收QidianHotItem实例,selector接收一个选择器novel = ItemLoader(item=QidianHotItem(),selector=one_selector)# 使用XPath获取小说名称novel.add_xpath("name","h4/a/text()")# 使用XPath获取作者novel.add_xpath("author", "p[1]/a[1]/text()")# 使用XPath获取类型novel.add_xpath("type", "p[1]/a[2]/text()")# 使用XPath获取形式(连载还是完本)novel.add_xpath("form", "p[1]/span/text()")# 使用CSS选择器获取小说形式(连载还是完本)# novel.add_xpath("form", ".author span::text")# 将提取好的数据load出来,并使用yield返回yield novel.load_item()

- 很明显,使用ItemLoader实现的Spider功能,代码量更少、更加清晰。因为ItemLoader将数据提取与封装的功能全实现了。

- 在实例化ItemLoader时,ItemLoader接收一个item实例来指定要加载的Item(参数item);指定response或者selector来确定要解析的内容(参数response或selector)。

- 3.使用ItemLoader填充数据

- 实例化ItemLoader对象后,就要开始提取数据到ItemLoader中了。ItemLoader提供了3种重要的方法将数据填充进来。

- add_xpath():使用XPath选择器提取数据。

- add_css():使用CSS选择器提取数据。

- add_value():直接传值。

- 以上3个方法中都有两个参数,第一个参数指定字段名,第二个参数指定对应的提取规则或者传值。

- 在上面的代码中,小说名称、作者、类型都是通过add_xpath填充到ItemLoader实例对象中,而小说形式是通过add_css填充的(#部分)。add_value用于直接传值,例如

novel.add_value("form","连载") #字段form值设置为字符串“连载”

- 4.给Item对象赋值

- 当提取的数据被填充到ItemLoader后,还需要调用load_item()方法给Item对象赋值。

- 5.进一步处理数据

- 下面两个问题一定也困扰着大家:

- (1)使用ItemLoader提取的数据,也是保存于列表中的,以前可以通过extract_first()或者extract()获取列表中的数据,但是ItemLoader中是如何实现呢?以下为生成的数据格式:

{'author':['卖报小郎君'],'form':['连载'],'name':['大奉打更人'],'type':['玄幻']}

- (2) 很多时候,我们还需要将选择器(XPath或CSS)提取出来的数据做进一步的处理,例如去除空格、提取数字或格式化数据等。这些数据又在哪里实现的呢?解决办法是,使用输入处理器(input_processor)和输入处理器(output_processor)对数据的输入和输出进行解析。

- 下面来看一个例子,实现将提取出来的小说形式(连载/完结)转换为简写形式(LZ/WJ)。下面在items.py中实现这个功能,实现代码如下:

import scrapy

# from scrapy.loader import ItemLoader #导入ItemLoder类

from itemloaders.processors import TakeFirst

# 定义一个转换小说形式的函数

def form_convert(form):if form[0] == "连载":return "LZ"else:return "WJ"# 保存小说热销榜字段数据

class QidianHotItem(scrapy.Item):# TakeFirst为内置处理器,获取列表中第一个非空数据name = scrapy.Field(output_processor=TakeFirst()) #小说名称author = scrapy.Field(output_processor=TakeFirst()) # 作者type = scrapy.Field(output_processor=TakeFirst()) # 类型form = scrapy.Field(input_processor=form_convert,output_processor=TakeFirst()) #形式- 首先定义了一个转换小说形式的函数form_convert()。参数如果为“连载”,则返回LZ;否则返回WJ。

- 在QidianHotItem类中,scrapy.Field()中设置了两个参数(或其中之一):输入处理器(input_processor)和输出处理器(output_processor)。output_processor绑定了函数TakeFirst()。TakeFirst()函数为Scrapy内置的处理器,用于获取集合中第一个非空值。form为小说的字段,scrapy.Field()的参数input_processor绑定了函数form_convert()。当ItemLoader通过选择器(XPath或CSS)提取某字段数据后,就会将其发送给输入处理器进行处理,然后将处理完的数据发送给输出处理器做最后一次处理。最后调用load_item()函数间将数据填充进ItemLoader,并得到填充后的Item对象。每个字段的处理过程如下

- 6.运行项目

- 在终端中通过以下命令运行项目:

from scrapy.loader import ItemLoader #导入ItemLoder类

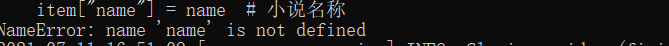

- 结果一直报错

这篇关于多页数据的爬取(使用ItemLoader填充容器)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!