本文主要是介绍C# Onnx 使用onnxruntime部署实时视频帧插值,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

介绍

效果

模型信息

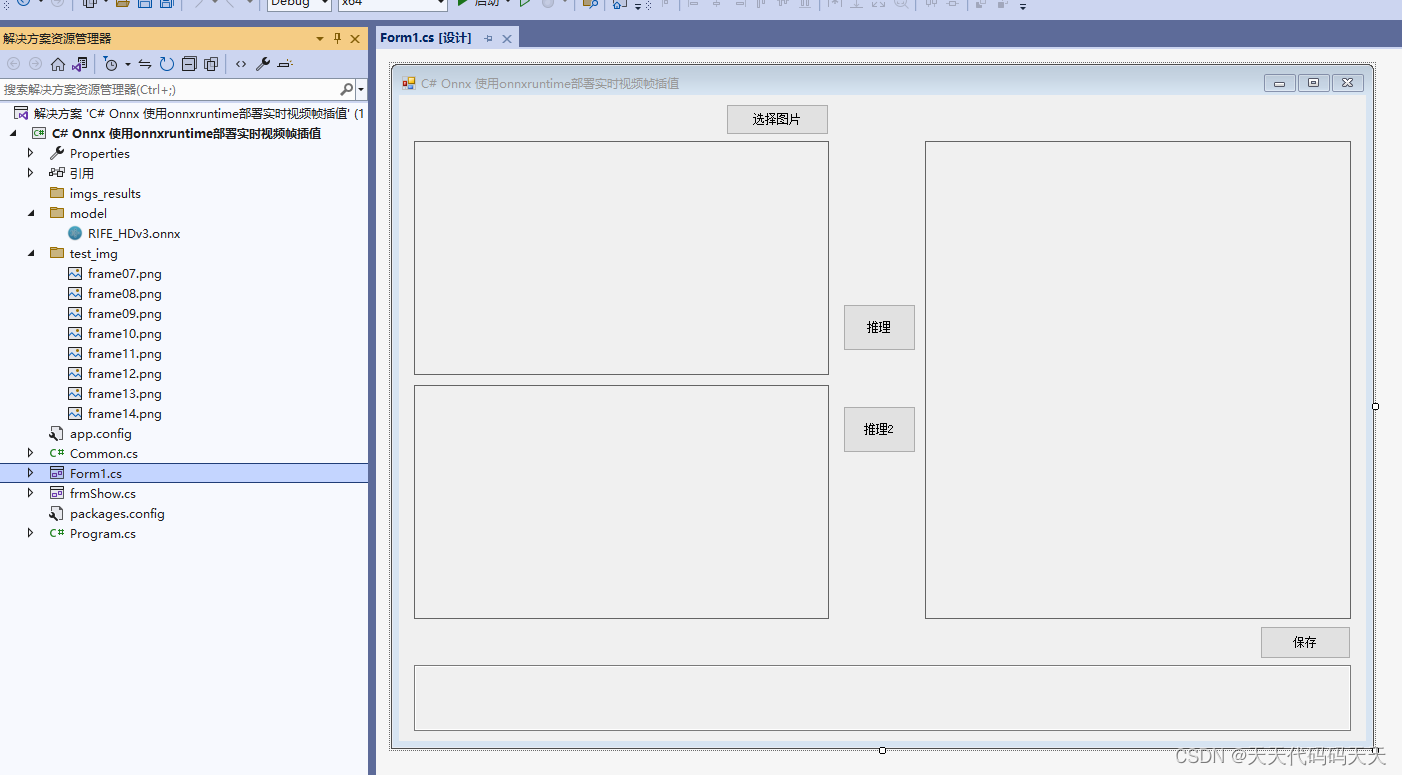

项目

代码

下载

C# Onnx 使用onnxruntime部署实时视频帧插值

介绍

github地址:https://github.com/google-research/frame-interpolation

FILM: Frame Interpolation for Large Motion, In ECCV 2022.

The official Tensorflow 2 implementation of our high quality frame interpolation neural network. We present a unified single-network approach that doesn't use additional pre-trained networks, like optical flow or depth, and yet achieve state-of-the-art results. We use a multi-scale feature extractor that shares the same convolution weights across the scales. Our model is trainable from frame triplets alone.

FILM transforms near-duplicate photos into a slow motion footage that look like it is shot with a video camera.

效果

模型信息

Model Properties

-------------------------

---------------------------------------------------------------

Inputs

-------------------------

name:I0

tensor:Float[1, 3, -1, -1]

name:I1

tensor:Float[1, 3, -1, -1]

---------------------------------------------------------------

Outputs

-------------------------

name:merged

tensor:Float[1, -1, -1, -1]

---------------------------------------------------------------

项目

代码

using Microsoft.ML.OnnxRuntime;

using Microsoft.ML.OnnxRuntime.Tensors;

using OpenCvSharp;

using OpenCvSharp.Dnn;

using System;

using System.Collections.Generic;

using System.Drawing;

using System.Drawing.Imaging;

using System.Linq;

using System.Numerics;

using System.Windows.Forms;

namespace Onnx_Yolov8_Demo

{

public partial class Form1 : Form

{

public Form1()

{

InitializeComponent();

}

string fileFilter = "*.*|*.bmp;*.jpg;*.jpeg;*.tiff;*.tiff;*.png";

string image_path = "";

string startupPath;

DateTime dt1 = DateTime.Now;

DateTime dt2 = DateTime.Now;

string model_path;

Mat image;

Mat result_image;

SessionOptions options;

InferenceSession onnx_session;

Tensor<float> input_tensor;

Tensor<float> input_tensor2;

List<NamedOnnxValue> input_container;

IDisposableReadOnlyCollection<DisposableNamedOnnxValue> result_infer;

DisposableNamedOnnxValue[] results_onnxvalue;

Tensor<float> result_tensors;

float[] result_array;

float[] input1_image;

float[] input2_image;

int inpWidth;

int inpHeight;

private void button1_Click(object sender, EventArgs e)

{

OpenFileDialog ofd = new OpenFileDialog();

ofd.Filter = fileFilter;

if (ofd.ShowDialog() != DialogResult.OK) return;

pictureBox1.Image = null;

image_path = ofd.FileName;

pictureBox1.Image = new Bitmap(image_path);

textBox1.Text = "";

image = new Mat(image_path);

pictureBox2.Image = null;

}

void Preprocess(Mat img, ref float[] input_img)

{

Mat rgbimg = new Mat();

Cv2.CvtColor(img, rgbimg, ColorConversionCodes.BGR2RGB);

int h = rgbimg.Rows;

int w = rgbimg.Cols;

int align = 32;

if (h % align != 0 || w % align != 0)

{

int ph = ((h - 1) / align + 1) * align;

int pw = ((w - 1) / align + 1) * align;

Cv2.CopyMakeBorder(rgbimg, rgbimg, 0, ph - h, 0, pw - w, BorderTypes.Constant, 0);

}

inpHeight = rgbimg.Rows;

inpWidth = rgbimg.Cols;

rgbimg.ConvertTo(rgbimg, MatType.CV_32FC3, 1 / 255.0);

int image_area = rgbimg.Rows * rgbimg.Cols;

//input_img = new float[3 * image_area];

input_img = Common.ExtractMat(rgbimg);

}

Mat Interpolate(Mat srcimg1, Mat srcimg2)

{

int srch = srcimg1.Rows;

int srcw = srcimg1.Cols;

Preprocess(srcimg1, ref input1_image);

Preprocess(srcimg2, ref input2_image);

// 输入Tensor

input_tensor = new DenseTensor<float>(input1_image, new[] { 1, 3, inpHeight, inpWidth });

input_tensor2 = new DenseTensor<float>(input2_image, new[] { 1, 3, inpHeight, inpWidth });

//将tensor 放入一个输入参数的容器,并指定名称

input_container.Add(NamedOnnxValue.CreateFromTensor("I0", input_tensor));

input_container.Add(NamedOnnxValue.CreateFromTensor("I1", input_tensor2));

//运行 Inference 并获取结果

result_infer = onnx_session.Run(input_container);

// 将输出结果转为DisposableNamedOnnxValue数组

results_onnxvalue = result_infer.ToArray();

// 读取第一个节点输出并转为Tensor数据

result_tensors = results_onnxvalue[0].AsTensor<float>();

int out_h = results_onnxvalue[0].AsTensor<float>().Dimensions[2];

int out_w = results_onnxvalue[0].AsTensor<float>().Dimensions[3];

result_array = result_tensors.ToArray();

for (int i = 0; i < result_array.Length; i++)

{

result_array[i] = result_array[i] * 255;

if (result_array[i] < 0)

{

result_array[i] = 0;

}

else if (result_array[i] > 255)

{

result_array[i] = 255;

}

result_array[i] = result_array[i] + 0.5f;

}

float[] temp_r = new float[out_h * out_w];

float[] temp_g = new float[out_h * out_w];

float[] temp_b = new float[out_h * out_w];

Array.Copy(result_array, temp_r, out_h * out_w);

Array.Copy(result_array, out_h * out_w, temp_g, 0, out_h * out_w);

Array.Copy(result_array, out_h * out_w * 2, temp_b, 0, out_h * out_w);

Mat rmat = new Mat(out_h, out_w, MatType.CV_32F, temp_r);

Mat gmat = new Mat(out_h, out_w, MatType.CV_32F, temp_g);

Mat bmat = new Mat(out_h, out_w, MatType.CV_32F, temp_b);

result_image = new Mat();

Cv2.Merge(new Mat[] { bmat, gmat, rmat }, result_image);

result_image.ConvertTo(result_image, MatType.CV_8UC3);

Mat mid_img = new Mat(result_image, new Rect(0, 0, srcw, srch));

return mid_img;

}

private void button2_Click(object sender, EventArgs e)

{

button2.Enabled = false;

pictureBox2.Image = null;

textBox1.Text = "正在运行,请稍后……";

Application.DoEvents();

dt1 = DateTime.Now;

List<String> inputs_imgpath = new List<String>() { "test_img/frame07.png", "test_img/frame08.png", "test_img/frame09.png", "test_img/frame10.png", "test_img/frame11.png", "test_img/frame12.png", "test_img/frame13.png", "test_img/frame14.png" };

int imgnum = inputs_imgpath.Count();

for (int i = 0; i < imgnum - 1; i++)

{

Mat srcimg1 = Cv2.ImRead(inputs_imgpath[i]);

Mat srcimg2 = Cv2.ImRead(inputs_imgpath[i + 1]);

Mat mid_img = Interpolate(srcimg1, srcimg2);

string save_imgpath = "imgs_results/mid" + i + ".jpg";

Cv2.ImWrite(save_imgpath, mid_img);

}

dt2 = DateTime.Now;

textBox1.Text = "推理耗时:" + (dt2 - dt1).TotalMilliseconds + "ms";

button2.Enabled = true;

}

private void Form1_Load(object sender, EventArgs e)

{

model_path = "model/RIFE_HDv3.onnx";

// 创建输出会话,用于输出模型读取信息

options = new SessionOptions();

options.LogSeverityLevel = OrtLoggingLevel.ORT_LOGGING_LEVEL_INFO;

options.AppendExecutionProvider_CPU(0);// 设置为CPU上运行

// 创建推理模型类,读取本地模型文件

onnx_session = new InferenceSession(model_path, options);//model_path 为onnx模型文件的路径

// 创建输入容器

input_container = new List<NamedOnnxValue>();

pictureBox1.Image = new Bitmap("test_img/frame11.png");

pictureBox3.Image = new Bitmap("test_img/frame12.png");

}

private void pictureBox1_DoubleClick(object sender, EventArgs e)

{

Common.ShowNormalImg(pictureBox1.Image);

}

private void pictureBox2_DoubleClick(object sender, EventArgs e)

{

Common.ShowNormalImg(pictureBox2.Image);

}

SaveFileDialog sdf = new SaveFileDialog();

private void button3_Click(object sender, EventArgs e)

{

if (pictureBox2.Image == null)

{

return;

}

Bitmap output = new Bitmap(pictureBox2.Image);

sdf.Title = "保存";

sdf.Filter = "Images (*.jpg)|*.jpg|Images (*.png)|*.png|Images (*.bmp)|*.bmp|Images (*.emf)|*.emf|Images (*.exif)|*.exif|Images (*.gif)|*.gif|Images (*.ico)|*.ico|Images (*.tiff)|*.tiff|Images (*.wmf)|*.wmf";

if (sdf.ShowDialog() == DialogResult.OK)

{

switch (sdf.FilterIndex)

{

case 1:

{

output.Save(sdf.FileName, ImageFormat.Jpeg);

break;

}

case 2:

{

output.Save(sdf.FileName, ImageFormat.Png);

break;

}

case 3:

{

output.Save(sdf.FileName, ImageFormat.Bmp);

break;

}

case 4:

{

output.Save(sdf.FileName, ImageFormat.Emf);

break;

}

case 5:

{

output.Save(sdf.FileName, ImageFormat.Exif);

break;

}

case 6:

{

output.Save(sdf.FileName, ImageFormat.Gif);

break;

}

case 7:

{

output.Save(sdf.FileName, ImageFormat.Icon);

break;

}

case 8:

{

output.Save(sdf.FileName, ImageFormat.Tiff);

break;

}

case 9:

{

output.Save(sdf.FileName, ImageFormat.Wmf);

break;

}

}

MessageBox.Show("保存成功,位置:" + sdf.FileName);

}

}

private void button4_Click(object sender, EventArgs e)

{

button2.Enabled = false;

pictureBox2.Image = null;

textBox1.Text = "正在运行,请稍后……";

Application.DoEvents();

dt1 = DateTime.Now;

Mat srcimg1 = Cv2.ImRead("test_img/frame11.png");

Mat srcimg2 = Cv2.ImRead("test_img/frame12.png");

Mat mid_img = Interpolate(srcimg1, srcimg2);

dt2 = DateTime.Now;

pictureBox2.Image = new Bitmap(mid_img.ToMemoryStream());

textBox1.Text = "推理耗时:" + (dt2 - dt1).TotalMilliseconds + "ms";

button2.Enabled = true;

}

}

}

using Microsoft.ML.OnnxRuntime;

using Microsoft.ML.OnnxRuntime.Tensors;

using OpenCvSharp;

using OpenCvSharp.Dnn;

using System;

using System.Collections.Generic;

using System.Drawing;

using System.Drawing.Imaging;

using System.Linq;

using System.Numerics;

using System.Windows.Forms;namespace Onnx_Yolov8_Demo

{public partial class Form1 : Form{public Form1(){InitializeComponent();}string fileFilter = "*.*|*.bmp;*.jpg;*.jpeg;*.tiff;*.tiff;*.png";string image_path = "";string startupPath;DateTime dt1 = DateTime.Now;DateTime dt2 = DateTime.Now;string model_path;Mat image;Mat result_image;SessionOptions options;InferenceSession onnx_session;Tensor<float> input_tensor;Tensor<float> input_tensor2;List<NamedOnnxValue> input_container;IDisposableReadOnlyCollection<DisposableNamedOnnxValue> result_infer;DisposableNamedOnnxValue[] results_onnxvalue;Tensor<float> result_tensors;float[] result_array;float[] input1_image;float[] input2_image;int inpWidth;int inpHeight;private void button1_Click(object sender, EventArgs e){OpenFileDialog ofd = new OpenFileDialog();ofd.Filter = fileFilter;if (ofd.ShowDialog() != DialogResult.OK) return;pictureBox1.Image = null;image_path = ofd.FileName;pictureBox1.Image = new Bitmap(image_path);textBox1.Text = "";image = new Mat(image_path);pictureBox2.Image = null;}void Preprocess(Mat img, ref float[] input_img){Mat rgbimg = new Mat();Cv2.CvtColor(img, rgbimg, ColorConversionCodes.BGR2RGB);int h = rgbimg.Rows;int w = rgbimg.Cols;int align = 32;if (h % align != 0 || w % align != 0){int ph = ((h - 1) / align + 1) * align;int pw = ((w - 1) / align + 1) * align;Cv2.CopyMakeBorder(rgbimg, rgbimg, 0, ph - h, 0, pw - w, BorderTypes.Constant, 0);}inpHeight = rgbimg.Rows;inpWidth = rgbimg.Cols;rgbimg.ConvertTo(rgbimg, MatType.CV_32FC3, 1 / 255.0);int image_area = rgbimg.Rows * rgbimg.Cols;//input_img = new float[3 * image_area];input_img = Common.ExtractMat(rgbimg);}Mat Interpolate(Mat srcimg1, Mat srcimg2){int srch = srcimg1.Rows;int srcw = srcimg1.Cols;Preprocess(srcimg1, ref input1_image);Preprocess(srcimg2, ref input2_image);// 输入Tensorinput_tensor = new DenseTensor<float>(input1_image, new[] { 1, 3, inpHeight, inpWidth });input_tensor2 = new DenseTensor<float>(input2_image, new[] { 1, 3, inpHeight, inpWidth });//将tensor 放入一个输入参数的容器,并指定名称input_container.Add(NamedOnnxValue.CreateFromTensor("I0", input_tensor));input_container.Add(NamedOnnxValue.CreateFromTensor("I1", input_tensor2));//运行 Inference 并获取结果result_infer = onnx_session.Run(input_container);// 将输出结果转为DisposableNamedOnnxValue数组results_onnxvalue = result_infer.ToArray();// 读取第一个节点输出并转为Tensor数据result_tensors = results_onnxvalue[0].AsTensor<float>();int out_h = results_onnxvalue[0].AsTensor<float>().Dimensions[2];int out_w = results_onnxvalue[0].AsTensor<float>().Dimensions[3];result_array = result_tensors.ToArray();for (int i = 0; i < result_array.Length; i++){result_array[i] = result_array[i] * 255;if (result_array[i] < 0){result_array[i] = 0;}else if (result_array[i] > 255){result_array[i] = 255;}result_array[i] = result_array[i] + 0.5f;}float[] temp_r = new float[out_h * out_w];float[] temp_g = new float[out_h * out_w];float[] temp_b = new float[out_h * out_w];Array.Copy(result_array, temp_r, out_h * out_w);Array.Copy(result_array, out_h * out_w, temp_g, 0, out_h * out_w);Array.Copy(result_array, out_h * out_w * 2, temp_b, 0, out_h * out_w);Mat rmat = new Mat(out_h, out_w, MatType.CV_32F, temp_r);Mat gmat = new Mat(out_h, out_w, MatType.CV_32F, temp_g);Mat bmat = new Mat(out_h, out_w, MatType.CV_32F, temp_b);result_image = new Mat();Cv2.Merge(new Mat[] { bmat, gmat, rmat }, result_image);result_image.ConvertTo(result_image, MatType.CV_8UC3);Mat mid_img = new Mat(result_image, new Rect(0, 0, srcw, srch));return mid_img;}private void button2_Click(object sender, EventArgs e){button2.Enabled = false;pictureBox2.Image = null;textBox1.Text = "正在运行,请稍后……";Application.DoEvents();dt1 = DateTime.Now;List<String> inputs_imgpath = new List<String>() { "test_img/frame07.png", "test_img/frame08.png", "test_img/frame09.png", "test_img/frame10.png", "test_img/frame11.png", "test_img/frame12.png", "test_img/frame13.png", "test_img/frame14.png" };int imgnum = inputs_imgpath.Count();for (int i = 0; i < imgnum - 1; i++){Mat srcimg1 = Cv2.ImRead(inputs_imgpath[i]);Mat srcimg2 = Cv2.ImRead(inputs_imgpath[i + 1]);Mat mid_img = Interpolate(srcimg1, srcimg2);string save_imgpath = "imgs_results/mid" + i + ".jpg";Cv2.ImWrite(save_imgpath, mid_img);}dt2 = DateTime.Now;textBox1.Text = "推理耗时:" + (dt2 - dt1).TotalMilliseconds + "ms";button2.Enabled = true;}private void Form1_Load(object sender, EventArgs e){model_path = "model/RIFE_HDv3.onnx";// 创建输出会话,用于输出模型读取信息options = new SessionOptions();options.LogSeverityLevel = OrtLoggingLevel.ORT_LOGGING_LEVEL_INFO;options.AppendExecutionProvider_CPU(0);// 设置为CPU上运行// 创建推理模型类,读取本地模型文件onnx_session = new InferenceSession(model_path, options);//model_path 为onnx模型文件的路径// 创建输入容器input_container = new List<NamedOnnxValue>();pictureBox1.Image = new Bitmap("test_img/frame11.png");pictureBox3.Image = new Bitmap("test_img/frame12.png");}private void pictureBox1_DoubleClick(object sender, EventArgs e){Common.ShowNormalImg(pictureBox1.Image);}private void pictureBox2_DoubleClick(object sender, EventArgs e){Common.ShowNormalImg(pictureBox2.Image);}SaveFileDialog sdf = new SaveFileDialog();private void button3_Click(object sender, EventArgs e){if (pictureBox2.Image == null){return;}Bitmap output = new Bitmap(pictureBox2.Image);sdf.Title = "保存";sdf.Filter = "Images (*.jpg)|*.jpg|Images (*.png)|*.png|Images (*.bmp)|*.bmp|Images (*.emf)|*.emf|Images (*.exif)|*.exif|Images (*.gif)|*.gif|Images (*.ico)|*.ico|Images (*.tiff)|*.tiff|Images (*.wmf)|*.wmf";if (sdf.ShowDialog() == DialogResult.OK){switch (sdf.FilterIndex){case 1:{output.Save(sdf.FileName, ImageFormat.Jpeg);break;}case 2:{output.Save(sdf.FileName, ImageFormat.Png);break;}case 3:{output.Save(sdf.FileName, ImageFormat.Bmp);break;}case 4:{output.Save(sdf.FileName, ImageFormat.Emf);break;}case 5:{output.Save(sdf.FileName, ImageFormat.Exif);break;}case 6:{output.Save(sdf.FileName, ImageFormat.Gif);break;}case 7:{output.Save(sdf.FileName, ImageFormat.Icon);break;}case 8:{output.Save(sdf.FileName, ImageFormat.Tiff);break;}case 9:{output.Save(sdf.FileName, ImageFormat.Wmf);break;}}MessageBox.Show("保存成功,位置:" + sdf.FileName);}}private void button4_Click(object sender, EventArgs e){button2.Enabled = false;pictureBox2.Image = null;textBox1.Text = "正在运行,请稍后……";Application.DoEvents();dt1 = DateTime.Now;Mat srcimg1 = Cv2.ImRead("test_img/frame11.png");Mat srcimg2 = Cv2.ImRead("test_img/frame12.png");Mat mid_img = Interpolate(srcimg1, srcimg2);dt2 = DateTime.Now;pictureBox2.Image = new Bitmap(mid_img.ToMemoryStream());textBox1.Text = "推理耗时:" + (dt2 - dt1).TotalMilliseconds + "ms";button2.Enabled = true;}}

}

下载

源码下载

这篇关于C# Onnx 使用onnxruntime部署实时视频帧插值的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!