本文主要是介绍自动化抓取电商数据|获取商品信息订单信息API(淘宝/京东/拼多多/1688),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

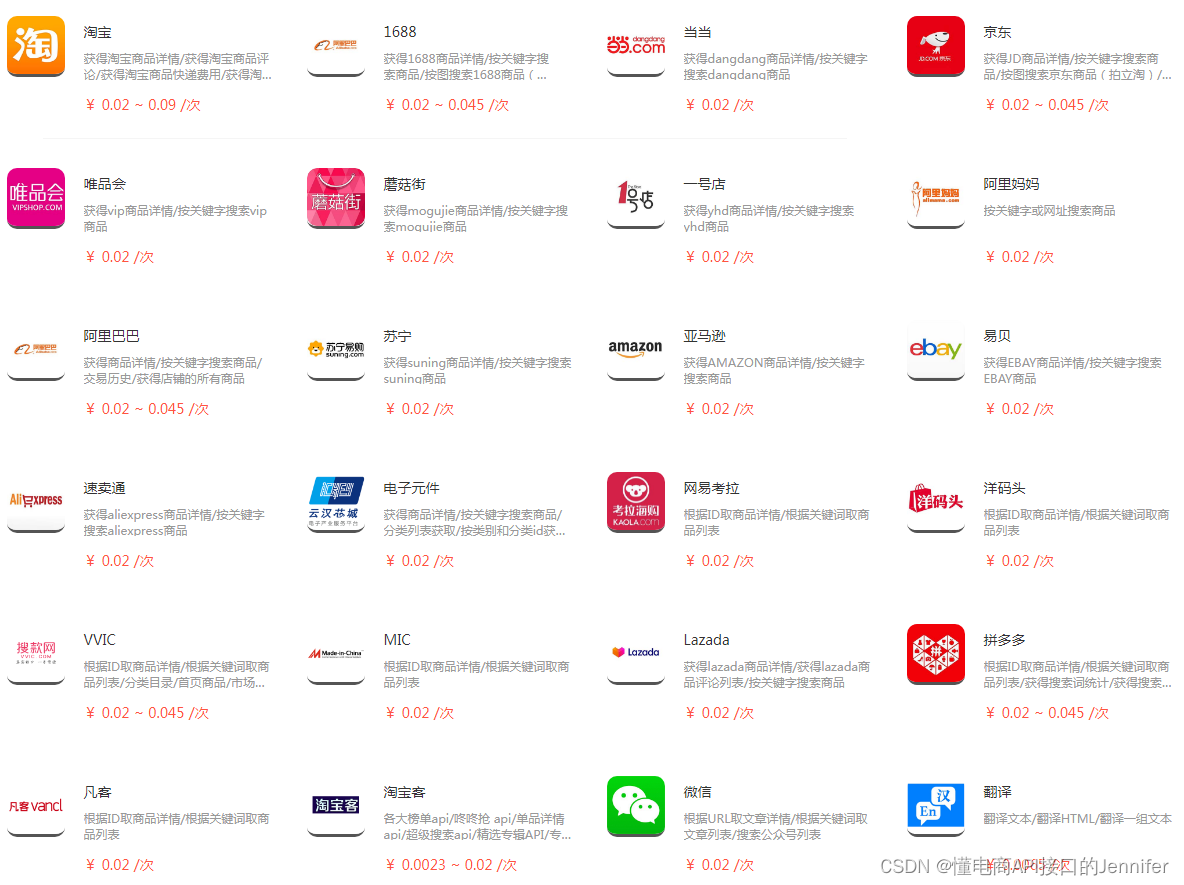

电商数据采集的网页抓取数据、淘宝、天猫、京东等平台的电商数据抓取,网页爬虫、采集网站数据、网页数据采集软件、python爬虫、HTM网页提取、APP数据抓包、APP数据采集、一站式网站采集技术、BI数据的数据分析、数据标注等成为大数据发展中的热门技术关键词。

API注册开通测试详情步骤

API注册开通测试详情步骤

1、注册账号获取key&secret(点此注册)

2、查看API文档,了解请求参数和响应参数

3、进入测试页测试API

4、查看响应参数是否符合需求

方法一:用python的request方法

用python的request方法,直接原生态代码,python感觉是为了爬虫和大数据而生的,我平时做的网络分布式爬虫、图像识别、AI模型都是用python,因为python有很多现存的库直接可以调用,比如您需要做个简单爬虫,比如我想采集百度 几行代码就可以搞定了,核心代码如下:

import requests #引用reques库

response=request.get(‘https://www.tianyancha.com/’)#用get模拟请求

print(response.text) #已经采集出来了,也许您会觉好神奇!

方法二、用selenium模拟浏览器

selenium是一个专门采集反爬很厉害的网站经常使用的工具,它主要是可以模拟浏览器去打开访问您需要采集的目标网站了,比如您需要采集天眼查或者企查查或者是淘宝、58、京东等各种商业的网站,那么这种网站服务端做了反爬技术了,如果您还是用python的request.get方法就容易被识别,被封IP。这个时候如果您对数据采集速度要求不太高,比如您一天只是采集几万条数据而已,那么这个工具是非常适合的。我当时在处理商标网时候也是用selenum,后面改用JS逆向了,如果您需要采集几百万几千万怎么办呢?下面的方法就可以用上了。

方法三、用scrapy进行分布式高速采集

Scrapy是适用于Python的一个快速、高层次的屏幕抓取和web抓取框架,用于抓取web站点并从页面中提取结构化的数据。scrapy 特点是异步高效分布式爬虫架构,可以开多进程 多线程池进行批量分布式采集。比如您想采集1000万的数据,您就可以多设置几个结点和线程。Scrapy也有缺点的,它基于 twisted 框架,运行中的 exception 是不会干掉 reactor(反应器),并且异步框架出错后 是不会停掉其他任务的,数据出错后难以察觉。我2019年在做企业知识图谱建立的时候就是用这个框架,因为要完成1.8亿的全量工商企业数据采集和建立关系,维度比天眼还要多,主要是时候更新要求比天眼快。对技术感兴趣朋友欢迎交流我扣扣:2779571288

方法四:用Crawley

Crawley也是python开发出的爬虫框架,该框架致力于改变人们从互联网中提取数据的方式。它是基于Eventlet构建的高速网络爬虫框架、可以将爬取的数据导入为Json、XML格式。支持非关系数据库、支持使用Cookie登录或访问那些只有登录才可以访问的网页。

方法五:用PySpider

相对于Scrapy框架而言,PySpider框架是一支新秀。它采用Python语言编写,分布式架构,支持多种数据库后端,强大的WebUI支持脚本编辑器、任务监视器、项目管理器以及结果查看器。PPySpider的特点是ython脚本控制,可以用任何你喜欢的html解析包,Web界面编写调试脚本、起停脚本、监控执行状态、查看活动历史,并且支持RabbitMQ、Beanstalk、Redis和Kombu作为消息队列。用它做个两个外贸网站采集的项目,感觉还不错。

方法六:用Aiohttp

Aiohttp 是纯粹的异步框架,同时支持 HTTP 客户端和 HTTP 服务端,可以快速实现异步爬虫。坑比其他框架少。并且 aiohttp 解决了requests 的一个痛点,aiohttp 可以轻松实现自动转码,对于中文编码就很方便了。这个做异步爬虫很不错,我当时对几个淘宝网站异步检测商城里面的商品和价格变化后处理时用过一段时间。

方法七:asks

Python 自带一个异步的标准库 asyncio,但是这个库很多人觉得不好用,甚至是 Flask 库的作者公开抱怨自己花了好长时间才理解这玩意,于是就有好事者撇开它造了两个库叫做 curio 和 trio,而这里的 ask 则是封装了 curio 和 trio 的一个 http 请求库。

方法八:vibora

号称是现在最快的异步请求框架,跑分是最快的。写爬虫、写服务器响应都可以用,用过1个月后 就很少用了。

方法九:Pyppeteer

Pyppeteer 是异步无头浏览器(Headless Chrome),从跑分来看比 Selenium + webdriver 快,使用方式是最接近于浏览器的自身的设计接口的。它本身是来自 Google 维护的 puppeteer。我经常使用它来提高selenium采集的一些反爬比较厉害的网站 比如裁判文书网,这种网站反爬识别很厉害。

方法十:Fiddle++node JS逆向+request (采集APP必用)

Fiddler是一个蛮好用的抓包工具,可以将网络传输发送与接受的数据包进行截获、重发、编辑、转存等操作。我们在采集某个app时候,一般是先用Fiddler抓包 找到这个app请求这个数据时候调取的是后台的那个接口地址,找到这个地址和请求的参数然后再模拟request。今年在处理快手、抖音的粉丝、评价、商品店铺销量时候就用到了Fiddle。某些APP 和网站的参数是通过js加密的,比如商标网、裁判文书网、抖音快手等这些。您如果需要请求它的源api地址就地逆向解析破解这些加密参数,可以使用node解析混淆函数。因为平时需要经常采集一些app,所以和Fiddler打交道的比较多。

这篇关于自动化抓取电商数据|获取商品信息订单信息API(淘宝/京东/拼多多/1688)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!