本文主要是介绍ETL数据集成工具DataX、Kettle、ETLCloud特点对比,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

ETL数据集成工具

对于数据仓库,大数据集成类应用,通常会采用ETL工具辅助完成。ETL,是英文 Extract-Transform-Load 的缩写,用来描述将数据从来源端经过抽取(extract) 、交互转换(transform) 、加载(load)至的端的过程当前的很多应用也存在大量的ELT应用模式。常见的ETL工具或类ETL的数据集成同步工具很多,以下对开源的datax、Kettle、ETLCloud进行简单梳理比较。

1.DataX

1.1介绍

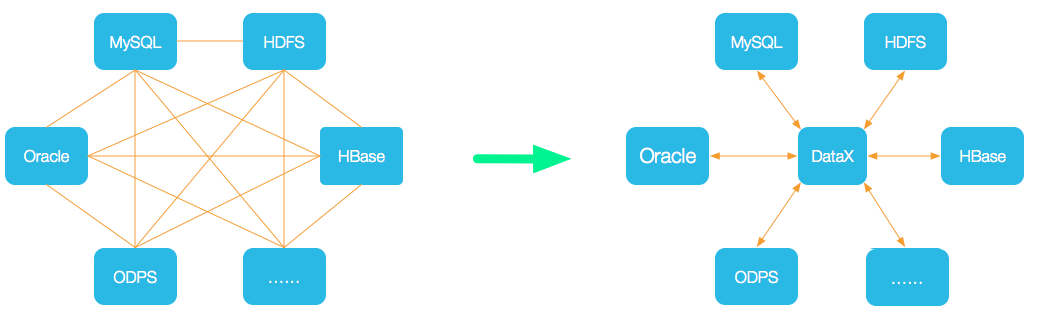

DataX是阿里巴巴集团开源的一款异构数据源离线同步工具,旨在实现各种数据源之间稳定高效的数据同步功能。它支持包括关系型数据库(MySQL、Oracle等)、HDFS、Hive、ODPS、HBase、FTP等多种异构数据源。为了解决异构数据源同步问题,DataX采用星型数据链路架构,将复杂的网状同步链路简化为中心式数据同步,DataX作为中间传输载体负责连接各种数据源,实现新数据源与已有数据源之间的无缝数据同步。

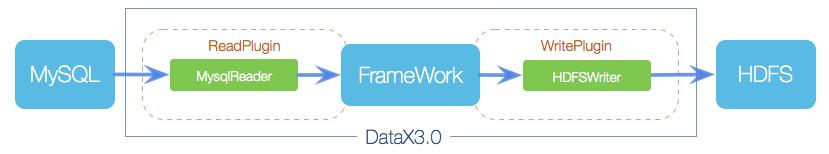

DataX本身作为离线数据同步框架,采用Framework + plugin架构构建。将数据源读取和写入抽象为Reader和Writer插件,纳入到整个同步框架中。

1.2特点

-

异构数据库和文件系统之间的数据交换

-

采用Framework+plugin架构构建,Framework处理了缓冲,流控,并发,上下文加载等高速数据交换的大部分技术问题,提供了简单的接口与插件交互,插件仅需实现对数据处理系统的访问。

-

数据传输过程在单进程内完成,全内存操作。

-

拓展性强,开发者可以开发一个新插件支持新的数据库文件系统。

2.Kettle

2.1介绍

kettle是一款全球最受欢迎的开源ETL数据集成工具,具有多样的数据集成功能,支持各种数据源和目标。提供直观的可视化配置界面,强大的数据转换和处理能力,包括清洗、转换、过滤等操作。可扩展的架构,允许用户开发自定义插件和扩展。跨平台支持和灵活的部署选项。拥有庞大的用户社区和活跃的开发者社区,提供全面的支持和资源。

Transformatiobn:完成对数据的基本转换。

Job: 完成整个工作流的控制。

简单理解, 一个转换(Trans)就是一个ETL的过程,而作业(Job)是多个转换的集合, 在作业中可以对转换或作业进行调度,定时任务。

2.2 特点

-

免费开源,可跨平台(因为是纯java编写)

-

Kettle提供了直观的图形化界面,用户可以通过拖拽组件来构建数据流程,无需编写代码。

-

两种脚本文件,trans负责数据转化,job负责整个工作流的调度控制。

-

支持作业调度和监控,可以自动化执行数据集成任务。

3.ETLCloud

3.1介绍

ETLCloud是一款由国内RestCloud推出的全域数据集成工具,他对标的主要是替换上面这些全球化的ETL数据集成工具,也是国内目前最受欢迎的免费ETL数据集成工具,具有广泛的数据集成组件,内置支持上百种应用的集成,这是其他ETL均不具备的能力,支持各种数据源和目标。提供WEB直观的可视化配置界面,强大的数据转换和处理能力,包括清洗、转换、过滤等操作。可扩展的三层架构,同时允许用户开发自定义插件和扩展。

3.2特点

-

基于微服务架构开发支持分布式部署同时支持上万流程的调度与执行

-

平台简单易用开箱即用,无需安装客户端软件只需浏览器即可

-

支持多种数据源(RDBS、NOSQL、API、Excel、kafka、hive等)、支持CDC、MQ流式数据的实时处理,支持批流数据的合并

-

支持各种不同数据源之间数据类型的自动转换,极大提升流程的构建速度

-

支持数据缓冲库功能,提供中间缓冲数据功能

与Kettle、DataX相比,ETLCloud在可视化监控、集群部署、告警和实时能力等方面具备优势。此外,ETLCloud还拥有一个活跃的社区群体,提供技术支持和全面的帮助文档和视频资源。能够满足各种企业的数据集成需求。

这篇关于ETL数据集成工具DataX、Kettle、ETLCloud特点对比的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!