本文主要是介绍交叉熵损失的“替代品”:基于最优传输思想设计的分类损失函数EMO,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

©PaperWeekly 原创 · 作者 | 苏剑林

单位 | 月之暗面

研究方向 | NLP、神经网络

众所周知,分类任务的标准损失是交叉熵(Cross Entropy,等价于最大似然 MLE,即 Maximum Likelihood Estimation),它有着简单高效的特点,但在某些场景下也暴露出一些问题,如偏离评价指标、过度自信等,相应的改进工作也有很多,此前我们也介绍过一些,比如《再谈类别不平衡问题:调节权重与魔改Loss的对比联系》、《如何训练你的准确率?》、《缓解交叉熵过度自信的一个简明方案》[1] 等。

由于 LLM 的训练也可以理解为逐 token 的分类任务,默认损失也是交叉熵,因此这些改进工作在 LLM 流行的今天依然有一定的价值。

在这篇文章中,我们介绍一篇名为 EMO 的工作,它基于最优传输思想提出了新的改进损失函数,声称能大幅提高 LLM 的微调效果。其中细节如何?让我们一探究竟。

论文标题:

EMO: Earth Mover Distance Optimization for Auto-Regressive Language Modeling

论文地址:

https://arxiv.org/abs/2310.04691

概率散度

假设 是模型预测的第 个类别的概率,, 则是目标类别,那么交叉熵损失为

如果将标签 用one hot形式的分布 表示出来(即 ),那么它可以重写成

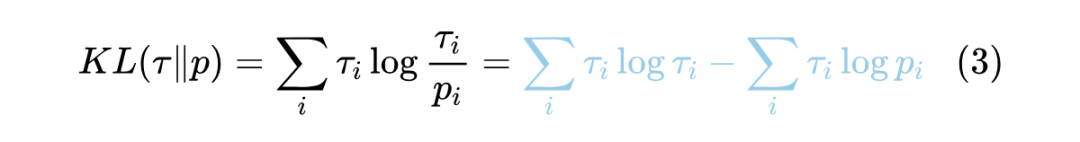

这个形式同时适用于非 one hot 的标签 (即软标签),它等价于优化 的 KL 散度:

当 给定时,最右端第一项就是一个常数,所以它跟交叉熵目标是等价的。

这个结果表明,我们在做 MLE,或者说以交叉熵为损失时,实则就是在最小化目标分布和预测分布的 KL 散度。由于 KL 散度的一般推广是 f 散度(参考《f-GAN简介:GAN模型的生产车间》),所以很自然想到换用其他 f 散度或许有改良作用。事实上,确实有不少工作是按照这个思路进行的,比如《缓解交叉熵过度自信的一个简明方案》[1] 介绍的方法,其论文的出发点是 “Total Variation 距离”,也是 f 散度的一种。

最优传输

不过,每种 f 散度或多或少有些问题,要说概率分布之间的理想度量,当属基于最优传输思想的“推土机距离(Earth Mover's Distance,EMD)”,不了解的读者可以参考一下笔者之前写的《从Wasserstein距离、对偶理论到WGAN》。

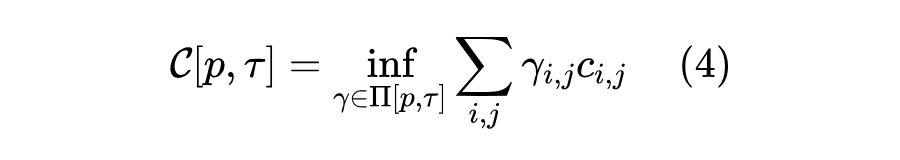

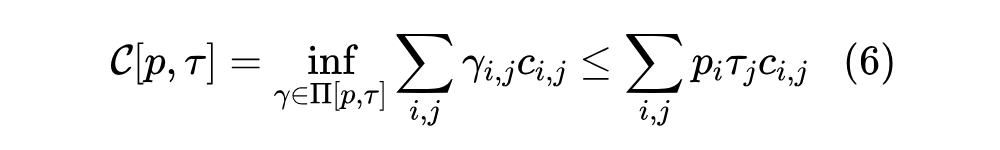

简单来说,推土机距离定义为两个分布之间的最优传输成本:

这里的 说的是 是任意以 为边缘分布的联合分布, 是实现给定的成本函数,代表“从 搬运到 的成本”, 是下确界,意思就是说将最低的运输成本作为 之间的差异度量。正如基于 f 散度的 Vanilla GAN 换成基于最优传输的 Wasserstein GAN 能够更好的收敛性质,我们期望如果将分类的损失函数换成两个分布的 W 距离,也能收敛到更好的结果。

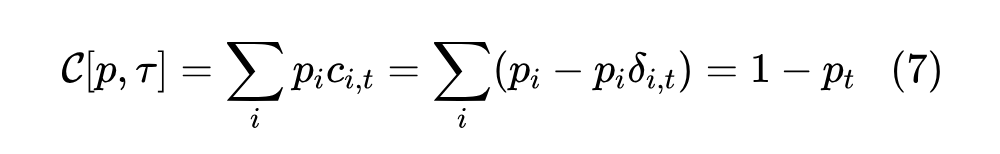

当 是 one hot 分布时,目标分布就是一个点 ,那么就无所谓最不最优了,传输方案就只有一个,即把 的所有东西都搬到同一个点 ,所以此时就有

如果 是一般的软标签分布,那么 的计算是一个线性规划问题,求解起来比较复杂,由于 所定义的分布也属于 ,那么我们有

这是一个容易计算的上界,也可以作为优化目标,式(5)则对应 ,其中 是“克罗内克 函数” [2]。

成本函数

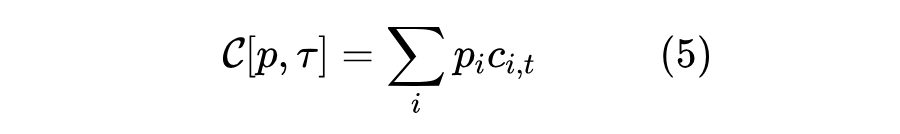

现在回到原论文所关心的场景——LLM 的微调,包括二次预训练和微调到下游任务等。正如本文开头所述,LLM 的训练可以理解为逐 token 的分类任务(类别即所有 token),每个标签是 one hot 的,所以适用于式(5)。

式(5)还差成本函数 还没定下来。如果简单地认为只要 ,那么成本都是 1,即 ,那么

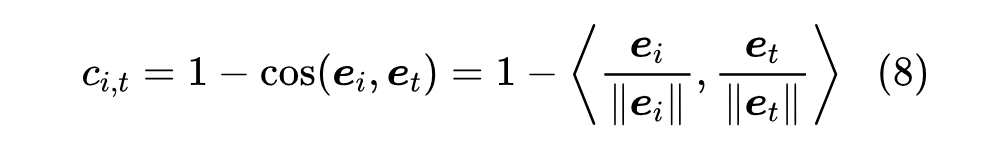

这其实就是在最大化准确率的光滑近似(参考《函数光滑化杂谈:不可导函数的可导逼近》[4])。但直觉上,所有 都给予同样程度的惩罚似乎过于简单了,理想情况下应该根据相似度来给每个不同的 设计不同的成本,即相似度越大,传输成本越低,那么我们可以将传输成本设计为

这里的 是事先获取到 Token Embedding,原论文是将预训练模型的 LM Head 作为 Token Embedding 的,并且根据最优传输的定义成本函数是要实现给定的,因此计算相似度的 Token Embedding 要在训练过程中固定不变。

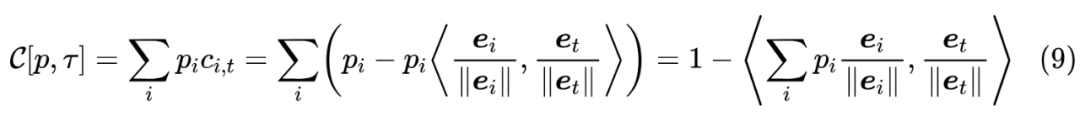

有了成本函数后,我们就可以计算

这就是 EMO(Earth Mover Distance Optimization)最终的训练损失。由于 embedding_size 通常远小于 vocab_size,所以先算 能明显降低计算量。

实验效果

由于笔者对 LLM 的研究还处于预训练阶段,还未涉及到微调,所以暂时没有自己的实验结果,只能先跟大家一起看看原论文的实验。不得不说,原论文的实验结果还是比较惊艳的。

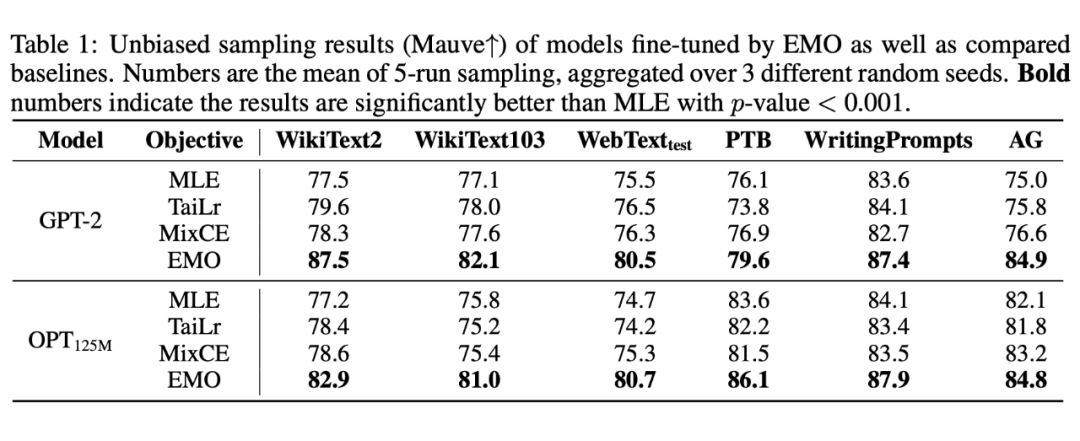

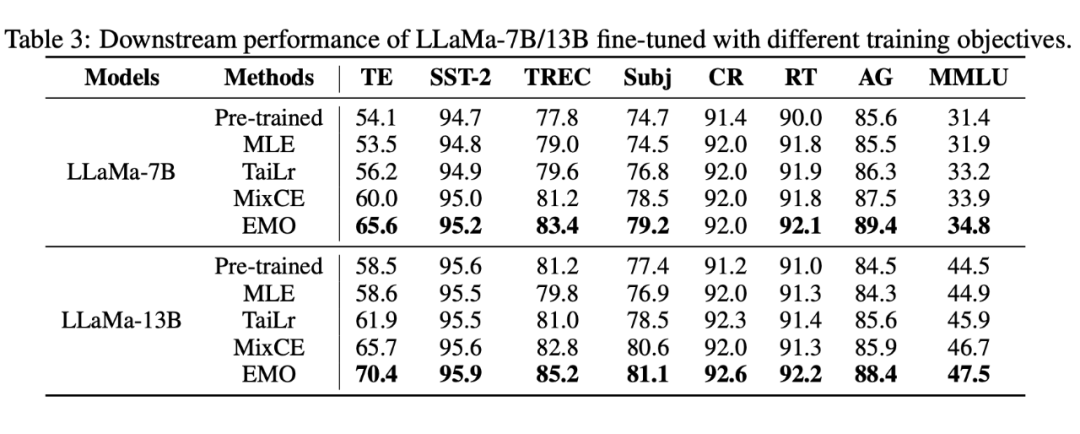

首先,是小模型上的继续预训练实验,相比交叉熵(MLE)的提升最多的有 10 个点,并且是全面 SOTA:

▲ 小模型上的继续预训练对比实验

▲ 小模型上的继续预训练对比实验

值得一提的是,这里的评价指标是 MAUVE,越大越好,它提出自《MAUVE: Measuring the Gap Between Neural Text and Human Text using Divergence Frontiers》[3],是跟人工评价最相关的自动评测指标之一。此外,对比方法的 TaiLr 我们曾在《缓解交叉熵过度自信的一个简明方案》[1] 简单介绍过。

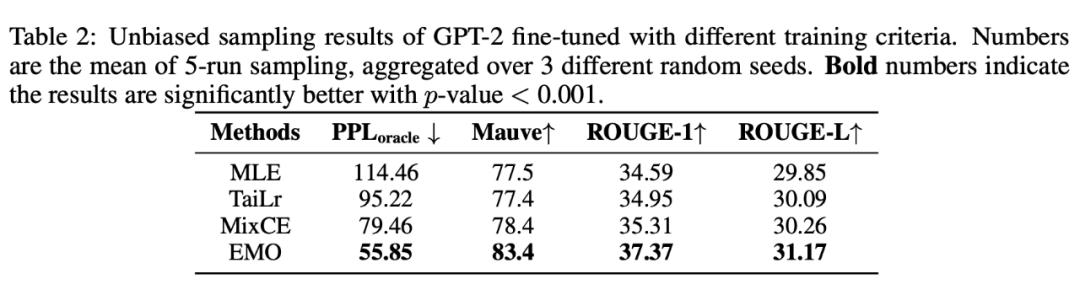

可能有读者想 EMO 更好是不是单纯因为评价指标选得好?并不是,让人意外的是,EMO 训练的模型,甚至 PPL 都更好(PPL 跟 MLE 更相关):

▲ 不同评价指标的对比

然后是将 LLAMA-7B/13B 微调到下游任务做 Few Shot 的效果,同样很出色:

▲ LLAMA-7B:13B微调到下游任务的效果

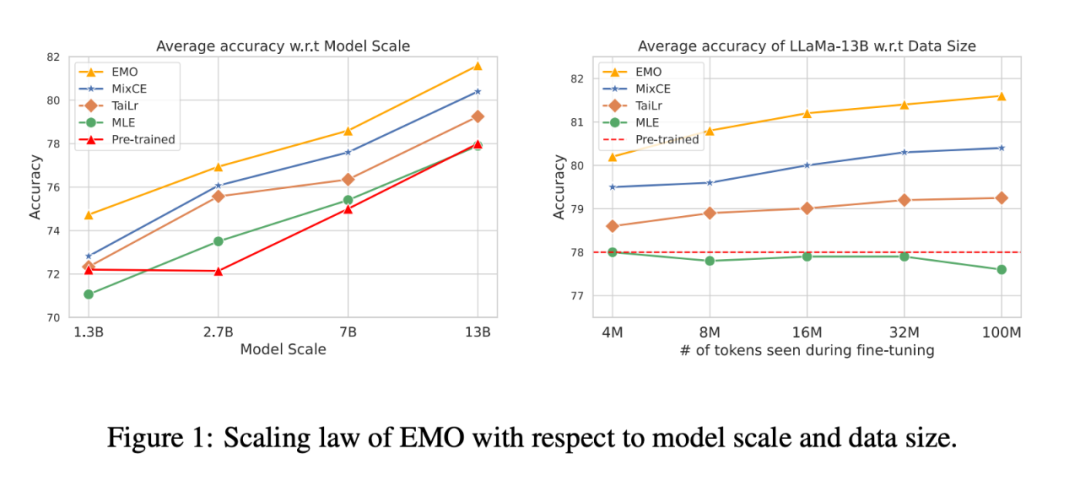

最后对比了不同模型规模和数据规模的效果,显示出 EMO 在不同模型和数据规模上都有不错的表现:

▲ 不同模型规模/数据规模上的效果

个人思考

总的来说,原论文的“成绩单”还是非常漂亮的,值得一试。唯一的疑虑可能是原论文的实验数据量其实都不算大,不清楚进一步增大数据量后是否会缩小 EMO 和 MLE 的差距。

就笔者看来,EMO 之所以能取得更好的结果,是因为它通过 Embedding 算相似度,来为“近义词”分配了更合理的损失,从而使得模型的学习更加合理。因为虽然形式上 LLM 也是分类任务,但它并不是一个简单的对与错问题,并不是说下一个预测的 token 跟标签 token 不一致,句子就不合理了,因此引入语义上的相似度来设计损失对 LLM 的训练是有帮助的。可以进一步猜测的是,vocab_size 越大、token 颗粒度越大的情况下,EMO 的效果应该越好,因为 vocab_size 大了“近义词”就可能越多。

当然,引入语义相似度也导致了 EMO 不适用于从零训练,因为它需要一个训练好的 LM Head 作为 Token Embedding。当然,一个可能的解决方案是考虑用其他方式,比如经典的 Word2Vec 来事先训练好 Token Embedding,但这可能会有一个风险,即经典方式训练的 Token Embedding 是否会降低 LLM 能力的天花板(毕竟存在不一致性)。

此外,即便 Token Embedding 没问题,从零预训练时单纯用 EMO 可能还存在收敛过慢的问题,这是因为根据笔者在《如何训练你的准确率?》的末尾提出的损失函数视角:

首先寻找评测指标的一个光滑近似,最好能表达成每个样本的期望形式,然后将错误方向的误差逐渐拉到无穷大(保证模型能更关注错误样本),但同时在正确方向保证与原始形式是一阶近似。也就是说,为了保证(从零训练的)收敛速度,错误方向的损失最好能拉到无穷大,而 EMO 显然不满足这一点,因此将 EMO 用于从零训练的时候,大概率是 EMO 与 MLE 的某个加权组合,才能平衡收敛速度和最终效果。

文章小结

本文介绍了交叉熵损失的一个新的“替代品”——基于最优传输思想的 EMO,与以往的小提升不同,EMO 在 LLM 的微调实验中取得了较为明显的提升。

参考文献

[1] https://kexue.fm/archives/9526

[2] https://en.wikipedia.org/wiki/Kronecker_delta

[3] https://kexue.fm/archives/6620#正确率

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

这篇关于交叉熵损失的“替代品”:基于最优传输思想设计的分类损失函数EMO的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!