本文主要是介绍千亿级开源大模型Qwen110B部署实测,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

近日,通义千问团队震撼开源 Qwen1.5 系列首个千亿参数模型 Qwen1.5-110B-Chat。

千亿级大模型普通显卡是跑不了推理的,普通人一般也没办法本地运行千亿级大模型。

为了探索千亿级大模型到底需要计算资源,我用云计算资源部署了Qwen1.5-110B-Chat,看看部署它到底需要多少存储资源,并且测试在不量化、8bit量化、4bit量化下的显存消耗。

一、下载模型

#模型下载

from modelscope import snapshot_download

model_dir = snapshot_download('qwen/Qwen1.5-110B-Chat', cache_dir='path/to/local/dir')

下载后模型目录结构如下:

.

├── config.json

├── configuration.json

├── generation_config.json

├── LICENSE

├── merges.txt

├── model-00001-of-00062.safetensors

├── model-00002-of-00062.safetensors

├── model-00003-of-00062.safetensors

├── model-00004-of-00062.safetensors

├── model-00005-of-00062.safetensors

...

├── model-00062-of-00062.safetensors

├── model.safetensors.index.json

├── out.txt

├── README.md

├── tokenizer_config.json

├── tokenizer.json

└── vocab.json

0 directories, 73 files

模型Qwen1.5-110B-Chat共占用硬盘空间208G。

二、显卡消耗

按照计算公式:模型显存占用(GB) = 大模型参数(B)*2

那么Qwen1.5-110B-Chat的显存占用量应该为220GB。

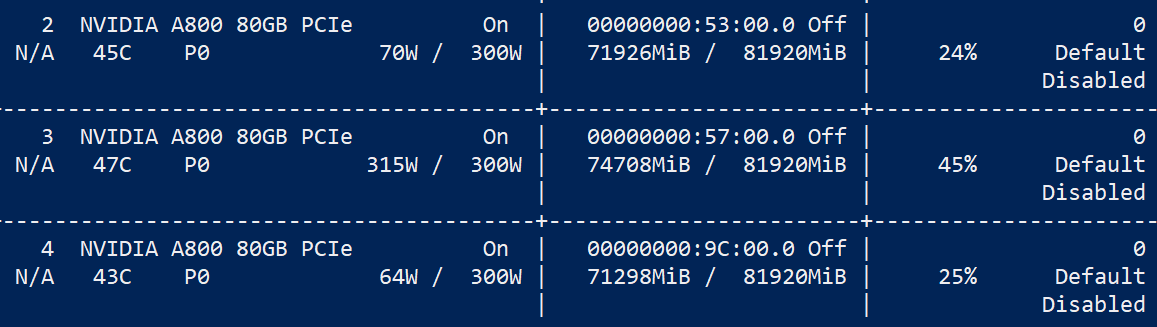

实际在部署过程中,没有考虑任何量化技术,占用显存215GB。

因此,如果你想完整部署Qwen1.5-110B-Chat,不考虑任何量化技术,需要3块80GB显存的显卡。

当然你可以玩量化,在 Transformers 中使用 LLM.int8() 只需提前安装pip install bitsandbytes即可,使用 LLM.int8() 方法量化transformer模型具体示例如下:

8bit量化

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained('qwen/Qwen1___5-110B-Chat',device_map='auto',load_in_8bit=True,max_memory={i: f'{int(torch.cuda.mem_get_info(i)[0]/1024**3)-2}GB'for i in range(torch.cuda.device_count())}

)

经测试,如果你采用8bit量化部署Qwen1.5-110B,需要113GB显存。

4bit量化

from transformers import BitsAndBytesConfig

import torch

nf4_config = BitsAndBytesConfig(load_in_4bit=True,bnb_4bit_quant_type="nf4",bnb_4bit_use_double_quant=True,bnb_4bit_compute_dtype=torch.bfloat16

)model_nf4 = AutoModelForCausalLM.from_pretrained('qwen/Qwen1___5-110B-Chat', quantization_config=nf4_config)

经测试,如果你采用4bit量化部署Qwen1.5-110B,需要62GB显存,预计1块80GB显存显卡即可部署。

三、推理代码

简单问一个弱智吧的问题。

from modelscope import AutoModelForCausalLM, AutoTokenizer

device = "cuda" # the device to load the model ontomodel = AutoModelForCausalLM.from_pretrained("/home/data/qwen/Qwen1___5-110B-Chat",torch_dtype="auto",device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained("/jydata/qwen/Qwen1___5-110B-Chat")prompt = "树上有3只鸟,我用步枪打死一只,还有几只鸟?"

messages = [{"role": "system", "content": "You are a helpful assistant."},{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(messages,tokenize=False,add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt").to(device)generated_ids = model.generate(model_inputs.input_ids,max_new_tokens=512

)

generated_ids = [output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(response)四、推理截图

这篇关于千亿级开源大模型Qwen110B部署实测的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!