本文主要是介绍AUTOML_NNI案例之 1.pytorch——minist 超参优化,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

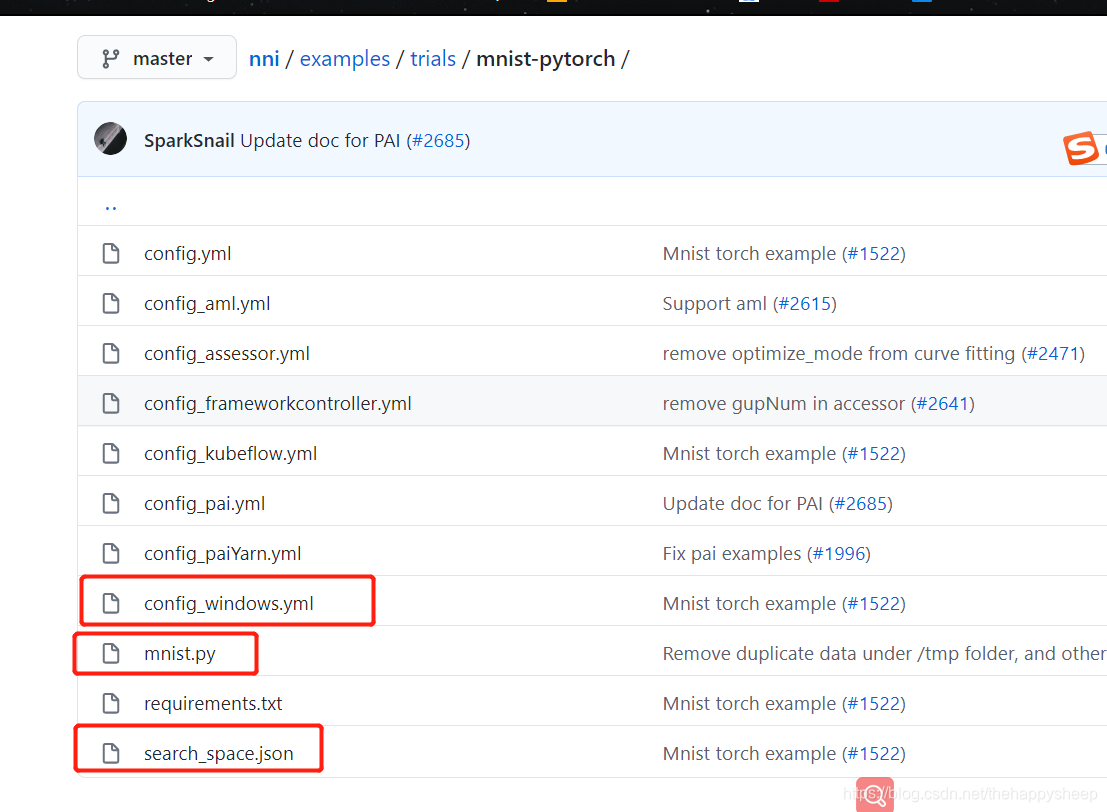

1.代码文件

https://github.com/microsoft/nni/tree/master/examples/trials/mnist-pytorch

主要包括,配置文件config_windows.yml和minist.py文件,搜索空间文件search_space.json文件。

2.config_windows.ymal配置文件

配置文件中包设置了trial次数和时间,要起训练的脚本,以及搜索空间

authorName: default

experimentName: example_mnist_pytorch#本次实验名称

trialConcurrency: 1

maxExecDuration: 1h

maxTrialNum: 10

#choice: local, remote, pai

trainingServicePlatform: local

searchSpacePath: search_space.json

#choice: true, false

useAnnotation: false

tuner:#choice: TPE, Random, Anneal, Evolution, BatchTuner, MetisTuner, GPTuner#SMAC (SMAC should be installed through nnictl)builtinTunerName: TPEclassArgs:#choice: maximize, minimizeoptimize_mode: maximize

trial:command: python mnist.pycodeDir: .gpuNum: 0

3.搜索空间 search_space.json

其中包括可搜索超参空间。

有常见的“batch_size”,隐层数量"hideen_size",学习率"lr",loss优化的动量"momentum"

{"batch_size": {"_type":"choice", "_value": [16, 32, 64, 128]},"hidden_size":{"_type":"choice","_value":[128, 256, 512, 1024]},"lr":{"_type":"choice","_value":[0.0001, 0.001, 0.01, 0.1]},"momentum":{"_type":"uniform","_value":[0, 1]}

}4.工程代码mnist.py

前面搭建网络,加载数据操作都很常规,代码写的也很nice,简单易懂。

关键在后面几句

# get parameters form tuner

tuner_params = nni.get_next_parameter()

logger.debug(tuner_params)

params = vars(merge_parameter(get_params(), tuner_params))#

print(params)

main(params)

"""

A deep MNIST classifier using convolutional layers.This file is a modification of the official pytorch mnist example:

https://github.com/pytorch/examples/blob/master/mnist/main.py

"""import os

import argparse

import logging

import nni

import torch

import torch.nn as nn

import torch.nn.functional as F

import torch.optim as optim

from nni.utils import merge_parameter

from torchvision import datasets, transformslogger = logging.getLogger('mnist_AutoML')class Net(nn.Module):def __init__(self, hidden_size):super(Net, self).__init__()self.conv1 = nn.Conv2d(1, 20, 5, 1)self.conv2 = nn.Conv2d(20, 50, 5, 1)self.fc1 = nn.Linear(4*4*50, hidden_size)self.fc2 = nn.Linear(hidden_size, 10)def forward(self, x):x = F.relu(self.conv1(x))x = F.max_pool2d(x, 2, 2)x = F.relu(self.conv2(x))x = F.max_pool2d(x, 2, 2)x = x.view(-1, 4*4*50)x = F.relu(self.fc1(x))x = self.fc2(x)return F.log_softmax(x, dim=1)def train(args, model, device, train_loader, optimizer, epoch):model.train()for batch_idx, (data, target) in enumerate(train_loader):if (args['batch_num'] is not None) and batch_idx >= args['batch_num']:breakdata, target = data.to(device), target.to(device)optimizer.zero_grad()output = model(data)loss = F.nll_loss(output, target)loss.backward()optimizer.step()if batch_idx % args['log_interval'] == 0:logger.info('Train Epoch: {} [{}/{} ({:.0f}%)]\tLoss: {:.6f}'.format(epoch, batch_idx * len(data), len(train_loader.dataset),100. * batch_idx / len(train_loader), loss.item()))def test(args, model, device, test_loader):model.eval()test_loss = 0correct = 0with torch.no_grad():for data, target in test_loader:data, target = data.to(device), target.to(device)output = model(data)# sum up batch losstest_loss += F.nll_loss(output, target, reduction='sum').item()# get the index of the max log-probabilitypred = output.argmax(dim=1, keepdim=True)correct += pred.eq(target.view_as(pred)).sum().item()test_loss /= len(test_loader.dataset)accuracy = 100. * correct / len(test_loader.dataset)logger.info('\nTest set: Average loss: {:.4f}, Accuracy: {}/{} ({:.0f}%)\n'.format(test_loss, correct, len(test_loader.dataset), accuracy))return accuracydef main(args):use_cuda = not args['no_cuda'] and torch.cuda.is_available()torch.manual_seed(args['seed'])device = torch.device("cuda" if use_cuda else "cpu")kwargs = {'num_workers': 1, 'pin_memory': True} if use_cuda else {}data_dir = args['data_dir']train_loader = torch.utils.data.DataLoader(datasets.MNIST(data_dir, train=True, download=True,transform=transforms.Compose([transforms.ToTensor(),transforms.Normalize((0.1307,), (0.3081,))])),batch_size=args['batch_size'], shuffle=True, **kwargs)test_loader = torch.utils.data.DataLoader(datasets.MNIST(data_dir, train=False, transform=transforms.Compose([transforms.ToTensor(),transforms.Normalize((0.1307,), (0.3081,))])),batch_size=1000, shuffle=True, **kwargs)hidden_size = args['hidden_size']model = Net(hidden_size=hidden_size).to(device)optimizer = optim.SGD(model.parameters(), lr=args['lr'],momentum=args['momentum'])for epoch in range(1, args['epochs'] + 1):train(args, model, device, train_loader, optimizer, epoch)test_acc = test(args, model, device, test_loader)# report intermediate resultnni.report_intermediate_result(test_acc)logger.debug('test accuracy %g', test_acc)logger.debug('Pipe send intermediate result done.')# report final resultnni.report_final_result(test_acc)logger.debug('Final result is %g', test_acc)logger.debug('Send final result done.')def get_params():# Training settingsparser = argparse.ArgumentParser(description='PyTorch MNIST Example')parser.add_argument("--data_dir", type=str,default='./data', help="data directory")parser.add_argument('--batch_size', type=int, default=64, metavar='N',help='input batch size for training (default: 64)')parser.add_argument("--batch_num", type=int, default=None)parser.add_argument("--hidden_size", type=int, default=512, metavar='N',help='hidden layer size (default: 512)')parser.add_argument('--lr', type=float, default=0.01, metavar='LR',help='learning rate (default: 0.01)')parser.add_argument('--momentum', type=float, default=0.5, metavar='M',help='SGD momentum (default: 0.5)')parser.add_argument('--epochs', type=int, default=10, metavar='N',help='number of epochs to train (default: 10)')parser.add_argument('--seed', type=int, default=1, metavar='S',help='random seed (default: 1)')parser.add_argument('--no_cuda', action='store_true', default=False,help='disables CUDA training')parser.add_argument('--log_interval', type=int, default=1000, metavar='N',help='how many batches to wait before logging training status')args, _ = parser.parse_known_args()return argsif __name__ == '__main__':try:# get parameters form tunertuner_params = nni.get_next_parameter()logger.debug(tuner_params)params = vars(merge_parameter(get_params(), tuner_params))print(params)main(params)except Exception as exception:logger.exception(exception)raise

这篇关于AUTOML_NNI案例之 1.pytorch——minist 超参优化的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!