本文主要是介绍Hadoop-之配置LZO压缩完整手册,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Hadoop-之配置LZO压缩完整手册

1 前言

HADOOP本身除了GIP、DEFLATE、BZIP2等压缩之外是不支持LZO压缩的,所以我们加入需要让HDFS支持LZO(一种可切分的压缩形式,压缩率也很低)压缩,我们需要引入Twitter的Hadoop-LZO,参考地址为:https://github.com/twitter/hadoop-lzo/

2 hadoop-lzo的编译-构建与配置流程

2.1 环境准备

-

maven

- 下载安装,环境变量,修改阿里云镜像

-

gcc-c++

-

zlib-devel

-

autoconf

-

automake

-

libtool

#除了maven,其它的前提条件通过yum进行安装

yum -y install gcc-c++ lzo-devel zlib-devel autoconf automake libtool

2.1 下载安装并编译lzo

#step1

wget https://www.oberhumer.com/opensource/lzo/download/lzo-2.10.tar.gz#step2

tar -zxvf lzo-2.10.tar.gz -C /opt/module #step3

cd /opt/module/lzo-2.10#step4

./configure --enable-shared --prefix /usr/local/hadoop/lzo#step5

make

make install

2.2 编译hadoop-lzo源码

#step1 下载hadoop-lzo源码

wget https://github.com/twitter/hadoop-lzo/archive/master.zip#step2 解压,并修改配置pom.xml文件

<hadoop.current.version>2.7.7</hadoop.current.version>#step3 声明2个临时的环境变量

export C_INCLUDE_PATH=/usr/local/hadoop/lzo/include

export LIBRARY_PATH=/usr/local/hadoop/lzo/lib #step4 编译

cd /hadoop-lzo-master

mvn package -Dmaven.test.skip=true#step5 进入target目录

#hadoop-lzo 0.4.21-SNAPSHOT.jar就是编译成功的hadoop-lzo组件

pwd

>>>>>

/opt/module/hadoop-lzo-master/targetlS -ahl

>>>>>

drwxr-xr-x. 2 root root 4096 Jan 9 15:19 antrun

drwxr-xr-x. 4 root root 4096 Jan 9 15:20 apidocs

drwxr-xr-x. 5 root root 77 Jan 9 15:19 classes

drwxr-xr-x. 3 root root 25 Jan 9 15:19 generated-sources

-rw-r--r--. 1 root root 188965 Jan 9 15:19 hadoop-lzo-0.4.21-SNAPSHOT.jar

-rw-r--r--. 1 root root 180845 Jan 9 15:20 hadoop-lzo-0.4.21-SNAPSHOT-javadoc.jar

-rw-r--r--. 1 root root 52042 Jan 9 15:19 hadoop-lzo-0.4.21-SNAPSHOT-sources.jar

drwxr-xr-x. 2 root root 71 Jan 9 15:20 javadoc-bundle-options

drwxr-xr-x. 2 root root 28 Jan 9 15:19 maven-archiver

drwxr-xr-x. 3 root root 28 Jan 9 15:19 native

drwxr-xr-x. 3 root root 18 Jan 9 15:19 test-classes

2.3 将编译好的jar包放入hadoop的common目录下

cp hadoop-lzo-0.4.21-SNAPSHOT.jar /opt/module/hadoop-2.7.7/share/hadoop/common/

2.4 分发jar包到其它的节点

cd /opt/module/hadoop-2.7.7/share/hadoop/common/

xsync hadoop-lzo-0.4.21-SNAPSHOT.jar

2.4 配置core-site.xml文件,配置LZO,并分发

<!--vim core-site.xml-->

<!--配置hadoop的lzo压缩支持-->

<property><name>io.compression.codecs</name><value>org.apache.hadoop.io.compress.GzipCodec,org.apache.hadoop.io.compress.DefaultCodec,org.apache.hadoop.io.compress.BZip2Codec,org.apache.hadoop.io.compress.SnappyCodec,com.hadoop.compression.lzo.LzoCodec,com.hadoop.compression.lzo.LzopCodec</value>

</property>

<property><name>io.compression.codec.lzo.class</name><value>com.hadoop.compression.lzo.LzoCodec</value>

</property>

xsync core-site.xml

3 验证是否配置lzo成功

执行流程如下。

#step1 在本地创建一个文件test.txt

touch test.txt

echo mother fucker damn shit >> test.txt #step2 上传至hdfs

hadoop fs -mkdir /input

hadoop fs -put test.txt /input#step3 通过自带的mapreduce包执行wordcount命令如下,将结果输出到/output,需指定mapreduce的输出端压缩配置参数:mapreduce.output.fileoutputformat.compress=true mapreduce.output.fileoutputformat.compress.codec=com.hadoop.compression.lzo.LzopCodec

hadoop jar /opt/module/hadoop-2.7.7/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.7.jar wordcount -Dmapreduce.output.fileoutputformat.compress=true -Dmapreduce.output.fileoutputformat.compress.codec=com.hadoop.compression.lzo.LzopCodec /input /output

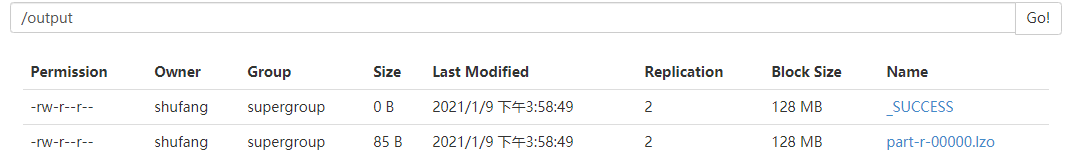

最终假如在HDFS的web端看到如下结果,说明lzo配置成功。切记

- 我们平常说的lzo压缩是使用com.hadoop.compression.lzo.LzopCodec

- 如果使用的是com.hadoop.compression.lzo.LzoCodec,那么生成的文件就是xx.lzo_deflate

4 LZO支持切片操作

参考地址:https://github.com/twitter/hadoop-lzo/#using-hadoop-and-lzo

如何让LZO文件支持切片,原生的.lzo文件之不支持切片的,我们需要通过hadoop的命令将某个文件建立切片索引,然后该lzo文件才能支持切片,建立索引的方式有2种

#方式1

hadoop jar /path/to/your/hadoop-lzo.jar com.hadoop.compression.lzo.LzoIndexer big_file.lzo#方式2

hadoop jar /path/to/your/hadoop-lzo.jar com.hadoop.compression.lzo.DistributedLzoIndexer big_file.lzo

因为切片的个数决定了Mapreduce任务的Maptask的个数,我们可以通过一个lzo文件分别在建立索引前后跑一下Mapreduce任务,查看job中的切片或者(map-task)的个数。

- 对比流程操作如下

# 建立索引之前的准备,准备一个超过128M的lzo文件,假如命名为part-r-00000.lzo,且在/input1目录下# 1 创建索引之前执行MR

hadoop jar /opt/module/hadoop-2.7.7/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.7.jar wordcount -Dmapreduce.job.inputformat.class=com.hadoop.mapreduce.LzoTextInputFormat /input1 /output1################################################################### 2 创建索引,然后执行MR

hadoop fs -rm -r /output1

#最终会为part-r-00000.lzo创建一个part-r-00000.lzo.index的索引文件,假如这个执行的参数为一个路径,那么会为路径下的每个lzo文件创建一个对应的.index索引。

hadoop jar /path/to/your/hadoop-lzo.jar com.hadoop.compression.lzo.DistributedLzoIndexer part-r-00000.lzohadoop jar /opt/module/hadoop-2.7.7/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.7.jar wordcount -Dmapreduce.job.inputformat.class=com.hadoop.mapreduce.LzoTextInputFormat /input1 /output1

- MR任务的日志信息显示样例

>>>>>>>#以下是跑MR任务的日志信息显示样例

21/01/10 19:34:10 INFO input.FileInputFormat: Total input paths to process : 1

21/01/10 19:34:10 INFO mapreduce.JobSubmitter: number of splits:1#切片个数Job CountersLaunched map tasks=1 #map task的个数

这篇关于Hadoop-之配置LZO压缩完整手册的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!