reformer专题

REFORMER: 更高效的TRANSFORMER模型

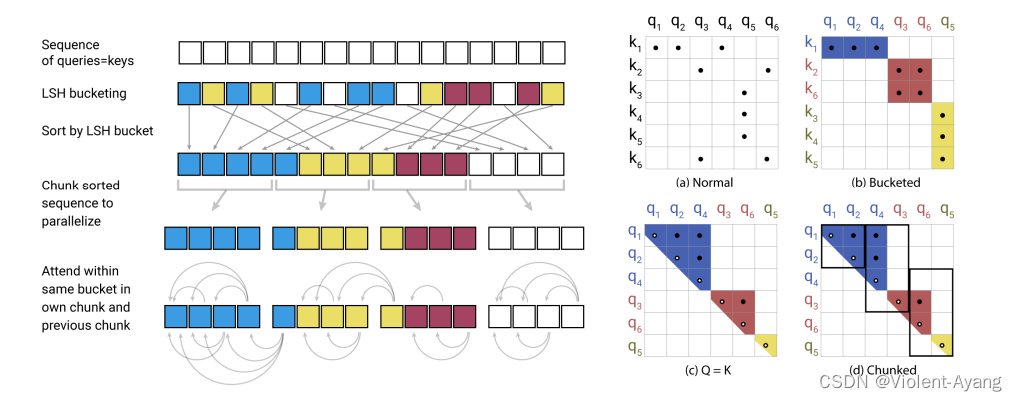

大型Transformer模型通常在许多任务上都能达到最先进的结果,但是训练这些模型的成本可能会非常高昂,特别是在处理长序列时。我们引入了两种技术来提高Transformer的效率。首先,我们用一种使用局部敏感哈希的点积注意力替换了原来的点积注意力,将其复杂度从O(L^2)改变为O(L log L),其中L是序列的长度。此外,我们使用可逆的残差层代替了标准残差,这允许在训练过程中只存储一次激活,而

sift计算效率优化_Transformer家族3 -- 计算效率优化(Adaptive-Span、Reformer)

Transformer家族3 -- 计算效率优化(Adaptive-Span、Reformer、Lite-Transformer) 1 背景 上文我们从编码长度优化的角度,分析了如何对Transformer进行优化。Transformer-XL、LongFormer等模型,通过片段递归和attention稀疏化等方法,将长文本编码能力提升到了很高的高度。基本已经克服了Transforme