本文主要是介绍Linux下Hadoop的安装(单机版),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

1.安装前准备

1.1创建hadoop用户

sudo addgroup hadoop #添加hadoop用户组

sudo adduser --ingroup hadoop hduser #在hadoop用户组中添加hduser1.2下载hadoop安装程序

- tar -zxvf hadoop-1.0.4.tar.gz

1.3安装ssh

- ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

- cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

第一步,在https://launchpad.net/ubuntu/lucid/i386/openssh-client/1:5.3p1-3ubuntu3

下载文件并安装:$ sudo dpkg -i openssh-client_5.3p1-3ubuntu3_i386.deb

第二步,在https://launchpad.net/ubuntu/lucid/i386/openssh-server/1:5.3p1-3ubuntu3

下载文件并安装:$ sudo dpkg -i openssh-server_5.3p1-3ubuntu3_i386.deb

第三步,在https://launchpad.net/ubuntu/lucid/i386/ssh/1:5.3p1-3ubuntu3

下载文件并安装:$ sudo dpkg -i ssh_5.3p1-3ubuntu3_all.deb

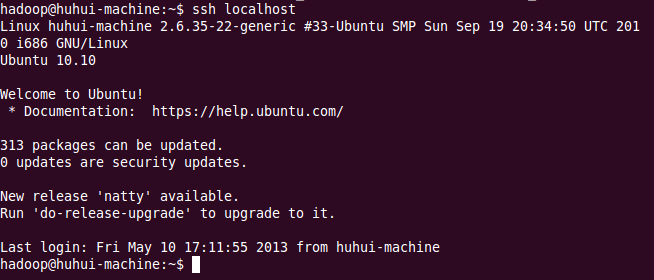

验证ssh免登录是否配置成功:

- ssh localhost

方法二:

- #生成公钥和私钥

- ssh-keygen -q -t rsa -N "" -f ~/.ssh/id_rsa

- cd .ssh

- cat id_rsa.pub > authorized_keys

- chmod go-wx authorized_keys

出现如下信息,则说明ssh免登录配置成功:

1.6安装并配置JDK

2.安装并配置单机版Hadoop

2.1修改hadoop-env.sh

- vi conf/hadoop-env.sh

- JAVA_HOME=/home/hadoop/software/jdk1.6.0_21

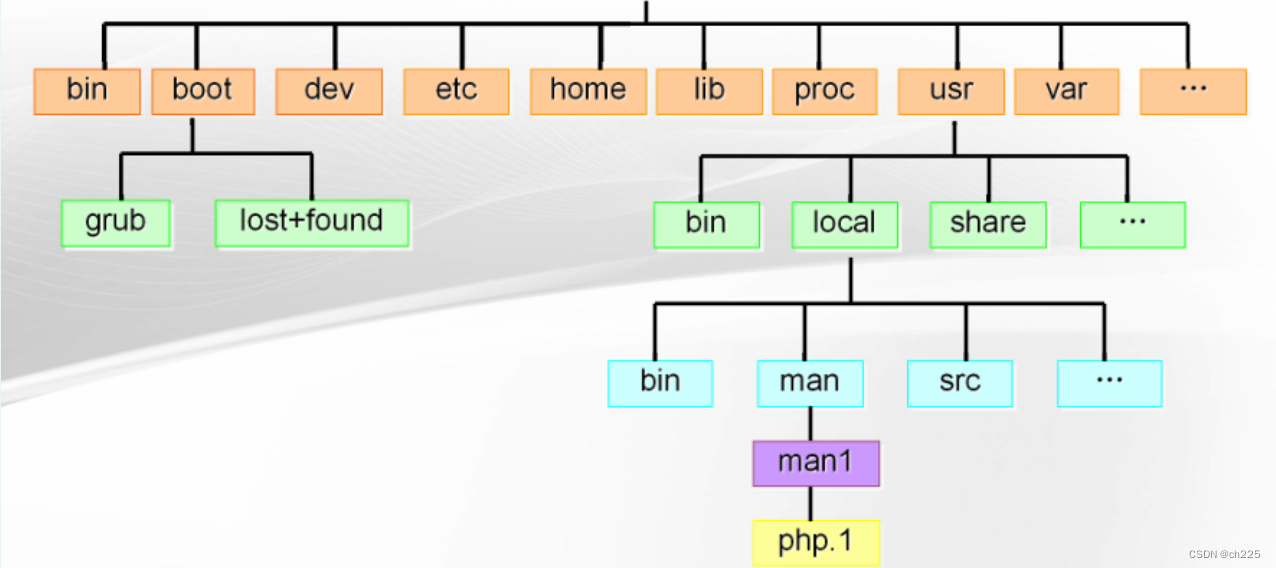

2.2修改hadoop的核心配置文件core-site.xml(针对hadoop-2.2.0版本,在hadoop-2.2.0/etc/hadoop/目录下),配置HDFS的地址和端口号

- vi conf/core-site.xml

- <configuration>

- <property>

- <name>fs.default.name</name>

- <value>hdfs://localhost:9000</value>

- </property>

- </configuration>

2.3修改hadoop中HDFS的配置(针对hadoop-2.2.0版本,在hadoop-2.2.0/etc/hadoop/目录下)

- vi conf/hdfs-site.xml

- <configuration>

- <property>

- <name>dfs.replication</name>

- <value>1</value>

- </property>

- </configuration>

2.4修改hadoop中MapReduce的配置文件(针对hadoop-2.2.0版本,在hadoop-2.2.0/etc/hadoop/目录下),配置的是JobTracker的地址和端口

- vi conf/mapred-site.xml

- <configuration>

- <property>

- <name>mapred.job.tracker</name>

- <value>localhost:9001</value>

- </property>

- </configuration>

2.5格式化一个新的分布式文件系统

- bin/start-all.sh

3.验证Hadoop是否安装成功

- HDFS的web页面: - http://localhost:50070/

- MapReduce的web页面: - http://localhost:50030/

3.1运行WordCount例子

- ./hadoop fs -mkdir /input

- ./hadoop fs -put start-all.sh /input

- bin/hadoop jar hadoop-examples-1.0.4.jar wordcount /input /output

这篇关于Linux下Hadoop的安装(单机版)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!